Steeds meer medewerkers worden geconfronteerd met het gebruik van data in hun dagelijkse werkzaamheden. Daarom moeten zij ‘data literate’ worden en over een ‘data skills set’ beschikken om data goed te prepareren, te begrijpen en uiteindelijk visueel te presenteren. Zij moeten met data dus kunnen ‘praten’. Tools waarbij ‘normale vraagstellingen ’of Natural Language Processing (NLP), worden gebruikt, maken het nog eenvoudiger deze ‘dataconversatie’ natuurlijker te laten verlopen. De tool Ask Data van visual analytics-specialist Tableau is hiervan een sprekend voorbeeld.

Data is tegenwoordig, als we elke willekeurige IT-leverancier of -specialist moeten geloven het nieuwe goud of de nieuwe olie. Afgezien van de waarde die data zelf vertegenwoordigd, moet data er ook voor zorgen dat bedrijven en organisaties meer ‘data driven’ worden en zo meer kunnen innoveren.

Dit kan alleen als ook de medewerkers binnen deze bedrijven en organisaties niet alleen de waarde van de diverse gegenereerde en verzamelde gegevens inzien, maar ook weten hoe zij deze gegevens op waarde moeten schatten, kunnen interpreteren en uiteindelijk ook visualiseren en presenteren om hieruit het maximale uit te kunnen halen. Dit betekent dat medewerkers zelf tegenwoordig steeds meer ‘data literate’ moeten zijn.

Gesprek met data aangaan

Concreet wordt onder ‘data literacy’ de capaciteit van individuele mensen verstaan om data te kunnen manipuleren, te analyseren en interpreteren en deze te delen. En natuurlijk uiteindelijk op basis van dit alles beslissingen te nemen. Kortom, ze moeten zich een bepaalde ‘skill set’ aanmeten waardoor ze met data kunnen ‘interacteren’ ‘of ‘in gesprek gaan’.

Dit gesprek met data door individuele medewerkers is erg belangrijk omdat deze groep eindgebruikers vaak de eigenaar van de data is en zij ook de waarde ervan dus kunnen inschatten voor hun verdere werkzaamheden. Zij kunnen eigenlijk veel makkelijker doorvragen op deze data en zo veel meer te weten komen. Dit heeft uiteindelijk allemaal sneller en vaak beter resultaat dan dat zij deze data en interpretaties van elders moeten halen. Bijvoorbeeld van IT-afdelingen waar de echte expertise natuurlijk anders is en vaak dan ook niet het complete beeld levert. Het is dus het beste als de individuele medewerkers vanuit hun eigen werkzaamheden en het daarbij behorende denkproces zelf met deze data kunnen werken, begrijpen en ook daadwerkelijk toepassen.

Opkomst Natural Language Processing

In hun gesprek met data worden eindgebruikers tegenwoordig steeds vaker geholpen met nieuwe methoden die dit proces nog meer moeten vergemakkelijken. Eén van de methoden die hier vaak bij opduikt, is het zogeheten Natural Language Processing (NLP). Deze technologie, die al vanaf de jaren ’50 van de vorige eeuw in ontwikkeling is, draait om de interacties tussen computers en menselijke of ‘natuurlijke’ talen. Hierbij moeten computersystemen zodanig worden geprogrammeerd om grote hoeveelheden door natuurlijke taal gegenereerde gegevens te verwerken en te genereren.

Voordelen

De meerwaarde van NLP komt uit de eigenschap van deze technologie om in een zeer korte periode grote hoeveelheden datasets te kunnen doorzoeken en daarbij uitkomsten te vinden die mogelijk een overeenkomst hebben met een menselijke uitdrukking. Hierdoor kan data weer veel sneller in verschillend sets worden uitgesplitst en op overeenkomsten worden onderzocht, zonder dat medewerkers eindeloos allerlei filteropties moeten gebruiken.

Door NLP met kunstmatige intelligentie, machine learning, te combineren, kunnen nog grotere datasets worden geanalyseerd. Op deze manier weet een oplossing voor data analytics bij een vraagstelling over de gemiddelde prijs van een product in een bepaalde regio, dat het niet alleen de prijs van het product moet laten zien, maar ook moet aangeven in welke regio deze prijs wordt gehanteerd en dat dit een gemiddelde moet zijn.

Andere voordelen van het gebruik van NLP om het ‘gesprek’ met data aan te gaan, zijn onder meer het interpreteren van taal en het oplossen van dubbele gegevens in datasets die voldoende duidelijkheid geven. Ook kunnen nieuwe ontwikkelingen als ‘conversational analytics’ worden ingezet. Kortom, NLP maakt het mogelijk om computersystemen niet alleen te laten begrijpen wat we ‘zeggen’, maar ook steeds beter te laten weten wat we er mogelijk mee bedoelen.

Integratie NLP

Het is dan natuurlijk ook niet helemaal gek dat leveranciers van tools voor visuele data-analysemogelijkheden, NLP in hun producten integreren. Zo ook de zeer recent door het CRM-monsterbedrijf Salesforce overgenomen visual analystics-specialist Tableau. Eerder dit jaar schreven we al over het platform van deze specialist die het echt ‘in gesprek gaan met data’ door eindgebruikers al langer als basis heeft.

Met Tableau, eigenlijk meer een zeer geavanceerde interface met de diverse verbonden databronnen, hebben eindgebruikers de mogelijkheid om te blijven ‘doorvragen’, deze data in beeld te brengen en deze in realtime te kunnen analyseren en zo tot nieuwe inzichten of beslissingen te komen.

Vragen stellen aan data

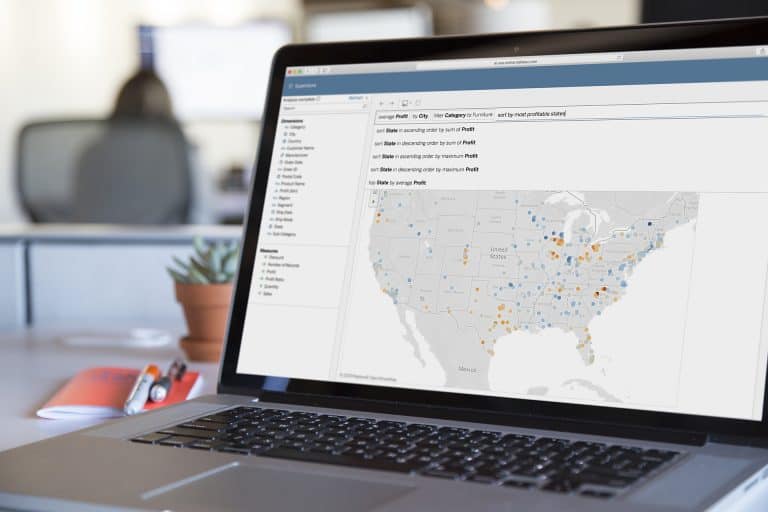

Om dit doorvragen nog beter te kunnen uitvoeren, heeft de specialist begin dit jaar de tool ‘Ask Data’ definitief aan het platform toegevoegd. De tool, die al sinds het einde van 2018 in een bèta-versie beschikbaar was, is gebaseerd op NLP en maakt het eindgebruikers mogelijk om, nu nog alleen in het Engels, getypte vragen te stellen aan het platform. Het platform geeft hierop een visualisatie van de opgevraagde data als antwoord.

Gebruikers kunnen hiermee de data verder onderzoeken door de gestelde vraag verder aan te scherpen en op die manier dieper op details door te vragen. Hiervoor hebben zij dus geen verdere diepgaande kennis nodig van de structuur van de te doorzoeken data of programmeren, maar alle functionaliteit van het Tableau-platform helpt hen vervolgens verder.

Ask Data onder de motorkap

Wanneer we dieper naar de geavanceerde NLP-algoritmes onder de motorkap van Ask Data kijken, zijn deze volledig op de intentie van de eindgebruikers gericht en niet op sleutelwoorden. Zo worden databronnen automatisch geprofileerd en geïndexeerd, zodat de software weet wat iemand eigenlijk precies bedoelt als hij iets in een vraag intypt. Hierbij wordt statistische kennis gekoppeld met contextuele kennis van echt bestaande concepten.

Bovendien herkennen de Ask Data-algoritmes synoniemen waardoor we nog weer scherpere inzichten krijgen. Om een voorbeeld te stellen: naast het woord ‘verkopen’ kunnen ook tegelijkertijd woorden als winst, inkomsten of verdiensten aan de vraag worden toegevoegd, waardoor de tool ‘weet’ welke informatie hij moet presenteren.

Combinatie met eerder gebruikte activiteiten

Verder is de tool ook voorbereid op meer dubbelzinnig of vaag taalgebruik dat ervoor zorgt dat gestelde vragen op meerdere manieren kunnen worden geïnterpreteerd. Eén van de lastige kwesties voor NLP dus. Wanneer dit het geval is, combineert de tool van Tabelau de informatie van de gebruikte databron met eerdere gebruiksactiviteit -dus eerder gestelde vragen aan deze specifieke data- en geeft hiervoor vervolgens automatisch een aantal aanbevelingen voor handige toegevoegde zoekopties. Eindgebruikers kunnen deze dan aan hun vraag toevoegen, zodat zij uiteindelijk nog meer gespecificeerde informatie krijgen. Vanzelfsprekend kan hierbij worden gewerkt met alle door Tableau ondersteunde databronnen.

De tool zorgt er uiteindelijk voor dat eindgebruikers, op basis van best practices, de juiste vormen kunnen selecteren om de gevonden data uiteindelijk visueel te presenteren. Voor financiële data kan dit dan bijvoorbeeld een bepaalde chart zijn waarbij negatieve cijfers automatisch in rood worden uitgelicht of wordt geografische informatie op een kaart geprojecteerd.

Verdere uitbreidingen Ask Data-functionaliteit

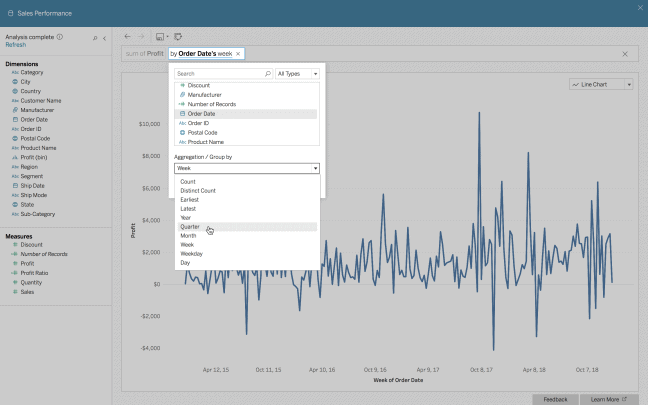

In de loop van dit jaar zijn de capaciteiten van dit NLP-tool van Tableau nog verder uitgebreid. Zo is het nu mogelijk om op basis van getypte commando’s automatisch berekeningen te laten uitvoeren. Verder zorgt een nieuwe userinterface ervoor dat eindegebruikers nog betere ‘gesprekservaringen’ hebben als zij dieper hun data in gaan.

Onlangs werd tijdens de gebruikersconferentie van Tableau aangekondigd dat Ask Data ook kan worden geïntegreerd in interne portal-omgevingen of Wiki’s van bedrijven en organisaties, zodat steeds meer medewerkers vragen aan de bedrijfsdata kunnen stellen, deze kunnen visualiseren en delen.

Daarnaast wordt er nu aan nieuwe features voor Tableau gewerkt die op de Ask Data-functionaliteit lijken te zijn gebaseerd. Met de op dit moment in een bètafase bevindende Explain Data-functionaliteit moeten eindgebruikers straks de verklaring kunnen ‘vragen’ achter onverwachte uitkomsten die uit de geanalyseerde data naar voren komen. De tool zoekt met behulp van kunstmatige intelligentie in honderden statistische verklaringen naar het juiste antwoorden. Deze verklaringen worden visueel weergegeven en zijn met de volledige functionaliteit van Tableau weer verder doorzoekbaar. Hierdoor ontdekken eindgebruikers, aldus de leverancier, sneller onverwachte inzichten en kunnen zij hiervoor gemakkelijker verklaringen krijgen.

NLP-functionaliteit is interessante ontwikkeling

Samenvattend constateren we dat met de komt van NLP het voor eindgebruikers steeds eenvoudiger gaat worden om echt te gaan ‘praten’ met hun data. Deze conversatie wordt zo intuïtiever en natuurlijker. Dit betekent weer dat de drempel voor het communiceren met data wordt verlaagd en dus steeds meer medewerkers in staat zullen zijn om relevante inzichten op basis van data te krijgen.

De komst van tools als Ask Data zorgt er tevens voor dat dit soort data-tools op basis van selfservice nog makkelijker bruikbaar worden voor iedere medewerker. Hierdoor gaat de ‘data literacy’ weer omhoog en kunnen bedrijven en organisaties op hun beurt weer sneller en eenvoudiger ‘data driven’ worden.

Op deze manier snijdt de komst van een meer intelligente interactie met data natuurlijk aan twee kanten; snellere inzichten en meer deskundige eindgebruikers. We zijn daarom benieuwd welke mogelijkheden voor deze interactie met data, onder meer met de inzet van NLP en natuurlijk ook kunstmatige intelligentie, zich in de (nabije) toekomst gaan voordoen.