Nvidia zet de code voor zijn parser en plug-ins voor TensorRT op Github. Het bedrijf hoopt op enthousiasme van de ontwikkelaarsgemeenschap om bij te dragen aan het opensource-project.

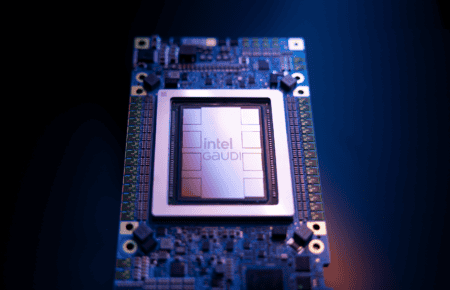

De code voor zowel de parser als de plugins voor TensorRT is voortaan opensource. Nvidia plaatste al de assets online in een github-repository. TensorRT is Nvidia’s AI-inferentiesysteem. De gpu-fabrikant rust zijn grafische kaarten sinds de introductie van de RTX-reeks uit met Tensor-kernen, geoptimaliseerd voor AI-workflows. De publiek gemaakte TensorRT-code is daarop gericht, en heeft dus niet te maken met training.

Hardware eerst

De job van de parser is om vooraf getrainde modellen voor inferentie te importeren in de accelerator, terwijl de plugins het mogelijk maken om nieuwe operaties of toepassingen aan de hardware te koppelen. Nvidia wil natuurlijk graag dat ontwikkelaars de TensorRT-hardware omarmen en wil het hen zo eenvoudig mogelijk maken. Als zij enthousiast zijn en hun apps voor TensorRT bouwen, wil dat immers zeggen dat de uiteindelijke toepassingen op Nvidia zullen draaien. Hardware blijft de core business van het bedrijf, niet software.

Het is dan ook lang niet de eerste keer dat Nvidia code opensource maakt. Nvidia heeft meer dan 120 repositories online staan en draagt actief bij aan opensource deep learning-projecten. De AI-specialist nodigt de gemeenschap uit om bij te dragen aan de code en plant toevoegingen te mergen bij elke nieuwe release.