GenAI en grote taalmodellen (LLM’s) worden in verschillende sectoren steeds meer toegepast. Ze verhogen de productiviteit, versterken de concurrentiepositie en dragen positief bij aan bedrijfsresultaten. Naarmate deze technologieën dieper geïntegreerd raken in essentiële bedrijfsprocessen en besluitvorming, neemt ook het risico op misbruik toe. Eén van de opkomende dreigingen is het gebruik van zogeheten prompt-attacks: aanvallen waarbij kwaadwillenden subtiele kwetsbaarheden uitbuiten om de modeluitvoer te manipuleren. Hoewel deze techniek relatief nieuw is, ontwikkelt het zich snel en wordt het steeds verfijnder. Voor bedrijfsleiders, ontwikkelaars en beveiligingsprofessionals is inzicht in prompt-attacks dan ook van essentieel belang. In dat kader delen we nieuw onderzoek dat een praktisch raamwerk biedt om deze aanvallen beter te begrijpen – en om AI-systemen beter te beschermen.

Uit het onderzoek blijkt dat toonaangevende LLM’s nog altijd kwetsbaar zijn voor prompt-attacks. Sommige aanvallen bereiken zelfs een slagingspercentage tot 88% – een alarmerend hoog niveau dat aanzienlijke risico’s met zich meebrengt voor organisaties die AI gebruiken. Het rapport onderstreept dan ook de noodzaak van diepgaand inzicht in deze vorm van dreiging. Als antwoord presenteert het rapport een helder en gestructureerd classificatiesysteem van zowel bekende als opkomende vormen van prompt-aanvallen. Dit framework stelt organisaties in staat om risico’s systematisch in kaart te brengen, gerichte verdedigingsstrategieën te formuleren en de weerbaarheid van generatieve AI-systemen tegen manipulatie aanzienlijk te vergroten.

Nieuwe vormen van GenAI prompt-aanvallen

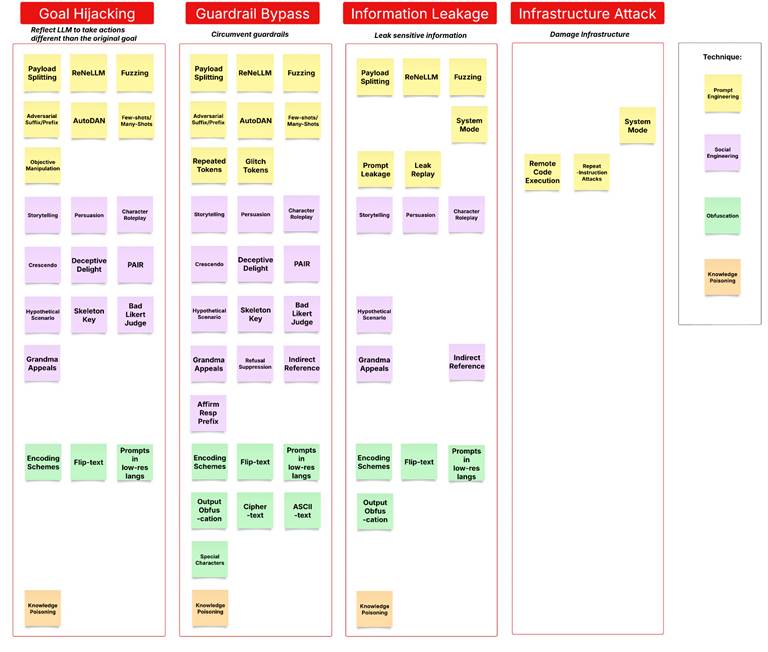

In ons rapport introduceren we een classificatiesysteem waarin alle geïdentificeerde prompt-aanvallen worden onderverdeeld in vier hoofdcategorieën, op basis van hun impact. Deze indeling dient als praktische leidraad voor beveiligingsteams om prompt-aanvallen effectief te herkennen, te beperken en te voorkomen. De vier categorieën zijn als volgt:

- Goal Hijacking – Hackers sturen het model zodanig aan dat het zijn oorspronkelijke doel verliest. Vaak gebeurt dit door kwaadaardige instructies te vermommen als ogenschijnlijk onschuldige of verhalende prompts. Hierdoor genereert het model onbedoelde of potentieel schadelijke antwoorden.

- Guardrail Bypass – In deze categorie weten aanvallers beveiligingsmaatregelen te omzeilen, zoals systeemprompts, inputfilters of beperkingen in trainingsdata. Dit kan bijvoorbeeld via technieken als obfuscatie, steganografie of misbruik van plug-inrechten. Zo ontstaat ruimte voor het genereren van ongewenste content of het uitvoeren van schadelijke scripts.

- Information Leakage – Deze aanvallen zijn gericht op het ontfutselen van gevoelige informatie, zoals systeemprompts, interne configuraties of bedrijfseigen trainingsdata. Daarbij wordt gebruikgemaakt van verkennende technieken, zoals replay-aanvallen of systematisch uitvragen van historische contexten, om vertrouwelijke informatie bloot te leggen.

- Infrastructure Attack – Hierbij worden prompts doelbewust ontworpen om systeembronnen te overbelasten of ongeautoriseerde code uit te voeren. Denk aan het uitlokken van intensieve rekenprocessen of het injecteren van commando’s die externe code activeren – wat de stabiliteit en integriteit van de gehele AI-infrastructuur kan ondermijnen.

Deze voorgestelde classificatie verschilt van andere classificaties gebaseerd op technieken, zoals prompt engineering, social engineering, obfuscation en knowledge poisoning. De reden hiervoor is dat technieken in de loop van de tijd evolueren. Dit maakt het essentieel om te focussen op hun bredere implicaties. Zo kan elke techniek bijdragen aan een of meer van de hierboven genoemde impactcategorieën. Daarom zijn voor de meeste AI-professionals de gevolgen van snelle aanvallen veel belangrijker dan de technieken zelf.

Figuur 1 geeft een overzicht van meer dan 30 technieken voor snelle aanvallen en hun respectievelijke impactcategorieën, en laat zien hoe verschillende methoden tot specifieke beveiligingsrisico’s leiden. Onze bevindingen bevestigen dat deze classificatie effectief het volledige spectrum van vijandige prompt-attacks omvat en een gestructureerd kader biedt voor het begrijpen en beperken van deze evoluerende dreigingen.

Je bedrijf beschermen tegen opkomende risico’s

Om zowel bestaande als nieuwe prompt-attacks effectief te herkennen en te voorkomen, moeten organisaties een holistische, gelaagde beveiligingsstrategie voor GenAI-systemen implementeren. De belangrijkste verdedigingsmechanismen moeten worden afgestemd op elke categorie van vijandige snelle aanvallen en samenwerken in een gelaagde verdediging. Hieronder volgen enkele voorbeelden van afweermechanismen per aanvalscategorie:

- Goal Hijacking Mitigatie – Aanvallers gebruiken deze aanval vaak in een poging om eerdere instructies te overstemmen en het model te manipuleren om onbedoelde taken uit te voeren. Mitigatie vereist het implementeren van input-level guardrails om manipulatie van vijandige prompts te detecteren en te blokkeren, inclusief social engineering-technieken en tekstversluiering die het gedrag van het model proberen te veranderen.

- Guardrail Bypass Preventie – Aangezien er voortdurend nieuwe technieken voor jailbreak opduiken, is het onderhouden van een adaptief en actueel beveiligings framework voor LLM prompts essentieel. Een robuust guardrail-systeem moet voortdurend pogingen monitoren en voorkomen die erop gericht zijn systeembeperkingen te omzeilen, het geheugen van de agent te manipuleren of kwetsbaarheden in het model te misbruiken.

- Verdediging tegen informatielekken – Bescherming tegen exfiltratie van data vereist meerdere beveiligingslagen. Invoer- en uitvoerfilters moeten gevoelige informatie detecteren en voorkomen, zoals PII, PHI of bedrijfseigen data. Daarnaast moeten promptlekkage en replay-attack worden beperkt door systeemprompts en trainingsdata te beveiligen. AI-agent workflows moeten ook worden beveiligd om ongeautoriseerde extractie en gebruik van tools te voorkomen.

- Preventie van Infrastructure Attacks – Om GenAI-systemen te beschermen tegen infrastructuurbedreigingen is een combinatie van traditionele applicatiebeveiliging en AI-specifieke bescherming nodig. Aanvallen waarbij prompts herhaaldelijk worden uitgevoerd, moeten worden geblokkeerd door de detectie van vijandelijke prompts, terwijl inputs en outputs moeten worden gescand op schadelijke payloads, waaronder schadelijke URL’s en malware. Verder is het controleren van gebruikersinvoer op ongeautoriseerde toegang tot back-end tools cruciaal bij het tegengaan van uitbuiting van AI-agenten.

Door deze strategieën toe te passen, kunnen organisaties hun GenAI-systemen versterken tegen snelle aanvallen van tegenstanders, wat zorgt voor een veerkrachtige en betrouwbare werking in de praktijk.

Toekomstbestendigheid van een GenAI-beveiligingsstrategie

De voordelen van GenAI zullen een positieve impact hebben voor elk bedrijf dat deze vooruitstrevende technologie toepast. Maar om deze impact te zien, moet de technologie vanaf het begin veilig worden geïmplementeerd. Daarom is het essentieel dat belanghebbenden in het GenAI-ecosysteem zich proactief verdedigen tegen snelle aanvallen en de beveiliging van hun systemen, netwerken en data verbeteren. Daarin kan iedereen een rol vervullen:

- GenAI-ontwikkelaars moeten veiligheid integreren in elke fase van het ontwerp- en ontwikkelproces, en hun systemen rigoureus testen vóór implementatie. Door diepgaand inzicht te hebben in aanvalstechnieken en hun impact, kunnen zij robuuste en veerkrachtige oplossingen bouwen die bestand zijn tegen toekomstige dreigingen.

- GenAI-gebruikers, met name bedrijven, dragen verantwoordelijkheid voor het bewust omgaan met risico’s van vijandige prompt-aanvallen. Door waakzaam te zijn en gegenereerde output kritisch te evalueren, kunnen zij beveiligingsrisico’s beperken en onbedoelde gevolgen voorkomen.

- Systeembeheerders en informatiebeveiligingsprofessionals moeten de aard en variëteit van prompt-aanvallen begrijpen om het beveiligingsbeleid gericht te versterken. Door GenAI-systemen continu te evalueren, strikte toegangscontroles te hanteren en snel te reageren op nieuwe dreigingen, dragen zij bij aan een weerbare AI-omgeving.

Om organisaties hierin te ondersteunen, biedt Palo Alto Networks geavanceerde beveiligingsoplossingen die speciaal zijn ontwikkeld voor het beschermen van GenAI-systemen:

- AI Runtime Security is een adaptieve, doelgerichte oplossing die de gehele enterprise applicatie- en agent-stack, inclusief modellen en data opspoort, beschermt en beveiligt tegen AI-specifieke en fundamentele netwerk-dreigingen.

- AI Access Security biedt uitgebreide zichtbaarheid en controle over het gebruik van GenAI in bedrijven, detecteert potentiële risico’s op blootstelling van data en versterkt de algehele beveiliging.

Door deze beveiligingsmaatregelen te implementeren, kunnen organisaties met vertrouwen profiteren van de mogelijkheden van GenAI, terwijl zij tegelijkertijd de risico’s van snel evoluerende aanvallen tot een minimum beperken.

De inzichten die voortkomen uit ons onderzoek zijn niet slechts observaties, maar een duidelijke oproep tot actie. Een effectieve GenAI-beveiligingsstrategie moet het volledige ecosysteem omvatten: van modellen en data tot applicaties en AI-agenten.

Dit is een ingezonden bijdrage van Palo Alto Networks. Via deze link vind je meer informatie over de mogelijkheden van het bedrijf.