Google’s Vertex AI-platform had een tweetal ernstige kwetsbaarheden. Deze maakten het mogelijk om toegang te krijgen tot de LLM’s van klanten en om ze te vervangen met kwaadaardige varianten.

Dit ontdekte Palo Alto Networks’ Unit 42-onderzoeksteam. Google Vertex AI bevatte een tweetal kwetsbaarheden. De eerste hiervan betrof een escalatie van privileges. Door zogenoemde ‘custom job-permissies’ te misbruiken konden de hackers de benodigde privileges makkelijk escaleren. Hierdoor verkregen zij toegang alle datadiensten van klanten binnen hun ontwikkelprojecten.

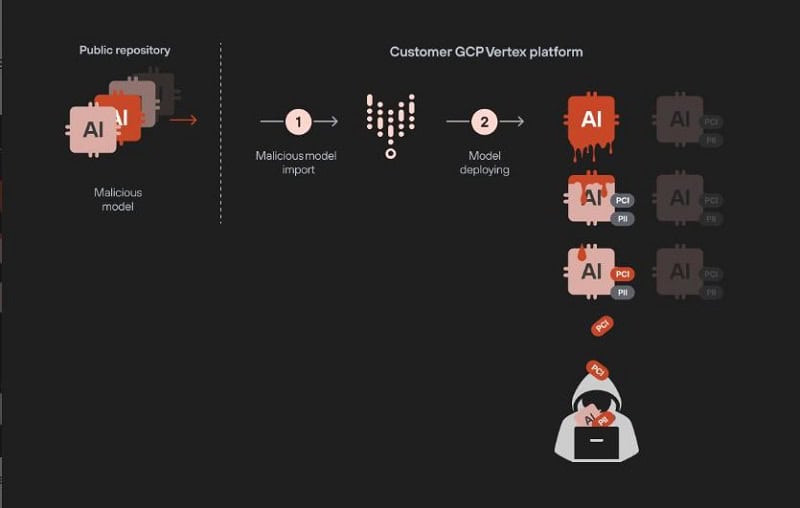

De tweede door Unit42 geconstateerde kwetsbaarheid was een fout die het hackers mogelijk maakte zelf een kwaadaardige LLM binnen Google Vertex AI up te loaden. Hiermee konden zij vervolgens data van alle andere (klantgebonden) gefinetunde LLM’s stelen. Deze laatste kwetsbaarheid vormde daardoor een groot risico voor het stelen van bedrijfseigen en gevoelige data, stellen de onderzoekers.

Strengere controleregels nodig

Google heeft inmiddels het lek gedicht. In een afsluitend commentaar stelt Unit42 dat deze kwetsbaarheden de grote risico’s aantonen wanneer bijvoorbeeld een enkel kwaadaardig LLM in dit soort omgevingen wordt uitgerold.

De onderzoekers vinden het daarom belangrijk dat er strengere controleregels komen voor de uitrol van LLM’s. Fundamenteel is daar bij het scheiden van de ontwikkel- en testomgevingen en de uiteindelijke live productie-omgevingen. Dit reduceert de risico’s dat hackers mogelijk onveilige LLM’s kunnen uitrollen, voordat deze strikt zijn beoordeeld.

Daarnaast moeten LLM’s die van interne teams of van derde partijen afkomstig zijn, altijd goed worden gevalideerd voordat zij daadwerkelijk worden uitgerold.

Lees ook: Hugging Chat Assistants te misbruiken voor data-exfiltratie