Nvidia komt met nieuwe AI-modellen en -systemen waarmee klanten AI-werkzaamheden makkelijker en sneller kunnen uitvoeren. Toegevoegde mogelijkheden zijn de komst van het gigantische NeMo Megatron AI-trainingsmodel, een upgrade voor de Triton-serveroplossing en de introductie van Modulus.

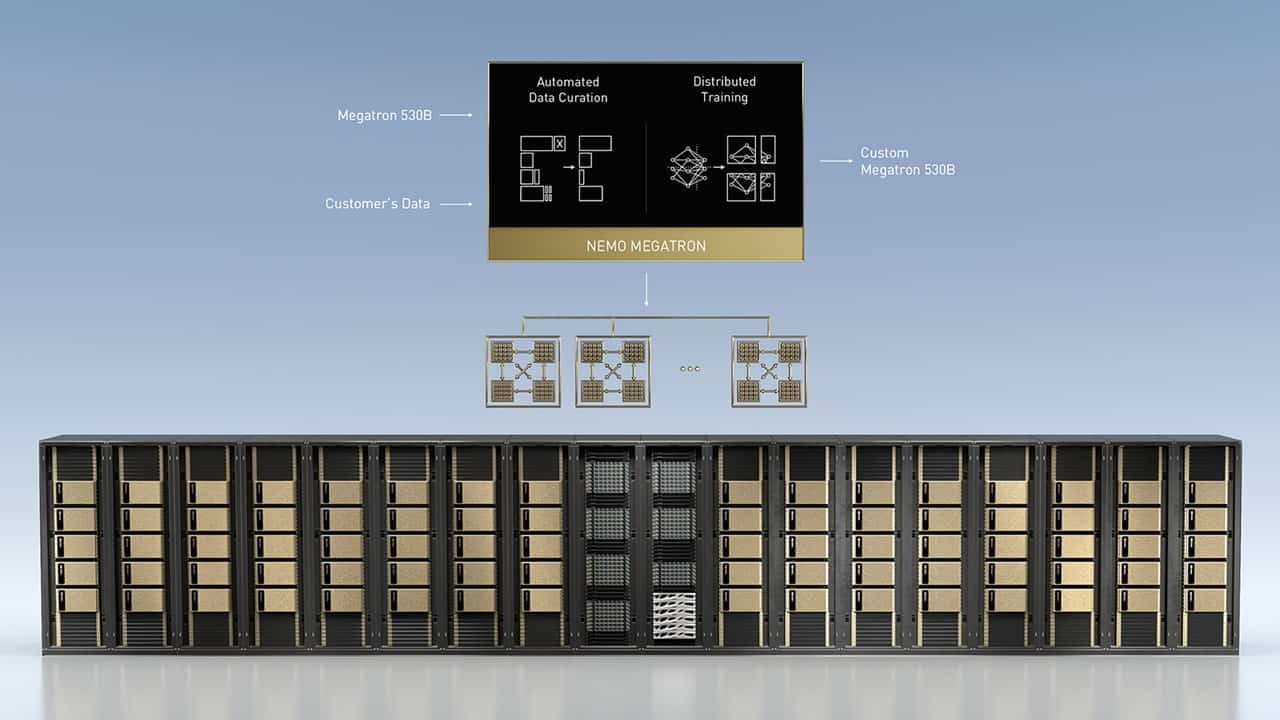

Eén van de belangrijkste aankondigingen is de beschikbaarheid van het AI-framework NeMO Megatron 538B. Dit framework is gebaseerd op Megatron open-source framework dat biljoenen parameters bevat voor het trainen van natural language AI-modellen.

Met NeMO Megatron 538B kunnen bedrijven zelf het framework aanpassen voor het trainen van eigen op natural language gebaseerde AI-modellen. Het platform distribueert alle trainingswerkzaamheden over meerdere GPU’s. Hierdoor is het mogelijk de complexiteit van large language models (LLM’s)-training te verminderen en sneller te laten verlopen.

Daarnaast kan het framework op grote schaal binnen de eigen infrastructuur of in de (public) cloud worden uitgerold met behulp van de onderliggende DGX SuperPOD-infrastructuur. Nvidia beschouwt de beschikbaarheid van dit grote AI-trainingsframework als de grootste HPC-oplossing ooit uitgebracht.

Update Triton Inference Server

Naast de komst van het Megatron 530B AI-framework heeft Nvidia ook zijn Triton Inference Server van nieuwe functionaliteit voorzien. Onder meer met nieuwe multi-GPU- en multinode-features om LLM inference workloads over verschillende GPU’s en nodes te schalen met realtime prestaties. Hierdoor kan het Megatron 530B AI-trainigsframework op twee DGX-systemen draaien voor het beperken van de verwerkingssnelheid op CPU’s gebaseerde servers. Hierdoor is het mogelijk LLM’s uit te rollen naar realtime applicaties.

Introductie Nvidia Modulus

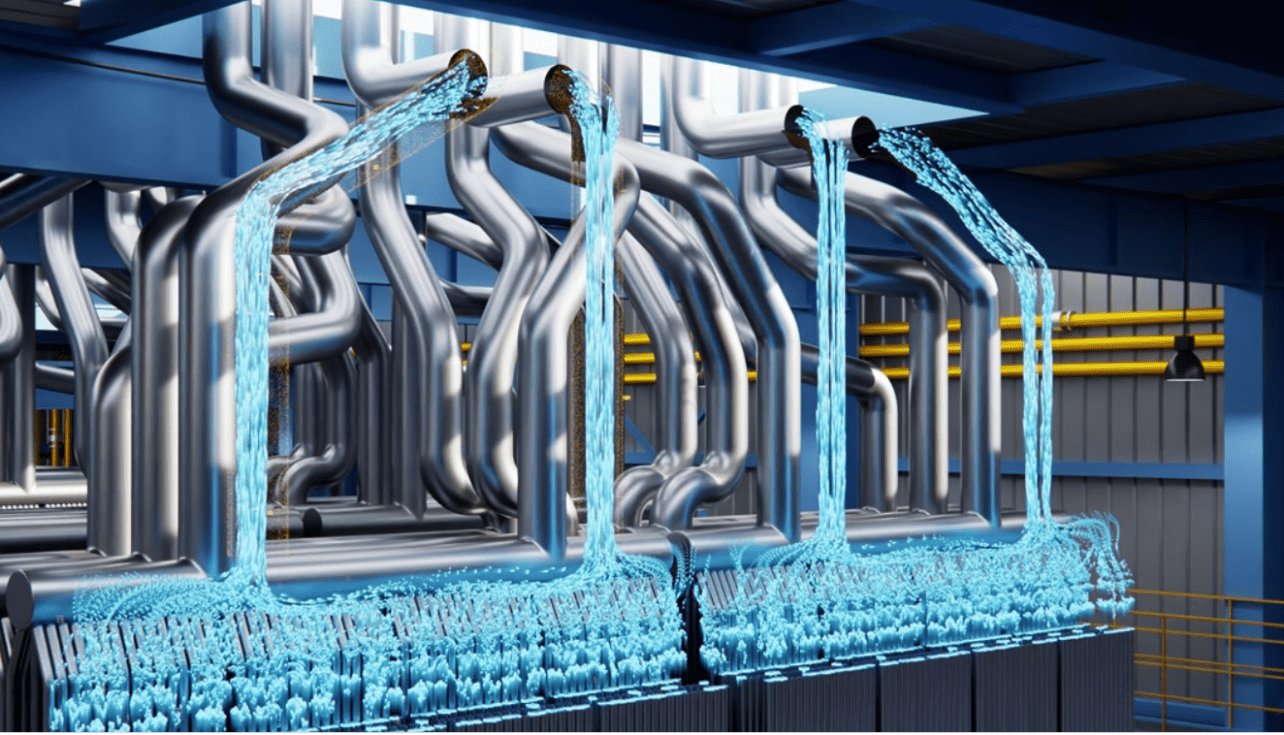

Een andere uitgebrachte oplossing voor AI is de introductie van Nvidia Modulus. Het betreft een AI-framework voor het ontwikkelen van machine learning (ML)-modellen. Met dit framework zijn neurale netwerkmodellen te bouwen van ‘digital twin’-omgevingen. Het Modulus-framework moet voor deze digitale twin-omgevingen de benodigde ML-input leveren. Deze omgevingen kunnen onder meer worden gebruikt voor het voorspellen van klimaatverandering, maar ook voor industriële toepassingen.

Nvidia Modulus biedt hiervoor onder meer data prep-functionaliteit voor geobserveerde of gsimuleerde gegevens. Daarnaast verzorgt de oplossing onder meer de juistheid van de geometrische eigenschappen van de modellen en de juistheid van de hiervoor benodigde data.