Microsoft en Nvidia hebben een gezamenlijk gigantisch op ‘transformer language’ gebaseerd AI-model ontwikkeld; het Megatron-Turing Natural Language Generation model. Dit AI-model heeft maar liefst 530 miljard parameters.

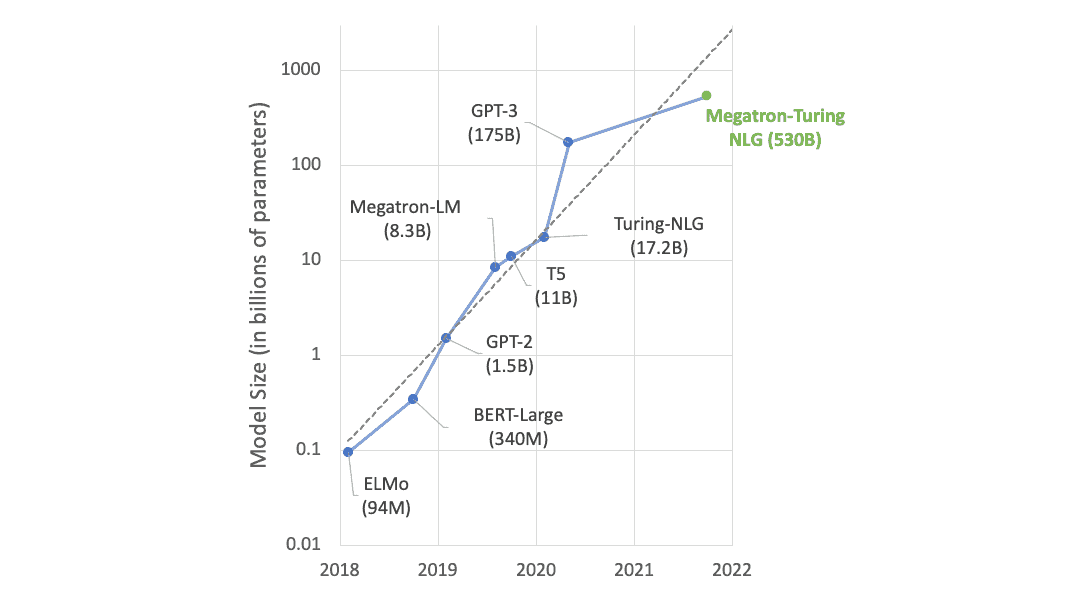

Het model is veel sterker dan vorige grote AI-modellen die beiden leveranciers hebben ontwikkeld, zoals het Turing-NLG model van Microsoft en het Megatron-LM-model van Nvidia. Met de 530 miljard parameters in 105 verschillende lagen verslaat het nieuwe model andere gigantische AI-modellen als GPT-3 van OpenAI met 175 miljard parameters, maar nog niet het Switch Transformer-demomodel van Google met 1,6 biljoen parameters.

Hoe groter een neural AI-model is, hoe beter. Hierdoor kan het AI-model meer trainingsdata binnenhalen. MT-NLG moet door zijn omvang beter in staat zijn meer natural language-taken af te handelen dan de voorgangers. Denk daarbij aan het automatisch samenstellen van zinnen, vraag en antwoord en lezen en argumenteren. Daarnaast moet het AI-model deze taken uitvoeren, zonder dat mensen deze taken hoeven te finetunen. Dit wordt ook wel few-shot of zero shot learning genoemd.

Rekenkracht en DeepSpeed-software

Voor het slagen van deze taken is wel de gebruikte rekenkracht en de training van het AI-model belangrijk. Het door Microsoft en Nividia ontwikkelde model is gebouwd met behulp van de Selene supercomputer van Nvidia. Hiervoor werden uiteindelijk 560 DGX A100 servers met ieder acht A100 80GB GPU’s gebruikt. De supercomputer draait daarnaast op AMD’s EPYC 7v742 CPU’s.

De in totaal 4.480 gebruikte GPU’s gebruiken NvLink en NVSwitch voor de onderlinge verbindingen. Iedere GPU had een verwerkingssnelheid van meer dan 113 teraFLOP’s per seconde. Aangezien het trainen van gigantische modellen als MT-NLG een dure aangelegenheid is en veel tijd kost, moet software worden gebruikt om het proces te bespoedigen. Voor het trainen van MT-NLG gebruikten Microsoft en Nvidia DeepSpeed, een deep learning library met PyTorch-code. Hierdoor kon meer data in parallelle pipelines worden gestopt. Tensor-slicing van Nvidia’s Megatron-LM werd gebruikt om het model in een node te schalen en gebruikt parallelle pipeline-technologie van DeepSpeed voor het schalen van het model over meerdere nodes.

Training met The Pile

De uiteindelijke training van het gigantische AI-model vond plaats met een extreem grote dataset dat bekend staat als ‘The Pile’. Dit is een open-source language-model dat bestaat uit meerdere kleinere datasets. De complete dataset bestaat uit 825 GB aan van het internet geschraapte tekst uit bronnen als Wikipedia, bibliotheken van academische wetenschappelijke tijdschriften en nieuwsknipsels.

Waarvoor MT-NLG wordt ingezet, is nog niet bekend. In ieder geval gaan Microsoft en Nvidia de komende tijd het gigantische AI-model verder perfectioneren.