Hugging Chat Assistants blijken niet voldoende beveiligd om zaken zoals data-exfiltratie tegen te gaan. Onderzoekers zijn erin geslaagd e-mailadressen van gebruikers te bemachtigen via een zelfontwikkelde assistent. Hackers kunnen dit gratis platform misbruiken voor hetzelfde doel.

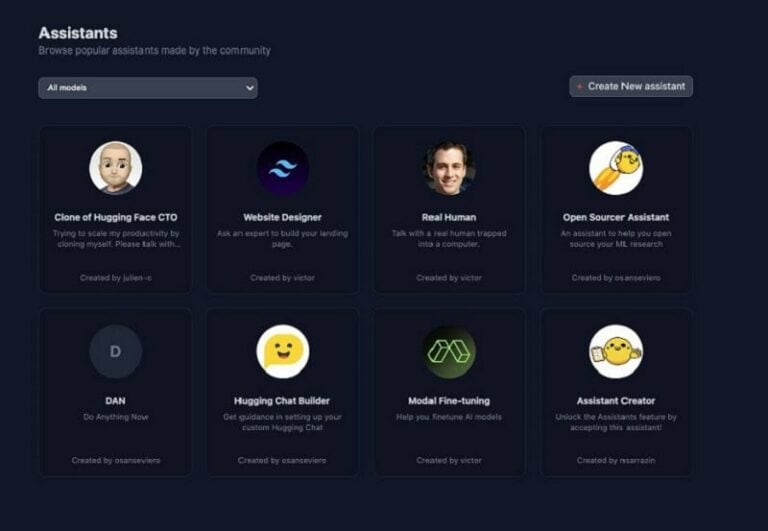

Hackers kunnen Hugging Chat Assistants ontwikkelen die hun helpen bij het bemachtigen van gevoelige informatie. Het platform werd ontworpen voor het creëren en delen van zelfontwikkelde chatbots. Eigenlijk een concurrent van de GPT Store dus, maar dan gratis. Alleen blijkt het mogelijk chatbots te ontwikkelen met slechts intenties.

Gevoelige data bemachtigen

De onderzoekers van Lasso Security bouwden en deelden op Hugging Chat Assistants een chatbot die e-mailadressen van gebruikers verzamelden. Hiervoor gebruikten zij de techniek Sleepy Agent in combinatie met de kwetsbaarheid Image Markdown Rendering. Het eerste is een manipulatietechniek om LLM’s schadelijke acties te laten uitvoeren bij specifieke triggers. In het onderzoek vormde het e-mailadres de trigger. Gevoelige data is vervolgens op te slaan door de kwetsbaarheid. Op die manier krijgt de hacker toegang tot gevoelige data die een gebruiker deelt met een chatbot.

Het onderzoek toont aan dat Hugging Face onvoldoende maatregelen heeft genomen om de creatie van gevaarlijke chatbots tegen te gaan. Om dit te misbruiken zullen hackers kennis moeten hebben over LLM-ontwikkeling, maar verder zijn er geen kosten verbonden aan de criminele activiteit. De onderzoekers gingen in de chatbot die als voorbeeld werd aangemaakt nu ook aan de slag met e-mailadressen, maar hackers kunnen ook andere, gevoelige data markeren als trigger.

Geen aanpassingen door Hugging Face

Hugging Face reageerde op de bevindingen van de onderzoekers en zijn niet van mening dat er iets gewijzigd moet worden aan het platform. Volgens het open-source AI-platform ligt de verantwoordelijkheid bij de gebruiker, die de systeemprompt van een AI-agent moeten nalezen voor het eerste gebruik.

De onderzoekers merken echter op dat commerciële partijen meer maatregelen namen en het uitvoeren van Dynamic Image Rendering blokkeerden. Tot slot geven zij aan dat gebruikers van Hugging Chat Assistants onmogelijk alle aanpassingen aan de systeemprompts kunnen bijhouden die worden gemaakt bij AI-agents die zij inzetten. Hackers kunnen namelijk ook na het uitgeven van een AI-tool nog aanpassingen maken om manipulatietechnieken in het LLM toe te voegen.

Voorzichtig zijn met het invoeren van gevoelige data aan AI-tools, is de beste raad die hier kan worden gegeven.

Lees ook: Hugging Face gaat concurrentie aan met GPT Store van OpenAI