Endor Labs heeft de tool AI Model Discovery uitgebracht, waarmee bedrijven open-source AI-modellen kunnen ontdekken en laten voldoen aan hun security policies. Dit helpt bij het beter beheersen van de risico’s die deze modellen met zich meebrengen.

Open-source AI-modellen worden steeds vaker gebruikt voor zakelijke applicaties. Hoewel dit het makkelijker maakt om AI in te zetten, brengt het gebruik ervan ook risico’s met zich mee.

De huidige Software Composition Analysis (SCA)-tools schieten tekort in het identificeren en beveiligen van deze risico’s, stelt open-source securityspecialist Endor Labs. Ze zijn vooral ontworpen voor het volgen van open-source pakketten en niet voor het signaleren van risico’s die AI-modellen in applicaties kunnen veroorzaken.

AI Model Discovery Tool

Endor Labs wil hier verandering in brengen en heeft daarom de AI Model Discovery Tool geïntroduceerd. Met deze tool kunnen bedrijven eenvoudig open-source AI-modellen in hun applicaties detecteren, vooral modellen die via Hugging Face worden verspreid. Daarnaast kunnen ze security policies toepassen op deze modellen.

De tool richt zich op drie kernfuncties:

- Detectie: Het scannen en inventariseren van lokaal gebruikte AI-modellen en het in kaart brengen welke teams en applicaties deze modellen gebruiken.

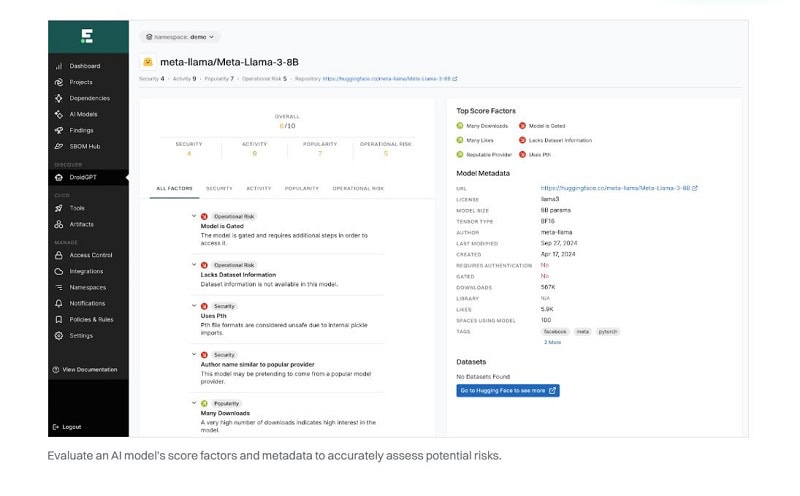

- Analyse: Het beoordelen van AI-modellen op bekende risicofactoren zoals security, kwaliteit, activiteit en populariteit. De tool identificeert ook modellen met onduidelijke databronnen, licenties of praktijken.

- Handhaving: Het implementeren van securityrichtlijnen binnen de bedrijfsomgeving, het waarschuwen van ontwikkelaars bij policy-overtredingen en het blokkeren van modellen met een hoog risico.

Onder de motorkap

Onder de motorkap doorzoekt de AI Model Discovery Tool de uit Hugging Face gebruikte open-source modellen met een reeks van parameters de onderliggende broncode op bepaalde patronen. Deze reeks wordt constant uitgebreid. Wel is deze reeks op dit moment beperkt tot open-source Python-code omdat de meeste open-source AI-modellen deze programmeercode gebruiken.

Wanneer de patronen worden ontdekt, worden de AI-modellen nog eens extra onderzocht.

In gevallen van twijfel of onduidelijkheid, wordt de broncode nog maal met behulp van de AI-functionaliteit in de tool onderzocht. Uit testen blijkt dat deze laatste check in 80 procent van de gevallen de juiste constateringen opleverden.

Toekomstige ontwikkelingen

Huidige klanten van de SCA tools van Endor Labs kunnen de tool direct gebruiken voor het testen van (Hugging Face) open-source AI-modellen. In de nabije toekomst komt de tool ook beschikbaar voor andere model-repositories en -bronnen en voor andere programmeertalen dan Python.

Onlangs bespraken we in onze podcastserie Techzine Talks on Tour met Rick Smith van SentinelOne over hoe het in dit jaar, 2025, niet alleen meer over AI zal gaan, maar vooral ook hoe AI goed moet worden beveiligd. Luister hier de podcast: