De Chinese LLM-ontwikkelaar DeepSeek heeft onlangs zijn R1-series van LLM’s gepresenteerd die zijn geoptimaliseerd voor redeneringstaken. De onderliggende algoritmes zouden zelfs betere prestaties bieden dan bijvoorbeeld OpenAI’s o1.

De nieuwe LLM’s van DeepSeek worden aangevoerd door twee algoritmes; R1-Zero en R1. De architectuur van deze modellen is gebaseerd op een Mixture of Experts (MoE)-architectuur met 671 miljard parameters. Deze opzet bespaart op inference-kosten, omdat een zoekvraag of prompt niet het hele model activeert, maar slechts een specifiek neuraal netwerk dat geschikt is voor het beantwoorden van de vraag.

Concreet activeren de LLM’s van DeepSeek, zoals R1-Zero en R1, minder dan een tiende van de beschikbare 671 miljard parameters bij het beantwoorden van prompts.

Trainingsmethoden

Volgens DeepSeek ligt de kracht van de LLM’s in de manier waarop de onderliggende algoritmes zijn getraind. Voor R1-Zero is een andere aanpak gehanteerd dan gebruikelijk bij het trainen van redeneringsmodellen.

Normaal gesproken worden dergelijke algoritmes getraind met ‘reinforcement learning’ en ‘supervised fine-tuning’. Bij reinforcement learning leert het model via trial-and-error-methodes, terwijl supervised fine-tuning de output-kwaliteit verbetert met stapsgewijze voorbeelden.

Voor R1-Zero heeft DeepSeek echter de fase van supervised fine-tuning overgeslagen. Desondanks wist het bedrijf het LLM van redeneringsvaardigheden te voorzien, zoals het opdelen van complexe taken in kleinere, eenvoudigere stappen.

R1-Zero beschikt hierdoor over veel mogelijkheden, maar de output-kwaliteit laat te wensen over. De antwoorden zijn vaak repetitief, slecht leesbaar en mengen verschillende talen door elkaar.

Verbeterd R1-LLM

Het tweede LLM dat DeepSeek heeft uitgebracht, R1, moet deze tekortkomingen oplossen. Dit model maakt gebruik van een aangepaste trainingsmethode die wél supervised fine-tuning toepast. Hierdoor is de output-kwaliteit sterk verbeterd.

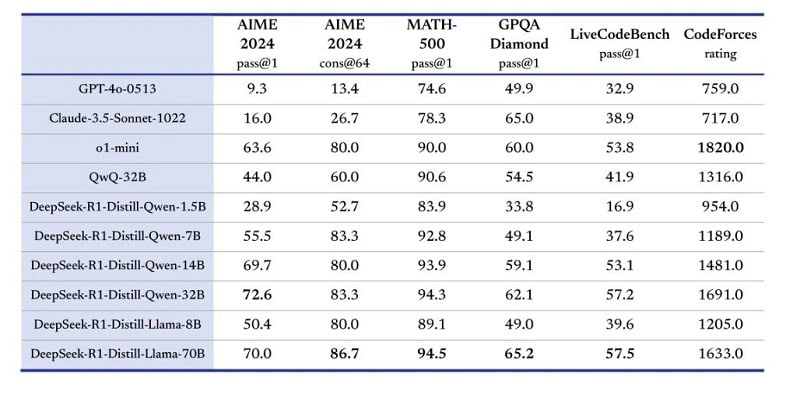

R1 presteert volgens de ontwikkelaar op verschillende benchmarks beter dan het OpenAI’s o1-LLM. Op andere benchmarks zou het model minder dan vijf procent achterlopen op het LLM van OpenAI.

Overige uitgebrachte modellen

Naast R1-Zero en R1 introduceerde DeepSeek ook enkele minder krachtige LLM’s. Deze modellen zijn ontworpen met een focus op hardware-efficiëntie en hebben een omvang tussen de 1,5 en 70 miljard parameters.

Onder de oppervlakte zijn deze LLM’s gebaseerd op de open-source Llama- en Qwen-reeksen. Het model R1-Distill-Qwen-32B zou volgens DeepSeek zelfs beter presteren dan afgeschaalde versies van OpenAI’s o1-mini- of o-modellen op diverse benchmarks.

De broncode van DeepSeek R1-Zero en R1 is inmiddels beschikbaar op Hugging Face.

Lees ook: DeepSeek-V3 overkomt uitdagingen van Mixture of Experts-techniek