De Nvidia A100 Tensor Core GPU is nu beschikbaar op Google Cloud. Naar eigen zeggen betreft het de krachtigste GPU van het bedrijf tot op heden.

De chip, gebouwd op de Ampere-architectuur, is voornamelijk ontworpen voor AI-training en inference workloads. De A100 is 20 keer zo krachtig als zijn voorganger, de Volta GPU. Daarnaast bestaat de GPU uit 54 miljard transistors.

De chip is gebouwd met behulp van Nvidia’s derde generatie tensor cores. Er wordt gebruikgemaakt van multi-instance GPU-technologie (MIG). MIG maakt het mogelijk om één A100-chip te partitioneren tot zeven kleine onafhankelijke GPU’s met hun eigen systeembronnen om meerdere taken tegelijkertijd uit te voeren. Bovendien is het mogelijk om via de Nvidia NVLink interconnect-technologie meerdere A100=chips aan te sluiten om grote AI-workloads te trainen.

Google Cloud

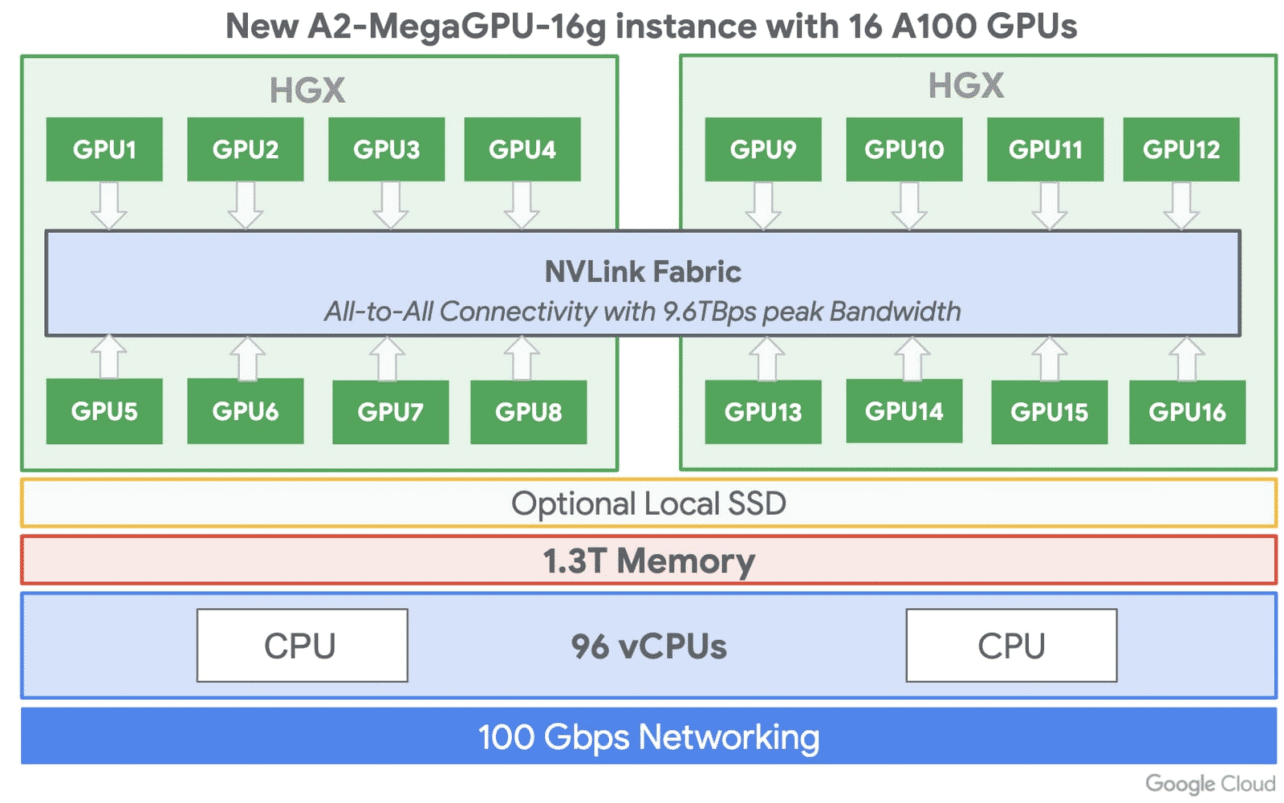

Google maakt gebruik van deze mogelijkheid om meerdere chips aan te sluiten. In de nieuwe instance-serie zit ook een a2-megagpu-16g optie waarmee klanten 16 A100 GPU’s tegelijk kunnen gebruiken, met een gecombineerd CPU-geheugen van 640 gigabyte en 13 terabyte aan systeemgeheugen. Ook kan hiermee een geaggregeerde bandbreedte bereikt worden van 9,6 terabyte per seconde.

De A100 GPU is beschikbaar in kleine configuraties voor klanten met minder zware workloads. Binnenkort moet de A100 GPU beschikbaar worden voor Google Kubernetes Engine en Google Cloud AI-platform.