Je kunt geen artikel over Artificial Intelligence lezen of het thema komt naar voren: “Ethical AI” ook wel “Responsible AI”. Zelfs de Tweede Kamer heeft zich over dit onderwerp uitgesproken. Waarom is dit onderwerp zo populair? Dit komt volgens mij door een gebrek aan vertrouwen in de algoritmes, de organisaties die ze gebruiken of de mensen die ze hebben gemaakt. Als data scientist heb ik weinig invloed op de laatste twee factoren, maar het inzichtelijk maken van wat de algoritmes doen kan ik wel.

Zondag 20 oktober is het de dag van de statistiek en op deze dag wordt het belang van goede cijfers en statistische gegevens ook weer eens benadrukt.

Het vertrouwen van een algoritme komt neer op twee dingen: de betrouwbaarheid van het model en het vertrouwen in de voorspellingen. De maker van het algoritme moet vertrouwen hebben dat zijn of haar model goed is en de eindgebruiker moet het vertrouwen hebben dat wat het model voorspelt, correct is. Hoe beter je snapt hoe een model zich gedraagt, hoe minder het gezien wordt als een “black box”. Daarom worden beslisbomen en lineaire regressies vaak gezien als uitlegbare modellen: de meeste data scientists snappen hoe deze modellen werken en het is makkelijk uit te leggen hoe ze tot een beslissing leiden. Dit klopt zeker wanneer de beslisboom op een A4 past of wanneer er een tiental variabelen gebruikt wordt. Als honderden of duizenden variabelen gebruikt worden voor een voorspelling, kan eigenlijk niemand er iets zinnigs meer over zeggen. Daarnaast wil je je niet beperken tot deze modellen als je ook geavanceerdere technieken tot je beschikking hebt die geschikter zijn voor het probleem dat je aan het oplossen bent. Het inzicht in een algoritme verschilt ook per persoon. Als ontwikkelaar van het model weet ik beter hoe zo’n model in elkaar zit dan de eindgebruiker. Hoe je een model uitlegt, hangt dus af van het publiek.

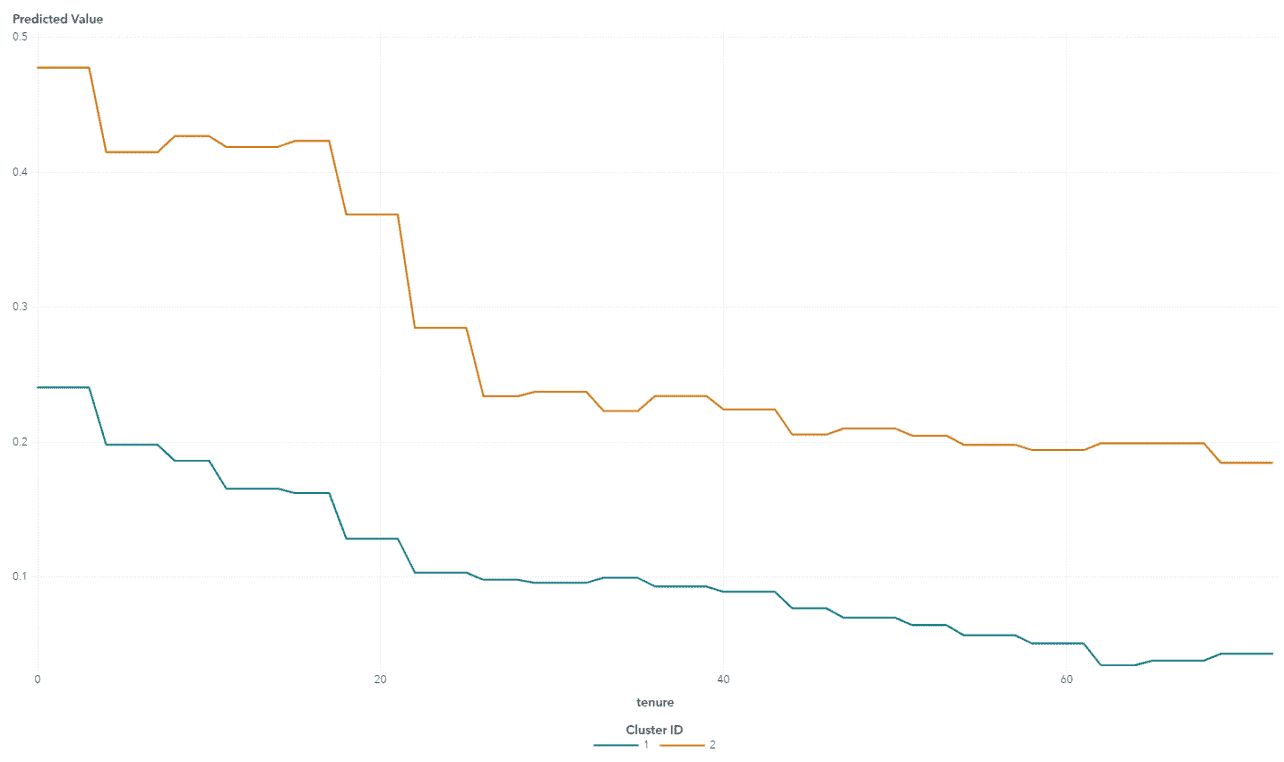

Zoals eerder gezegd, mensen moeten vertrouwen hebben in zowel het model als de individuele voorspellingen. Hierin kan dus een onderscheid worden gemaakt tussen verschillende manieren van uitlegbaarheid: voor de ontwikkelaar en voor de eindgebruiker. Bij het ontwikkelen van een model gebruikt men standaarden om te bepalen hoe goed het algoritme presteert. Dit kan de misclassificatie zijn, de Kolmogorov-Smirnov statistiek, de AUC, of een andere meetwaarde. Maar dit geeft geen inzicht in de denkwijze van het model. Het is natuurlijk belangrijk dat het model goed is in het voorspellen van je doelvariabele, maar ik zou ook graag willen weten wat het effect van de variabelen is op de uitkomst. Partial dependence- (PD) en individual conditional expectation- (ICE) plots illustreren de relaties tussen één of meerdere input-variabelen en de uitkomst van je model. Beide methodes zijn model-agnostisch en visueel. Een PD-plot kan bijvoorbeeld laten zien wat de relatie is tussen de kans dat een klant het contract opzegt en de hoe lang de klant al bekend is bij het bedrijf. Deze kan bijvoorbeeld lineair zijn, een step function of logaritmisch. Met ICE-plots kunnen deze relaties verder worden uitgediept om verschillen te vinden in het effect van een variabele tussen individuele observaties, om subgroepen te identificeren die zich anders gedragen of interacties tussen input-variabelen te achterhalen.

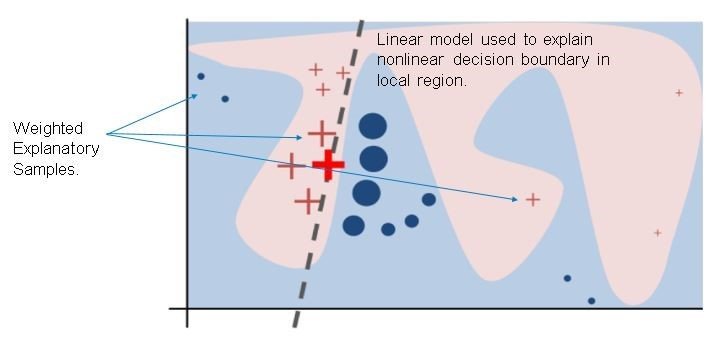

Wanneer ik als data scientist tevreden ben over het model, moet ik deze goed kunnen uitleggen aan alle betrokkenen. Hiervoor is het niet alleen belangrijk om de interne werkingen van het model toe te lichten, maar ook om de individuele voorspellingen toe te lichten. Een algoritme kan een bankmedewerker beter ondersteunen bij het toekennen of afwijzen van een lening wanneer hij een lijst krijgt van factoren die positief of negatief hebben bijgedragen aan deze individuele beslissing. Hiervoor kan LIME gebruikt worden. LIME staat voor Local Interpretable Model-agnostic Explanations. Deze methode traint een interpreteerbaar model lokaal rondom een voorspelling. De parameters van dit lokale model kunnen daarna gebruikt worden om de uitkomst van het originele model uit te leggen.

Zoals ik al eerder aangaf, is de term “interpreteerbaar” afhankelijk van het publiek. Als data scientist heb je de verantwoordelijkheid de juiste vertaling te maken. Hierbij is het niet alleen belangrijk welk model wordt gekozen om een voorspelling uit te leggen, maar ook inzicht te geven in hoe de variabelen door dit model gebruikt worden. Een tekstclassificatiemodel werkt bijvoorbeeld met moeilijk te interpreteren ‘word vectors’, maar de lokale interpretatie werkt met het wel of niet aanwezig zijn van een bepaald woord. Zo wordt het eenvoudiger om het effect van dat woord uit te leggen.

LIME is ontwikkeld door Marco Tulio Ribeiro, Sameer Singh, en Carlos Guestrin en wordt beschreven in de paper “Why Should I Trust You? Explaining the Predictions of Any Classifier” . Een echte aanrader!

Er is nog een reden waarom algoritmes zoveel in het nieuws zijn: ze zijn superhandig en worden overal gebruikt. Het is ook niet meer dan normaal en tot op zekere hoogte ook gezond om voorzichtig te zijn. We moeten er natuurlijk wel voor waken dat we niet te angstig worden voor nieuwe technieken en veranderingen. Gelukkig wordt er actief onderzoek gedaan naar methodes die ingewikkelde modellen uitlegbaar maken. Dit is geen triviale taak, maar ik ben ervan overtuigd dat als de ontwikkelaars van de modellen zich hier actief mee bezighouden er meer vertrouwen komt in de algoritmes en de organisaties die er gebruik van maken.

Dit is een ingezonden bijdrage van Jaimy van Dijk, Data Scientist bij SAS. Via deze link vind je meer informatie over de mogelijkheden van het bedrijf.