Nvidia heeft een reeks aan nieuwe technologische oplossingen aangekondigd voor meer AI-functionaliteit in datacenteromgevingen. Belangrijke introducties zijn de nieuwe Grace CPU Superchip-processor en de Nvidia H100 GPU.

De belangrijkste introductie voor het brengen van meer AI-functionaliteit naar datacenteromgevingen, is de introductie van de Nvidia Grace CPU Superchip-processor. Dit is een speciaal voor datacenteromgevingen op Arm gebaseerde Neoverse-processor voor AI-infrastructuur en high performance computing (HPC). De processor moet twee keer de geheugenbandbreedte, tot 1 Tbps, en meer energiezuinigheid bieden dan de huidige serverprocessors.

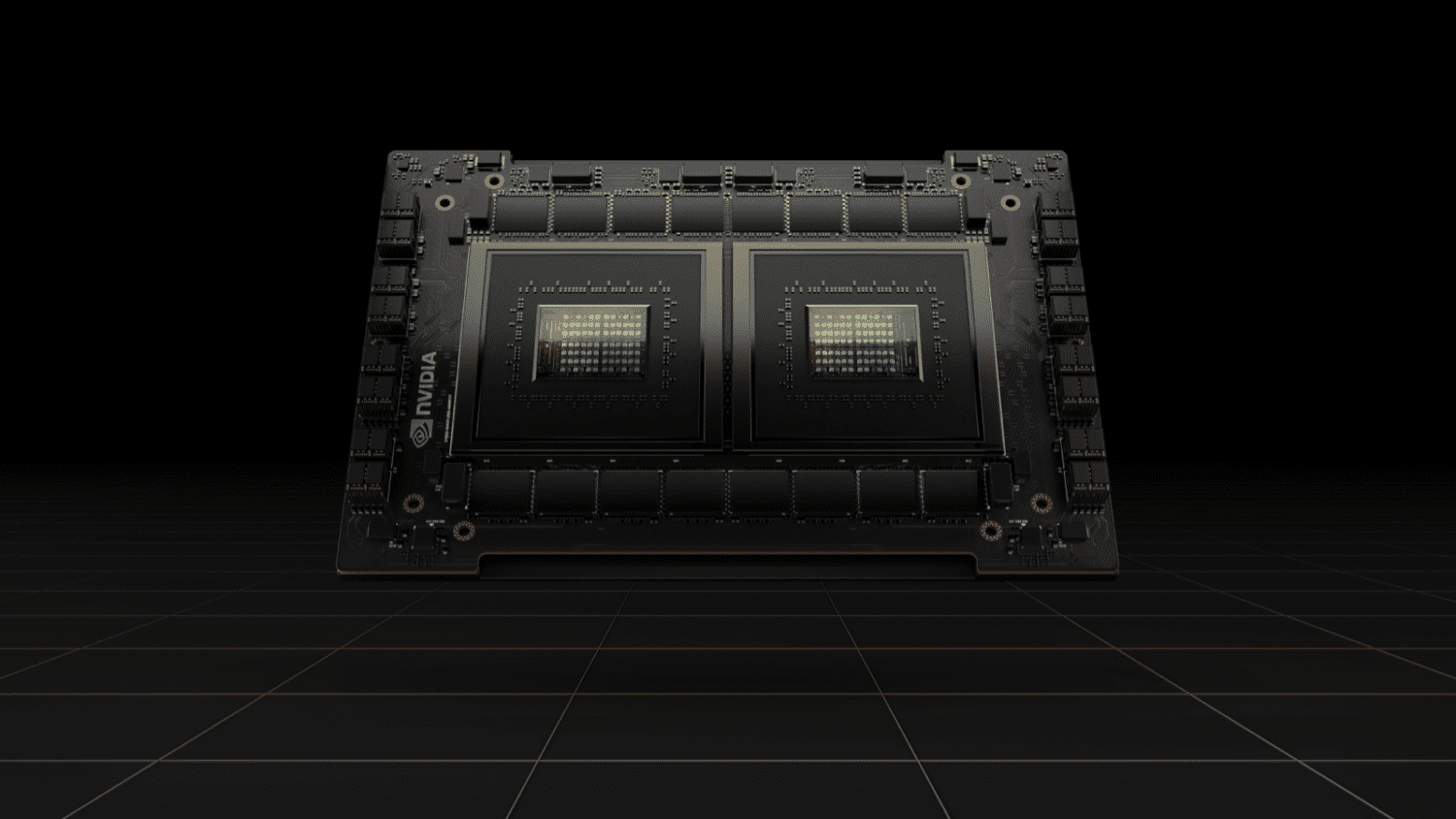

Structuur Nvidia Grace Superchip-processor

De Nvidia Grace CPU Superchip-processor bestaat uit twee met elkaar via NVLink-C2C verbonden CPU-processoren. NVLink-C2C is een nieuwe chip-to-chip interconnect-technologie met hoge snelheden en een lage latency. De processor is gebaseerd op de v9-technologie van Arm en heeft 144 Arm cores in een enkele socket. Daarnaast beschikt de processor over LPDDDR5x-geheugen met Error Correction Code voor de beste balans tussen snelheid en energiegebruik.

De Nvidia Grace Superchip complementeert de vorig jaar uitgebrachte CPU-GPU-module Grace Hopper SuperChip voor hoogwaardige HPC- en AI-workloads. De Nvidia Grace Super Chip is geschikt voor alle Nvidia software stacks.

Nvidia H100 GPU’s voor uitgebreide AI-functionaliteit

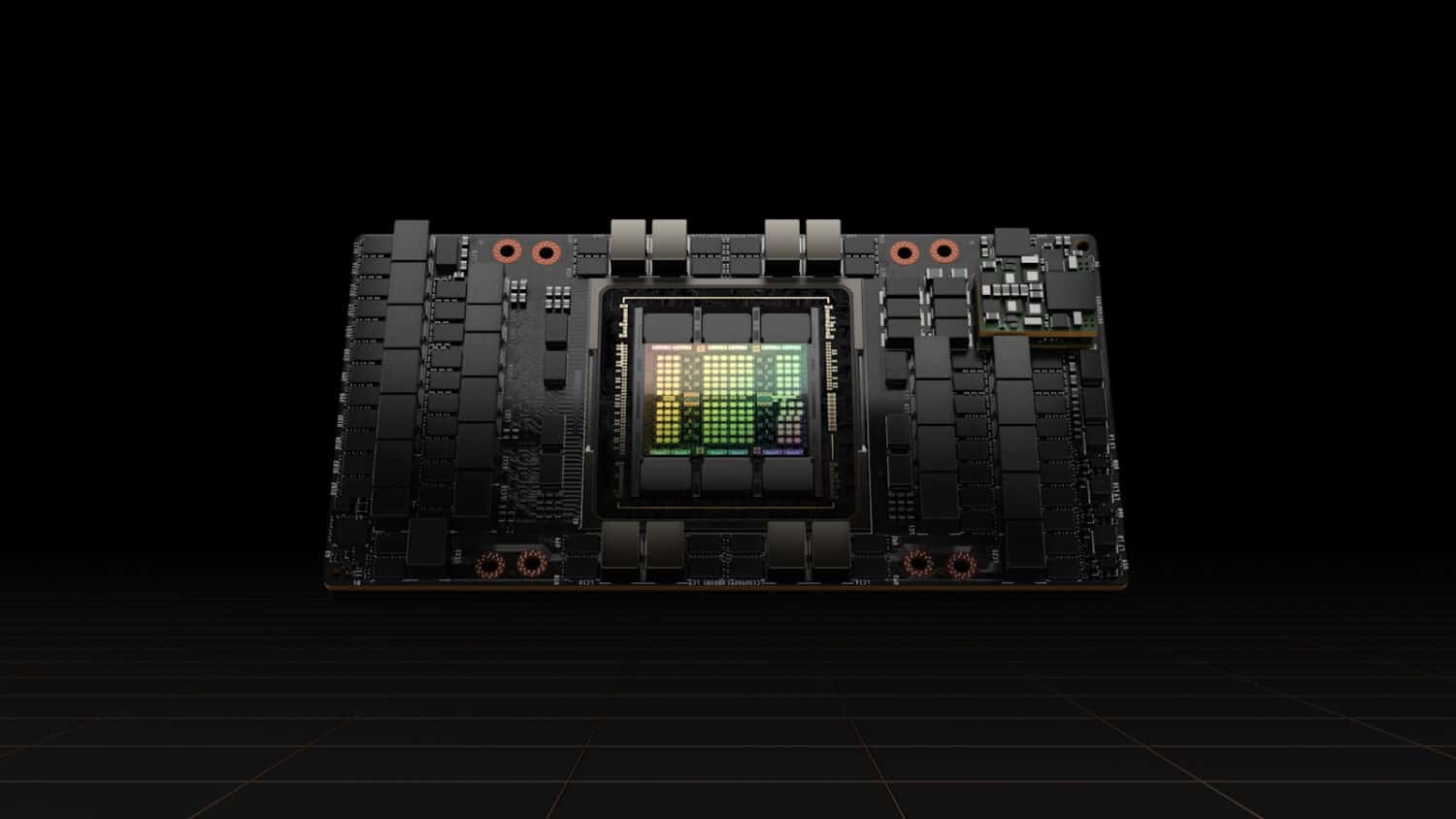

Nvidia introduceerde naast de Grace CPU Superchip-processor ook de nieuwe op Hopper-technologie gebaseerde Nvidia H100 GPU. De Hopper-technologie kan onder andere worden ingezet voor het schalen van workloads voor HPC-computing in datacenters en voor het zeer veilig verwerken van data of ‘confidential computing’.

De Nvidia H100 GPU bestaat uit maar liefst 80 miljard transistors en beschikt over diverse technologieën die de GPU vooral geschikt maken voor het geavanceerd trainen van zeer grote AI-modellen, deep recommender-systemen, het samenstellen van genetische modellen en complexe digital twin-omgevingen.

Het GPU-platform beschikt over technologie en functionaliteit als geheugenbandbreedte, de Nvidia NVLink-interconnecttechnologie, goed voor bijna 5 Tbps aan externe connectiviteit, een nieuwe Transformer Engine, tweede generatie Secure Multi-Instance GPU, Confidential Computing en de DPX Instructions-technologie voor het trainen van grootschalige AI-modellen en -algoritmes.

Form factors

De Nvidia H100 GPU’s zijn leverbaar in SXM- en PCIe form factors. Hierdoor kunnen zij voldoen aan een grote hoeveelheid aan serververeisten. De GPU’s kunnen verder in iedere soort datacenteromgeving worden gebruikt. Of dit nu on-premises-, hybrid cloud, edge- of multi-cloudomgevingen zijn. Verder worden deze GPU’s gebruikt in het eveneens recent geïntroduceerde Nvidia DGX H100 AI-infrastructuurplatform. Dit platform bestaat uit acht Nvidia H100 GPU’s die tot 32 petaflops aan AI-prestaties kunnen leveren.