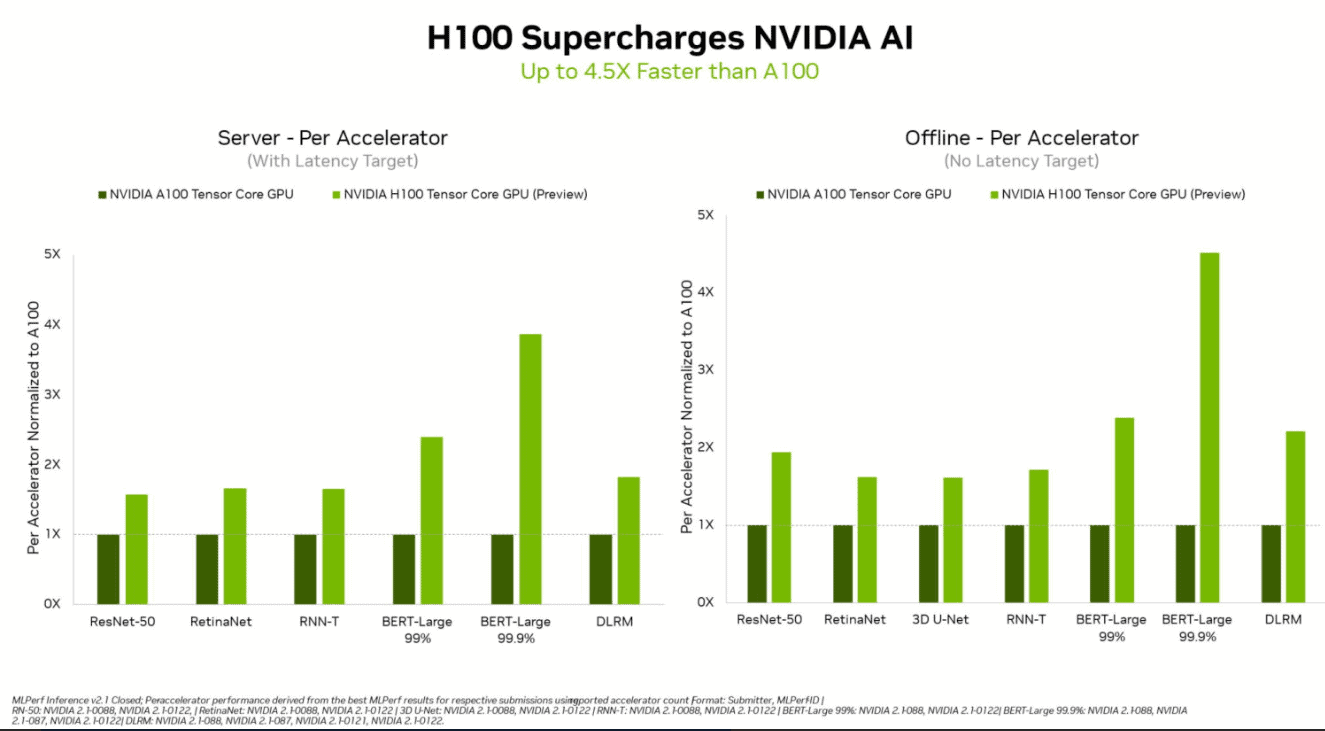

Nvidia heeft naar eigen zeggen een prestatierecord weten vast te leggen voor zijn komende Hopper H100 Tensor Core GPU. Deze nieuwe GPU zou tot 4,5 keer sneller zijn dan de huidige Nvidia A100-processor voor AI- en ML-toepassingen.

Het nieuwe prestatierecord werd onlangs vastgelegd via het MLPerfTM Inference 2.1-benchmark, een industriestandaard. Dit benchmarkt meet zogenoemde ‘inference’ workloads die aantonen hoe goed een processor een voorgetraind machine learning-model kan toepassen op nieuwe data. Dit benchmark moet uiteindelijk klanten laten zien welke ML-prestaties processors hebben.

Testresultaten

In de test presteerde de Nvidia H100 GPU zeer goed bij alle zes van de geteste neurale netwerken. Vooral op het gebied van throughgput en snelheid in afzonderlijke servergebaseerde en offline scenario’s scoorde de nieuwe GPU zeer goed. Hierbij werden tot 4,5 keer hogere prestaties genoteerd dan bij de huidige Nvidia Ampere A100-processors, die momenteel als de beste processors voor AI- en ML-toepassingen worden beschouwd.

De Hopper H100 GPU scoorde dankzij de Transformer Engine van de GPU vooral goed in combinatie met het zogenoemde BERT-datamodel van Google. Dit is één van de grootste en meest data-intensieve NLP-modellen van de MLPref AI-benchmark. De uitstekende prestaties van de H100 GPU voor dit ML-model geven aan dat de processor ook zeer geschikt is voor bijvoorbeeld GTP-3 van OpenAI.

Ecosysteem test mee

De Hopper H100 GPU’s moeten binnenkort de huidige A100-processors gaan vervangen als de belangrijkste datacenterprocessors van Nvidia. Inmiddels worden de H100 GPU’s ook door het ecosysteem getest, waaronder Microsoft Azure, Dell Technologies, HPE, Lenovo, Fujitsu, GIGABYTE en ASUS.