Meta heeft onlangs eigen processors,een datacenterontwerp en een supercomputer geïntroduceerd voor AI-workloads. De techgigant wil hiermee een stukje van de taart in handen krijgen als het gaat om AI-oplossingen en -toepassingen, maar ook de controle behouden.

Meta voelt de druk van andere techgiganten als het gaat om AI-ontwikkelingen en wil daarbij aanhaken. Onlangs heeft de techgigant daarom een aantal belangrijke aankondigingen gedaan, vooral op het gebied van hardware. Meta wil hiermee, naar eigen zeggen, de controle krijgen en houden over de hele eigen AI-infrastructuur stack.

Processors en datacenterontwerp

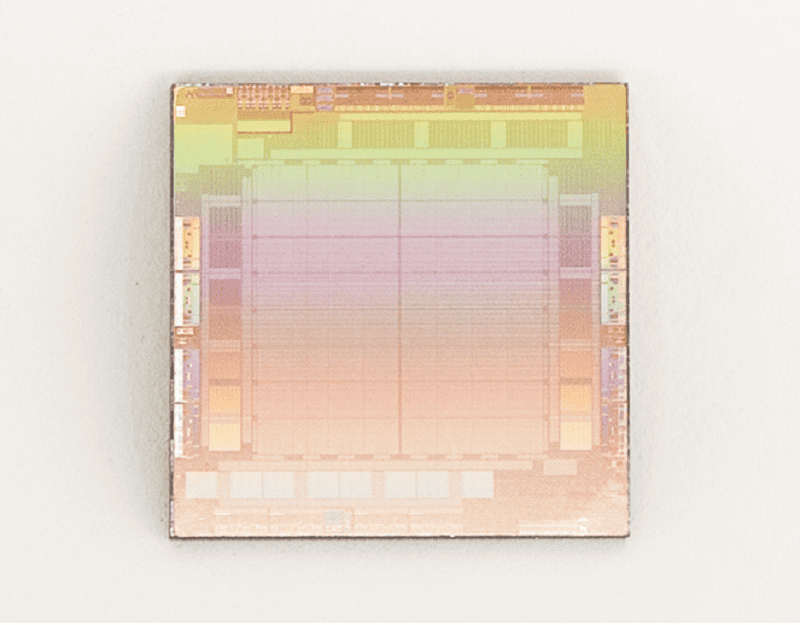

De belangrijkste aankondiging is de komst van eigen AI-workload processors. De Meta Training and Inference Accelerator (MTIA) richt zich specifiek op inference workloads en moet daarvoor meer rekenkracht, betere prestaties, minder latency en meer efficiency bieden.

Daarnaast is deze ASIC-accelerator volledig aangepast aan de eigen interne workloads binnen Meta. De MTIA-accelerator wordt straks in combinatie met GPU’s, waarschijnlijk Nvidia GPU’s, gebruikt, zo is de bedoeling.

De techgigant introduceert ook een nieuw datacenterontwerp. Dit ontwerp moet beter beantwoorden aan de inzet van AI-hardware voor zowel training, als inference. Denk aan met vloeistof gekoelde AI-hardwaretoepassingen en een high-performance AI-netwerkomgeving die duizenden AI-processors met elkaar verbindt in grote AI-trainingclusters.

Supercomputer

Last but not least, kondigt Meta de komst van de Research SuperCluster (RSC) AI Supercomputer aan. Dit is volgens de techgigant één van de snelste AI-trainingssupercomputers in de wereld. De supercomputer bestaat uit 16,000 GPU’s en een 3-level Clos netwerkfabric dat bandbreedte levert voor 2.000 trainingssystemen.