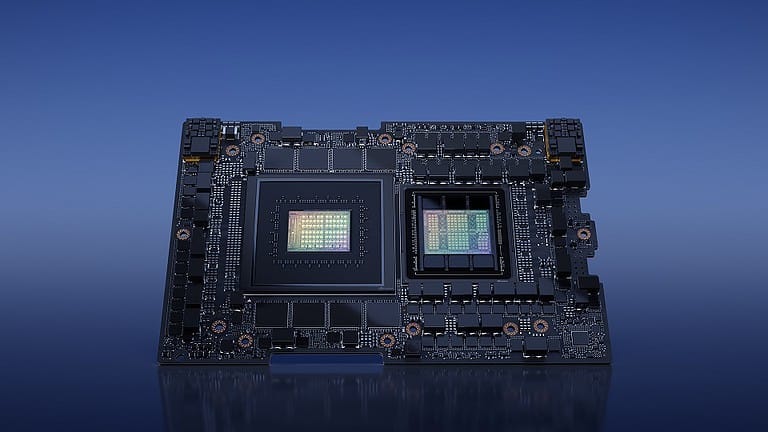

Nvidia heeft tijdens Computex 2023 de GH200 Grace Hopper ‘Superchip’ onthuld, een combinatie van de eigen CPU’s en GPU’s bedoeld voor datacenters. Met deze Arm-gebaseerde chip is het mogelijk om AI-workloads efficiënt en op gigantische schaal te draaien. Google, Meta en Microsoft zouden de technologie al in huis hebben.

AI voert bij menig tech-conferentie de boventoon, en hetzelfde geldt voor Computex. Nvidia zelf belooft een grote stap te zetten richting efficiëntie en schaalbaarheid. CEO Jensen Huang beweerde dat de eigen op Arm-gebaseerde chips tot wel twee keer zo efficiënt zijn als hun x86-64-tegenhangers vanuit AMD en Intel. Het is een opvallend verschil, omdat deze drie partijen nu allemaal zowel CPU’s als GPU’s ontwerpen (zij het voor verschillende doeleinden), maar alleen Nvidia zit op Arm. Dankzij een lichtgewicht instructieset is het mogelijk voor grote bedrijven om hun in-house software zeer dichtbij de ‘bare metal’ te draaien. Denk aan toepassingen zoals de algoritmes achter Facebook, Google-zoekfuncties of Microsoft-advertenties.

Op dat gebied belooft Nvidia een indrukwekkende verbetering: AI-modellen zouden tot wel dertig keer zo snel getraind kunnen worden dankzij deze nieuwe innovatie.

De troef van NVLink

Nvidia is al de overweldigende hofleverancier van datacenter-GPU’s. Het heeft talloze orders staan voor de nieuwste H100-GPU’s en het is maar de vraag of het aan de vraag kan voldoen. Wat wel duidelijk is, is dat Nvidia stevig heeft geïnvesteerd in schaalbaarheid. GPU’s kunnen al geruime tijd met elkaar communiceren, maar hiervoor is een technologie zoals NVLink nodig om dit op de gewenste snelheid te doen.

Op elke Superchip zit tot wel 480 GB aan LPDDR5X-geheugen, dat dichtbij het silicium geparkeerd staat. Er zit een reusachtige 117 MB aan L3-cache op de chip. De Grace Hopper-superchip kan wat bandbreedte tussen de CPU en GPU in theorie tot wel 900 GB/s onderling overdragen. Daarnaast draait de GPU op HBM3-geheugen, dat tot wel 4 TB/s aan bandbreedte heeft. Op elke Superchip zit 96 GB VRAM, wat misschien klinkt als veel, maar veel te weinig is voor de grote datasets die LLM’s voeden. Tot wel 256 GPU’s kunnen aan elkaar verbonden worden dankzij Nvidia’s nieuwste NVLink-tech: dit houdt in dat er 150 TB aan videogeheugen toegankelijk kan zijn.

Voor dit alles moet ondanks de efficiëntie een aardige energierekening verwacht worden. Een GH200 verbruikt namelijk tot wel 1000 Watt, hoewel dit te programmeren is tot ‘slechts’ 450W.

“Generatieve AI is bedrijven snel aan het transformeren, nieuwe mogelijkheden aan het ontrafelen en ontdekkingen aan het accelereren binnen de gezondheidszorg, finance, dienstverlening en menig andere industrie,” liet Nvidia VP of Accelerated Computing Ian Buck weten tegenover SiliconANGLE. “Met Grace Hopper Superchips in volle productie kunnen makers wereldwijd de geaccelereerde infrastructuur bieden die bedrijven nodig hebben om generatieve AI-applicaties te bouwen en in te zetten die hun eigen data inzet.”

Lees ook: Nvidia profiteert enorm van hype rondom AI-toepassingen