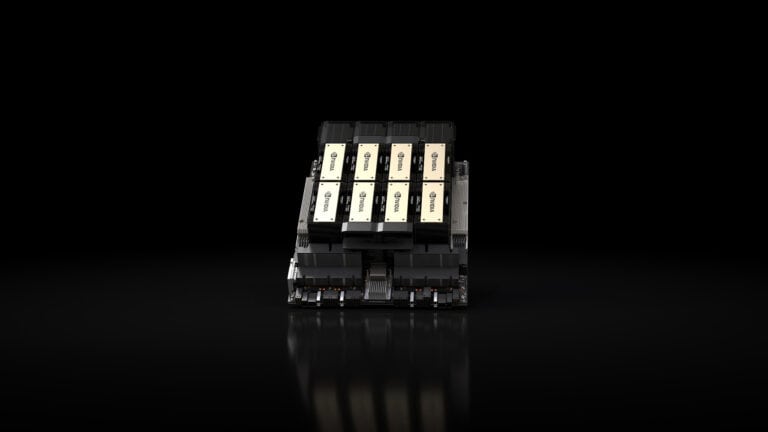

Nvidia heeft de H200-chip onthuld tijdens het Supercomputing 2023-evenement. Normaal gesproken zou een geheugen-upgrade van Nvidia-hardware weinig stof doen opwaaien. Echter lanceert de GPU-fabrikant de nieuwe H200 in een markt met ongeremde vraag. Meer en sneller geheugen dan voorheen is een niet al te drastische verandering van specificaties, maar zal de fabrieken van TSMC overuren laten draaien.

Nvidia borduurt met de H200 voort op de H100, met dezelfde Hopper-architectuur dat ten grondslag ligt aan het ontwerp. Ook is de GPU zelf vermoedelijk voorzien van dezelfde aantallen CUDA- en Tensor-cores, hoewel dat nog niet bevestigd is.

Waar de verandering plaatsvindt, is bij het geheugen. Daar waar de H100 gebruikmaakte van 80GB aan HBM3, zit er in de H200 141GB aan HBM3e. Daarmee maakt de GPU gebruik van een grotere memory bus (6144-bit versus 5120-bit) en is de bandbreedte van het geheugen gegroeid van 3,35TB/s naar 4,8TB/s.

LLM-specialist

Ondanks dat de H200 pas in het tweede kwartaal van 2024 gelanceerd wordt, valt er aardig wat te concluderen uit de details die Nvidia heeft gedeeld. Zo zijn de grootste LLM’s momenteel ingeperkt door de 80GB aan VRAM (videogeheugen) en is de snelheid van training deels bepaald door de bandbreedte van het geheugen. Met een toename van 76 procent aan VRAM en 1,45TB/s extra bandbreedte zal het trainingsproces van een LLM hoe dan ook sneller voltooid zijn. Overigens is de 141GB net iets minder dan het theoretische maximum van 144GB dat de Hopper-architectuur zou ondersteunen. De 3GB aan speling zorgt ervoor dat Nvidia ook enkele uitgeschakelde geheugenmodules kan inzetten, met betere productiecijfers tot gevolg.

Tip: HPE introduceert eerste systeem met Nvidia GH200 Superchip

Concreet lijkt de H200 op het GPU-gedeelte van de GH200 Superchip, zoals Anandtech opmerkte, dat gisteren voor het eerst door HPE geïntroduceerd werd in een compleet systeem. Die variant is een combinatie van een Arm-gebaseerde CPU en GPU. Echter verschilt het HBM3-geheugen aanzienlijk met het nieuwe HBM3e, zoals eerder vermeld.

Compatibel

Aangezien de H100 dit jaar weleens voor circa 40.000 euro is verkocht per stuk, zullen weinig partijen in staat zijn om de felbegeerde GPU’s te kopen. Wie dat fortuin wel in huis heeft (en meestal ook meerdere GPU’s tegelijk koopt), kan in ieder geval de upgrade maken naar de H200. De chip is volledig compatibel met eerdere servers die veelal 8 identieke GPU’s kunnen huisvesten.

Met de H200 brengt Nvidia in feite een niet al te drastische refresh voor de bestaande productenlijn. Toch zal de vraag onverminderd hoog blijven zolang de AI-hype aanhoudt. Het is maar de vraag wanneer Nvidia besluit de opvolger te introduceren (‘Blackwell’), dat buiten Nvidia vooralsnog enkel bekend is via geruchten.

Lees ook: Intel zegt als enige AI-strijd aan te kunnen met Nvidia