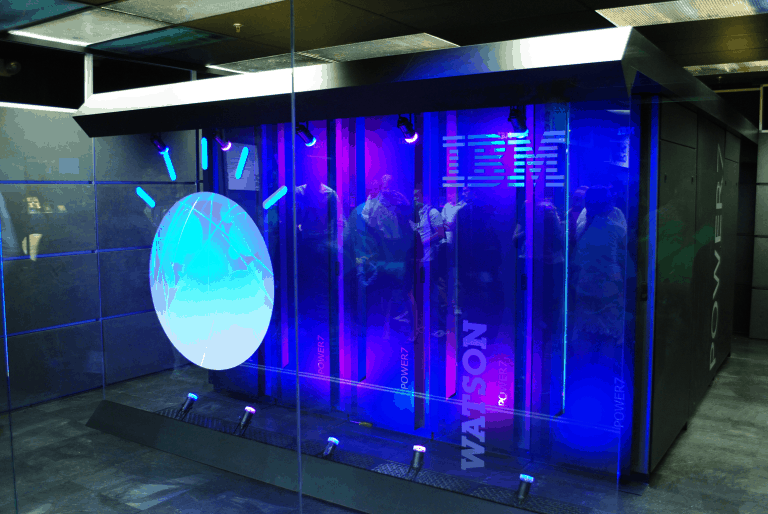

Een team van het MIT-IBM Watson AI Lab hebben een methode gevonden waarmee ze kunstmatige intelligentie (AI) voor video recognition sneller kunnen trainen. De grootte van de modellen wordt daarmee ook verminderd en de prestaties op mobiele apparaten moeten verbeterd worden.

De wetenschappers bereikten dit alles door te manier waarop video recognition-modellen tijd zien te veranderen, schrijft Engadget. Huidige modellen encoderen het tijdsverloop in een reeks van beelden. Daarmee worden grotere, compute-intensieve modellen gemaakt.

De onderzoekers van het MIT-IBM-team hebben dus voor een andere aanpak gekozen. Zij ontwierpen een zogeheten temporal shift-module, waarmee het model het gevoel krijgt dat de tijd passeert, zonder dat dit expliciet weergegeven wordt.

In tests kon het team met deze methode de deep learning, video recognition-AI drie keer sneller trainen dan met bestaande methodes.

Eenvoudiger voor mobiele apparaten

De temporal shift-module komt niet alleen met een voordeel op het gebied van trainingssnelheid. Ook kan de module het eenvoudiger maken om video recognition-modellen op mobiele apparaten te draaien. En dat is ook een expliciet doel van het team, vertelt MIT Assistant Professor Song Han.

“Ons doel is om AI toegankelijk te maken voor iedereen met een low-power apparaat. Om dat te doen moeten we efficiënte AI-modellen ontwerpen die minder energie gebruiken en soepel kunnen draaien op edge-apparaten waar zoveel AI in beweging is.”

Door de rekenkracht die vereist is voor de training te verminderen, kan de methode mogelijk ook helpen om de CO2-voetafdruk van AI te verminderen. Daarnaast kan het ervoor zorgen dat medische instituten als ziekenhuizen AI-applicaties lokaal kunnen draaien, in plaats van in de cloud. Daardoor blijft gevoelige data veiliger. Het team ziet ook toepassingen voor Facebook en YouTube om gewelddadige of terroristische beelden te vinden en te verwijderen.