Met het nieuwe Large Language Model Arctic kan Snowflake bedrijven helpen bij het genereren van code en SQL.

Snowflake wil op deze manier de concurrentie aangaan met bestaande modellen. Met de introductie van GPT-3.5 en GPT-4 van OpenAI is er een grote markt ontstaan, maar er komen steeds meer alternatieven bij die met benchmarks kunnen onderbouwen dat ze beter zijn. Ook Arctic claimt indrukwekkende prestaties. Voordat we in de benchmarks duiken die laten zien wat het LLM kan, kijken we eerst naar hoe Arctic in elkaar steekt.

Architectuur

Bij Arctic is er gekozen voor een Mixture-of-Experts (MoE)-architectuur. Nieuwe LLM’s worden vaak gebouwd met behulp van deze MoE-architectuur. Dit kan een vooruitgang zijn ten opzichte van een dense-benadering waar eerdere modellen op vertrouwden. Bij MoE worden computetaken opgesplitst in meerdere onderdelen (experts). Iedere expert is gemaakt voor specifieke taken. Daardoor is de output van een expert zeer accuraat, omdat die precies weet hoe die de taak moet afronden. De outputs van de experts worden ook gecombineerd om Arctic een nauwkeurige reactie te laten geven.

Tijdens de presentatie van het nieuwe model vergelijkt Snowflake deze werkwijze met een ziekenhuis, wat verduidelijkt hoe deze architectuur werkt. Je kunt als je ziek bent naar een gezondheidsexpert gaan die van alles een beetje weet, maar dan is de diagnose niet altijd accuraat. Om een zo goed mogelijke diagnose en behandelplan te krijgen, is het raadplegen van een subexpert (zoals cardioloog, psychiater en reumatoloog) gewenst. Zo gaat een MoE-architectuur ook te werk, en zelfs meer dan dat. Iedere expert binnen de MoE-architectuur is te vergelijken met een medisch professional die weer verder gespecialiseerd is. Om in de vergelijking met het ziekenhuis te blijven: daar kan een cardioloog ook gespecialiseerd zijn in één type cardiologische aandoening.

Prestaties ten opzichte van DBRX, Llama en Mixtral

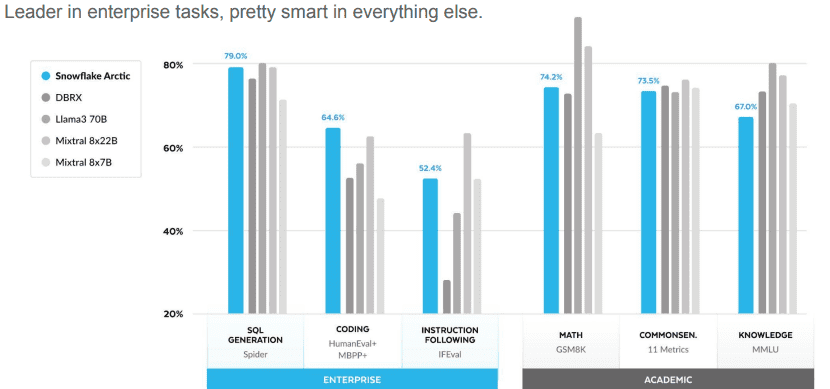

Door te kiezen voor de MoE-architectuur, wil Snowflake Arctic geschikt maken voor de complexe workloads van enterpriseorganisaties. De eerste differentiator (onderscheidende factor) die Snowflake claimt noemt het bedrijf ‘Enterprise Intelligence’. Dat wil zeggen dat Arctic vooral goed is in de taken van grote enterprise organisaties. Snowflake deelt de benchmarks tijdens de presentatie op in twee soorten: enterprise en academisch. Vooral in de Enterprise-categorie (Spider-benchmark voor SQL en HumanEval+ MBPP+-benchmark voor coderen) presteert Arctic goed. In de academische sectie (zoals wiskundige berekeningen en algemene kennis) moet Arctic vaak zijn meerdere erkennen in concurrerende modellen. Hieronder de vergelijkingen die tijdens de introductie zijn gedeeld.

Belangrijk om op te merken is dat taalbegrip, programmeren en wiskunde over het algemeen als de drie belangrijkste benchmarks worden gezien. Taalbegrip en wiskunde zijn dus gewoon goed bij Arctic, maar concurrenten scoren daar iets beter. Arctic blinkt dan weer uit in programmeren, waar de focus van Snowflake duidelijk op ligt.

Lees ook: Databricks komt met DBRX: open-source LLM dat GPT-3.5 en Llama 2 verslaat

Wat maakt Arctic verder interessant?

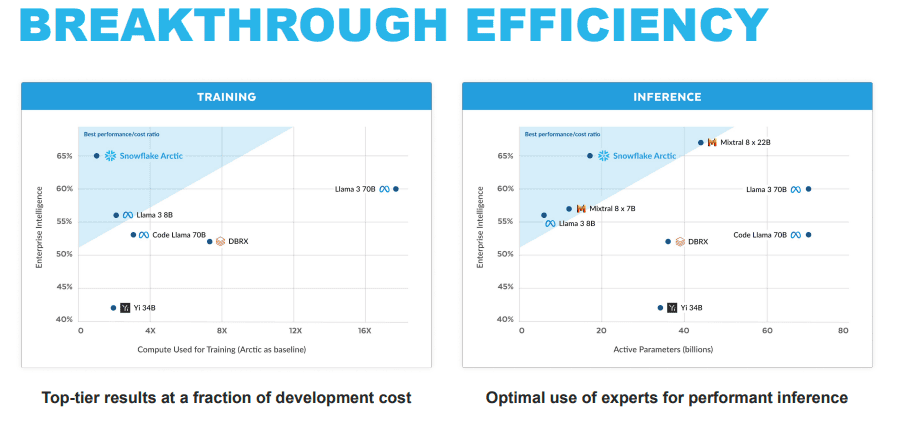

De andere twee differentiators die Snowflake aanstipt, zijn ‘Breakthrough Efficiency’ en ‘Truly Open’. Met de efficiëntie doelt Snowflake op de training- en inference-prestaties. Het onderzoeksteam zou minder dan drie maanden nodig hebben gehad voor Arctic en grofweg een achtste van de trainingskosten van vergelijkbare modellen hebben besteed. Het LLM is “getraind door Amazon Elastic Compute Cloud (Amazon EC2) P5-instances. Snowflake zet hiermee een nieuw basisniveau voor hoe snel state-of-the-art open, enterprise-grade modellen kunnen worden getraind, waardoor gebruikers uiteindelijk kostenefficiënte aangepaste modellen op schaal kunnen maken”, aldus het databedrijf. Hieronder nog wat vergelijkingen over de training en inference.

Het laatste onderscheidende factor, ‘Truly Open’, is met name een verwijzing naar het vrijgeven van de Arctic model weights onder een Apache 2.0-licentie en de details van het onderzoek dat heeft geleid tot hoe het model is getraind. Later lijkt dan ook meer bekend te worden over de gebruikte data bij het trainingsproces.

Al met al stelt Snowflake vandaag een interessant model aan de wereld voor. Het bedrijf stapt weliswaar later dan concurrenten in het LLM-geweld, maar kan met name vertrouwen op goede prestaties bij de programmeertests. Het wordt interessant om te zien hoe de markt gaat reageren op het nieuwste LLM.