Het nieuwe general purpose large language model moet organisaties helpen generatieve AI-apps te realiseren die zeer goed presteren.

Databricks wil dit bereiken door DBRX te laten vertrouwen op een mixture-of-experts (MoE)-architectuur, gebaseerd op het open-source project MegaBlocks. MoE adresseert met name de beperkingen van GPT-achtige architecturen (dense modellen) door computationele lagen op te splitsen in meerdere onderdelen (experts), die elk hun eigen berekeningen uitvoeren. Nieuwe invoer voor het model maakt alleen gebruik van de benodigde experts, waarna de output wordt samengebracht om tot de juiste respons van het model te komen.

Door de MoE-architectuur te gebruiken, kunnen modellen getraind worden met minder compute resources. Dit belooft dezelfde modelkwaliteit als dense modellen, terwijl het trainingsproces sneller verloopt dan bij MoE. Databricks beweert dat DBRX zeer hoge prestaties behaalt en tot twee keer zo efficiënt is qua rekenkracht als vergelijkbare LLM’s. “DBRX maakt gebruik van een mixture-of-expertsarchitectuur, waardoor het model extreem snel is in termen van tokens per seconde en kosteneffectief is”, reageert co-founder en CEO Ali Ghodsi.

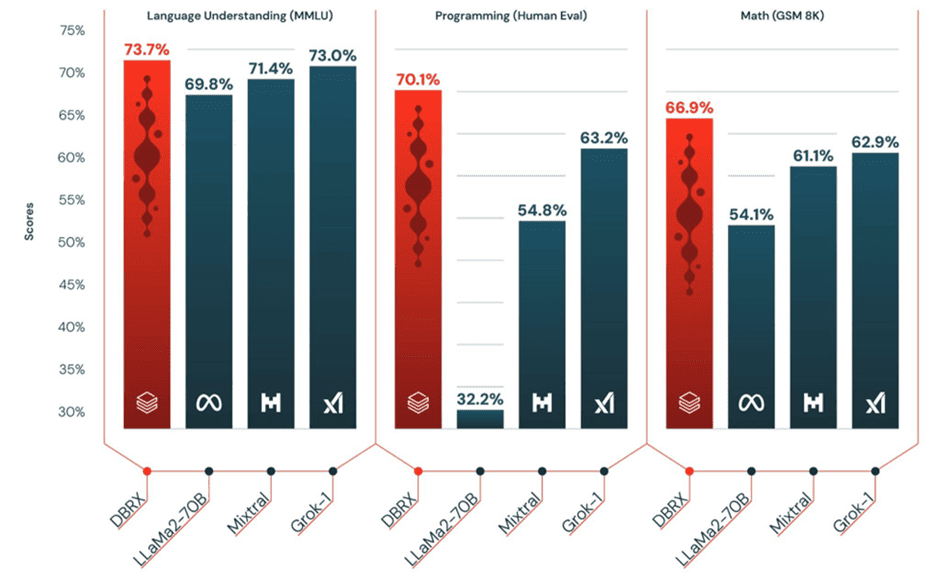

Prestaties ten opzichte van Llama, Mixtral-8x7B, GPT-3.5 en GPT-4

De hoge prestaties onderbouwt Databricks door benchmarks aan te leveren. Allereerst door de DBRX te vergelijken met open-source LLM’s Llama 2 70b van Meta en Mixtral-8x7B van Mistral AI. Het nieuwe Databricks-model presteert beter op taalbegrip, programmeren en wiskunde. Grok-1 van xAI komt wat meer in de buurt van de prestaties van DBRX, maar zit qua performance in de meeste tests wel enkele procenten van het Databricks-model af. Onderstaande afbeelding laat de benchmarks zien van de vergelijkbare open-source modellen.

Ghodsi voegt hieraan toe dat DBRX “GPT-3.5 op de meeste benchmarks verslaat, wat de trend zou moeten versnellen die we bij ons klantenbestand zien nu organisaties bedrijfseigen modellen vervangen door open source-modellen”. GPT-3.5 is in tegenstelling tot DBRX echter niet open-source. in de MMLU-benchmark voor taalbegrip scoort GPT-3.5 70 procent, in de Human Eval-benchmark voor programmeren 48,1 procent en in de GSM 8K-benchmark voor wiskunde 57,1 procent. Zoals je in bovenstaande grafiek kunt zien, zijn deze scores van GPT-3.5 lager dan die van DBRX.

Databricks maakt aanvullend zelfs de claim dat het kan concurreren met GPT-4 op een interne use case als SQL. Daar hebben we op het moment van aankondiging geen benchmark van om de claim te bevestigen. Uiteraard zijn er wel benchmarks van GPT-4 voor taalbegrip, programmeren en wiskunde: respectievelijk een score van 86,4 procent, 76,5 procent en 96,8 procent. Op die vlakken scoort GPT-4 nu dus aanzienlijk beter dan DBRX.

Tip: LLM voor Europa: Mistral AI zet Europa op de AI-kaart

Combineren met Databricks-technologie

Het nieuwe model DBRX is gratis beschikbaar op GitHub en Hugging Face, voor zowel commerciële- als onderzoeksdoeleinden. Wel geeft Databricks aan dat de combinatie van DBRX met het Data Intelligence Platform van het platform tot voordelen leidt. Via het platform kunnen bedrijven namelijk aanpasbare DBRX-modellen bouwen met eigen private data en zijn de context-mogelijkheden van retrieval augmented generation (RAG)-systemen te gebruiken.

Het Mosaic AI-onderdeel van het Data Intelligence Platform helpt daarbij om snel generatieve AI-apps te bouwen en implementeren. Veiligheid en nauwkeurigheid staan daarbij centraal. De mogelijkheden voor databeheer, governance, dataherkomst en monitoring van het Data Intelligence Platform moeten het DBRX-model afmaken.

Databricks spreekt sinds enkele maanden meer over het Data Intelligence Platform, in plaats van het lakehouse. In een los artikel gaan we in op wat dit platform voor bedrijven kan betekenen.