Tijdens de Snapdragon Summit op Maui gaf Cristiano Amon, de CEO van Qualcomm, een inkijkje in waar het (mobiele) ecosysteem dat zij voorzien van chips naartoe beweegt. Qualcomm voorziet een toekomst waarin AI verplaatst van de cloud naar je apparaten en je op alle mogelijke manieren wordt ontzorgd.

We waren op uitnodiging van Qualcomm aanwezig op de Snapdragon Summit en daar werden twee nieuwe chips gepresenteerd. Een nieuwe smartphone en een nieuwe compute-chip. Die laatste is vooral bedoeld voor laptops en mini-pc’s.

In deze nieuwe chips zien we de standaard verbeteringen op het gebied van CPU en GPU, maar de focus lijkt vooral te gaan naar de zogenaamde NPU. Deze wordt gebruikt door AI-modellen. Hoe beter de NPU, hoe hoger het aantal TOPS en hoe beter de chip in staat is om AI-opdrachten (inferencing) uit te voeren.

AI komt nu nog vooral uit de cloud

Op dit moment draaien de meeste AI-modellen nog in de cloud. Veel mensen die gebruik maken van AI doen dit via ChatGPT, Claude, CoPilot, Gemini of ingebouwde AI-functies in software-oplossingen. Deze maken eigenlijk allemaal gebruik van AI-modellen die in de cloud draaien.

Dit gaat niet zo blijven. Het is vrijwel onmogelijk om de hele wereld te voorzien van AI-features vanuit de cloud. Wat we zullen gaan zien is dat geleidelijk steeds meer “eenvoudige” AI-taken naar het apparaat verplaatst zullen worden. Het bewerken van foto’s, genereren van e-mail teksten, plannen van taken en afspraken in je agenda zijn eenvoudige zaken die lokaal door AI kunnen worden opgepakt.

Kleine AI-modellen worden steeds beter

Een paar jaar geleden dachten we nog dat AI-modellen enkel beter werden naarmate ze in omvang toenamen. Die theorie is inmiddels achterhaald, we zien nu steeds meer kleinere modellen ontstaan die vele malen beter zijn.

Er zijn ook al diverse modellen die je op laptops en high-end smartphones kan draaien. OpenAI heeft het gpt-oss-20B model, Google heeft Gemini Nano en Meta heeft kleinere Llama-modellen. Maar er zijn nog tientallen andere kleine modellen.

Het belangrijkste is dat die modellen alsmaar beter worden en in staat zijn om lokaal taken uit voeren en dingen te genereren die voorheen in de cloud moesten. Hierdoor gaan de kosten omlaag en ontstaan er nieuwe mogelijkheden.

Qualcomm’s visie voor de lokale AI-assistent

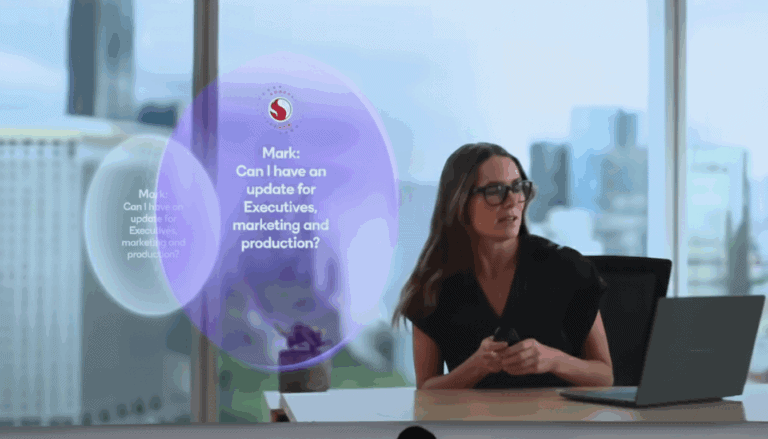

Qualcomm’s visie is dat al je apparaten, denk aan je smartphone, smartwatch, AR-glasses (slimme bril), earbuds en zelfs je auto gaan samenwerken als jouw persoonlijke AI-assistent. De visie is dat deze apparaten samen met het applicatie-ecosysteem continu voor je aan het werk zijn en je op de momenten dat het je uitkomt ondersteunen bij je werkzaamheden.

Enkele voorbeelden:

- Je krijgt een e-mail van een collega of je wat documenten kunt doorsturen, de AI-assistent detecteert om welke documenten het gaat en vraagt of ze doorgestuurd mogen worden naar collega;

- Je slimme bril ziet continu wat jij ziet en kan ook mensen herkennen en je helpen namen te onthouden of simpelweg detecteren dat er een bekende van je in de buurt is;

- Detecteren wanneer er problemen in je agenda ontstaan, als je bijvoorbeeld te laat gaat komen. Of wanneer je nog een restaurant moet reserveren. De AI-assistent kan dat dan voor je doen.

Context-aware 2.0

AI functioneert het beste wanneer de context duidelijk is. Dat geldt zowel voor het uitvoeren van opdrachten, als het moment waarop AI actief is. Doordat je apparaten straks continu gaan meekijken en zich mee bewust zijn waar je bent en wat je aan het doen bent, wordt de context nog duidelijker. De AI-assistent kan hierdoor ook veel beter timen wanneer die je stoort met vragen.

Als je bijvoorbeeld in je auto onderweg bent naar je volgende afspraak, kan de AI-assistent je gaan vragen om enkele zaken door te nemen. Zoals de eerder genoemde voorbeelden. Dit zal dan hopelijk niet meer gebeuren, op het moment dat een vraag binnenkomt, of wanneer een afspraak op het punt staat te beginnen.

Van apparaten gebruiken naar apparaten die ons dienen

Daarmee zal de manier waarop we veel apparaten gebruiken ook gaan veranderen. In plaats van dat we een apparaat erbij pakken om iets op te zoeken of in te plannen, zal de AI ons zodanig ondersteunen dat dit niet langer nodig is. Als iemand een afspraak met je wilt maken zal AI een voorstel doen waar je enkel nog akkoord op moet geven. De AI is als het ware de nieuwe gebruikersinterface van de toekomst.

De toekomst van AI is hybrid

Uiteindelijk zal de toekomst niet volledig AI op het device (edge) zijn of volledig in de cloud, maar eerder een hybride vorm. Waarbij eenvoudige taken lokaal worden afgewikkeld op het apparaat en meer complexe taken terugvallen op de cloud, waar veel meer rekenkracht beschikbaar is.

Alles draait om agents

Tot slot zal er iets van een orchestratielaag nodig gaan zijn. Die komt ongetwijfeld voort vanuit een applicatie-ecosysteem. Dat kan op besturingssysteemniveau zijn, maar ook op het niveau van een zakelijke workplace-oplossing. Iets wat alle informatie van de AI-agents ontvangt en vervolgens interpreteert naar gepaste acties.

Uiteindelijk wil je dat de AI-assistent je stoort op momenten dat het ook kan. Niet midden in de nacht of tijdens een meeting. Maar wel als je onderweg bent naar een afspraak en in de auto zit. Of wanneer je even koffie bent halen. Ook wil je niet dat zowel je smartphone, slimme bril, smartwatch en auto je meldingen geven over het feit dat je te laat komt voor je afspraak van 16:00. De orchestratielaag zal moeten bepalen welk apparaat het beste is in welke situatie. Volgens Amon wordt het “de meest persoonlijke technologie ooit.”

Daarvoor is de data die op de edge op je apparaten worden verzameld extreem belangrijk. Die kunnen bepalen wat je huidige persoonlijke context is. In een meeting, in de auto, onderweg naar de koffieautomaat of misschien wel op het toilet.

Qualcomm levert chips en toont visie; de AI komt van een ander

Uiteindelijk is Qualcomm “slechts” de chipleverancier. Het toont hier een visie hoe AI kan gaan werken op allerlei slimme apparaten waarvoor zij de chips en daarmee de rekenkracht voor AI kunnen leveren. Het is echter aan de Google, Samsung’s en Microsoft’s van deze wereld om die AI visie realiteit te laten worden. Hoelang dat nog gaat duren is moeilijk te voorspellen, maar we gaan de komende jaren ongetwijfeld elk jaar een stapje dichterbij deze visie komen.