Van alle data workloads die bedrijven tegenwoordig krijgen te verwerken, is slechts een klein gedeelte echt belangrijk om daartoe direct toegang te hebben. De rest van de data workloads kan daardoor mogelijk overlast veroorzaken omdat ze zich overal in het netwerk bevinden. Deze zogeheten secundaire data kunnen dus het beste ergens anders worden bewaard. Tijdens Cisco Live in Barcelona maakten we kennis met Cohesity dat met zijn platform juist deze ‘secundaire data’ opvangt en daardoor bedrijven helpt zich beter op de echt voor hun business benodigde data te kunnen richten.

Wie op de laatste editie van Cisco Live EMEAR rondliep, kan het niet zijn ontgaan dat de Amerikaanse netwerk-, data-, en cloudleverancier ook over een groot ecosysteem van andere leveranciers beschikt. Dit ecosysteem bestaat concreet uit een aantal pijlers om vooral innovatie te bewerkstelligen. Naast flinke investeringen in eigen R&D neemt het Amerikaanse bedrijf constant bedrijven over om hun technologie te gebruiken om de eigen Cisco-technologie uit te breiden, zoals Meraki, AppDynamics en Broadsoft. Cisco gaat natuurlijk ook samenwerkingen aan met bedrijven die belangrijk zijn voor de eigen oplossingen, onder meer met NetApp of Ericsson.

Het ecosysteem wordt vervolmaakt met vaak opkomende partijen, merendeels scale-ups, waarin Cisco investeert als goede match voor toekomstige innovatie. Het gaat hierbij om een flink bedrag, jaarlijks tussen de 250 en 300 miljoen dollar, zo kregen we te horen. Bedrijven waarin wordt geïnvesteerd bevinden zich op diverse terreinen zoals storage, DevOps of voor IoT-toepassingen.

Cohesity en secundaire data

Een van de bedrijven waarin Cisco investeert, is de Amerikaanse software defined storage scale-up Cohesity. Dit bedrijf, in 2013 opgericht door CEO en voormalig medeoprichter van Nutanix Mohit Aron, richt zich met een eigen platform en diensten op het consolideren en beheren van ‘secundaire data’.

Secundaire data zijn gegevens die bestaan uit onder andere de back-ups van de primaire data, gearchiveerde gegevens of data die worden gebruikt voor testen, bepaalde objecten en analytics. Kortom, alle data die niet direct voor de belangrijkste processen binnen bedrijven en organisaties hoeven te worden gebruikt.

Meer kosten en ‘dark data’

Veel van deze data zwerven door de hele (datacenter)netwerkinfrastructuur van bedrijven, in applicaties, maar ook binnen de diverse (multi)cloudomgevingen, bijkantoren en edge-locaties. Hierdoor ontstaat er een grote fragmentatie en heeft dit onder meer tot gevolg dat data moeilijk terug kunnen worden gevonden.

Naast moeilijk beheer, speelt er natuurlijk ook een grote kostencomponent. Doordat de data op verschillende plekken staan opgeslagen, kan het voorkomen dat overal meerdere datasets met dezelfde informatie terug te vinden zijn. Dit betekent weer kosten voor meer storage-appratuur en voor het beheer ervan. Tot slot heeft al deze gefragmenteerde data tot gevolg dat het onbekend wordt waar alle data staan en wat ze inhouden. Dit noemt Cohesity het ontstaan van zogeheten ‘dark data’.

De leverancier geeft aan dat voor bedrijven en organisaties het beheer en opslag van deze secundaire data dus een groot probleem vormt. Volgens Cohesity zou slechts 20 procent van alle binnen bedrijven aanwezige data ‘primaire data’ zijn en dus essentieel voor de dagelijkse gang van zaken. De overige aanwezige data zijn dus de gegevens die niet direct noodzakelijk zijn en dus als secondair kunnen worden geclassificeerd.

Softwaregebaseerd dataplatform en diensten

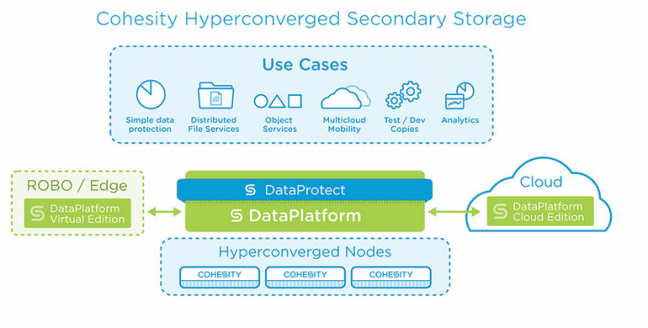

Om aan de grote fragmentatie van alle data een eind te maken en ervoor te zorgen dat bedrijven en organisaties volledig en zonder problemen hun primaire data kunnen gebruiken voor hun belangrijke zakelijke doeleinden, ontwikkelde Cohesity zijn DataPlatform en overige diensten voor secundaire data.

Dit softwaregebaseerde dataplatform of Hyper-Converged Secondary Storage (HCSS), eigenlijk het belangrijkste product dat de storage scale-up levert, zorgt ervoor dat alle secundaire data op een enkele plek gecontroleerd wordt geconsolideerd, opgeslagen en beschikbaar gesteld. Dit alles inclusief de verschillende back-ups, de benodigde kopieën om testen uit te kunnen voeren, files, objects en data voor analytics. Het platform fungeert eigenlijk als een soort van besturingssysteem dat zaken als deduplicatie, compressie en de optimalisatie van de data regelt.

Daarnaast zorgt het DataPlatform ervoor dat file en object data onbeperkt kan worden uitgebreid en beheerd, biedt het geautomatiseerd policy-beheer en wordt de data-integriteit onder alle omstandigheden gewaarborgd. Ook biedt het platform een oplossing voor disaster recovery.

Recent werd hier nog een specifieke dienst aan toegevoegd die direct ransomware-aanvallen kan voorkomen en detecteren. In het geval het noodlot toch heeft toegeslagen, kan deze dienst bedrijven helpen om op deze extreem kwaadaardige aanvallen een antwoord te geven. Hiermee zorgt het platform ervoor dat de hackers in het gareel worden gehouden en tegelijkertijd de voortgang van de zakelijke activiteiten kan worden gegarandeerd.

Koppeling met (multi)cloudomgevingen

Het Cohesity DataPlatform koppelt de cloudomgevingen AWS en Google Cloud Platform (GCP) voor het ophalen en opslaan van data of applicaties. Vanzelfsprekend wordt natuurlijk ook Microsoft Azure ondersteund.

Verder worden diensten als databescherming, analytics en geautomatiseerd databeheer vanuit het platform zelf uitgevoerd. Dit om testers en eindgebruikers van analytics meer mogelijkheden te kunnen geven.

Agnostisch voor onderliggende hardware

Tijdens het evenement in Barcelona zagen we het Cohesity DataPlatform in werking met natuurlijk de onderliggende hardware-infrastructuur van Cisco en dan in het bijzonder HyperFlex. Ook kan het platform op ‘gewoon’ UCS (Unified Computing Servers) van Cisco draaien. In de configuratie met Cohesity blijven de belangrijke primaire data opgeslagen binnen HyperFlex en verhuist de secundaire data naar het DataPlatform.

Het platform wordt dus voor de daatcenteromgeving op de HyperFlex-infrastructuur geleverd, maar voor toepassing op de rand van het netwerk kan dit ook met een virtuele node. Ook is het voor deze edge-omgeving mogelijk het DataPlatfom virtueel te laten draaien in (multi)cloudomgevingen, specifiek AWS en GCP, maar ook op de cloudproposities van door de storagespecialist geaccrediteerde andere S3 serviceproviders.

Verder is de oplossing van de opslagspecialist niet ook exclusief voorbehouden aan alleen de (Hyper-Converged) hardware-infrastructuuroplossingen van Cisco. Het DataPlatform draait net zo goed op de HCI-toepassingen van onder meer HPE. De virtuele node-oplossing is ook geschikt voor VMware vSphere.

Overige geleverde diensten en tools

Naast het DataPlatform als belangrijkste product, biedt de storage scale-up nog meer diensten. Zo biedt DataProtect een totaaloplossing voor het beschermen van fysieke en virtuele workloads en primaire data waar deze zich ook in de complete netwerkomgeving bevinden. De oplossing verenigt back-up, recovery, replicatie, target storage en storage in (multi)cloudomgevingen in een enkel webgebaseerd platform met een duidelijke interface.

Eindgebruikers kunnen daarnaast bestaande licenties van andere back-up en replicatie-oplossingen als VMware, Hyper-V, Nutanix AHV en KVM in het platform integreren. Op hardware-vlak werkt DataProtect samen met onder meer snapshot-based protection voor Pure Storage FlashArray’s, FlashBlade, NetApp en Dell EMC Isilon, als ook NAS-devices en zelfs tape-opslagoplossingen.

Visibility en analytics

Andere tools die de storagespecialist nog naast zijn DataPlatform biedt, zijn onder meer Helios voor het verkrijgen van een compleet overzicht van alle secundaire data waar zij ook staan. De tool biedt ondersteuning voor realtime monitoring en multi-clusterbeheer. Helios zet hier onder meer kunstmatige intelligentie in de vorm van machine learning in.

De tool Analytics Workbench maakt het gebruikers van het Cohesity-DataPlatform mogelijk om daarbinnen diepere analyses op de secundaire data los te laten. Deze analyses kunnen onder meer worden gebruikt om speciale applicaties voor deze secundaire data te ontwikkelen, compliance te verzorgen of om bepaalde bedreigingen het hoofd te kunnen bieden.

Voorzien in een niche

Cohesity biedt dus interessante oplossingen om het probleem van de enorme datafragmentatie waarmee bedrijven steeds meer te maken krijgen op te lossen. Door zich vooral te richten op de 80 procent secundaire data voorziet het bedrijf in een niche waar gezien de grote data-explosie van de komende jaren veel vraag naar zal komen.

De cloudspecialist doet dit met zijn DataPlatform dat goed samenwerkt met HCI-toepassingen van grote leveranciers als Cisco en HPE. Wel is het de vraag of deze hardware-infrastructuren nog met andere merken worden uitgebreid, zoals met die van Dell EMC of Lenovo. Dan wordt de oplossing nog voor veel meer bedrijven interessant, zo lijkt ons.

De extra diensten als back-up, deduplicatie, objectbeheer en meer geavanceerde toepassingen als analytics maken het platform voor veel potentiele gebruikers alleen nog maar aantrekkelijker. Ook de overige diensten van Cohesity sluiten hier vanzelfsprekend op aan.

Kortom, het bedrijf lijkt op de goede weg te zitten met zijn storage-portfolio en oplossingen voor secundaire data. We blijven het nauwlettend volgen.