Ook HPE ontkomt niet aan de AI-ontwikkelingen van de laatste tijd. Het maakt LLM’s bereikbaar voor meer organisaties door middel van HPE GreenLake for Large Language Models. Voor HPE is dit nog maar het begin van de AI-reis.

LLM’s zijn zonder meer interessant voor een uitgebreid scala aan toepassingen. Publieke LLM’s zijn echter vooral leuk en interessant voor zoekmachines en andere vooral op consumenten gerichte toepassingen. De toekomst van AI en ook van LLM’s voor organisaties ligt daar niet, is onze stellige overtuiging. Er zijn behoorlijk wat organisaties die hun data niet naar een publieke dienst mogen of willen sturen. Ook als er met ChatGPT Business een versie van ChatGPT komt die niets deelt met het openbare model om dat beter te maken, is dat nog steeds een publiek model. Hiermee zeggen we overigens niet dat er geen enkele use-case te bedenken valt voor publieke LLM’s bij organisaties. Maar de meest kritieke processen zullen er niet aan blootgesteld worden.

HPE GreenLake for Large Language Models

De grote vraag is hoe organisaties dan wel aan de slag moeten gaan met LLM’s. Ze kunnen zelf investeren in een supercomputer, maar dat is voor slechts enkele organisaties weggelegd. Nog los van de kosten, heb je daar ook heel veel specialistische kennis voor nodig en duurt het lang voordat alles draait. LLM’s trainen in de public cloud haalt die laatste hordes weg, maar dan heb je weer weinig controle en kunnen de kosten ook stevig oplopen door egress fees. Daarnaast kun je twisten over de HPC-capaciteiten van de public cloud vergeleken met die van gespecialiseerde systemen.

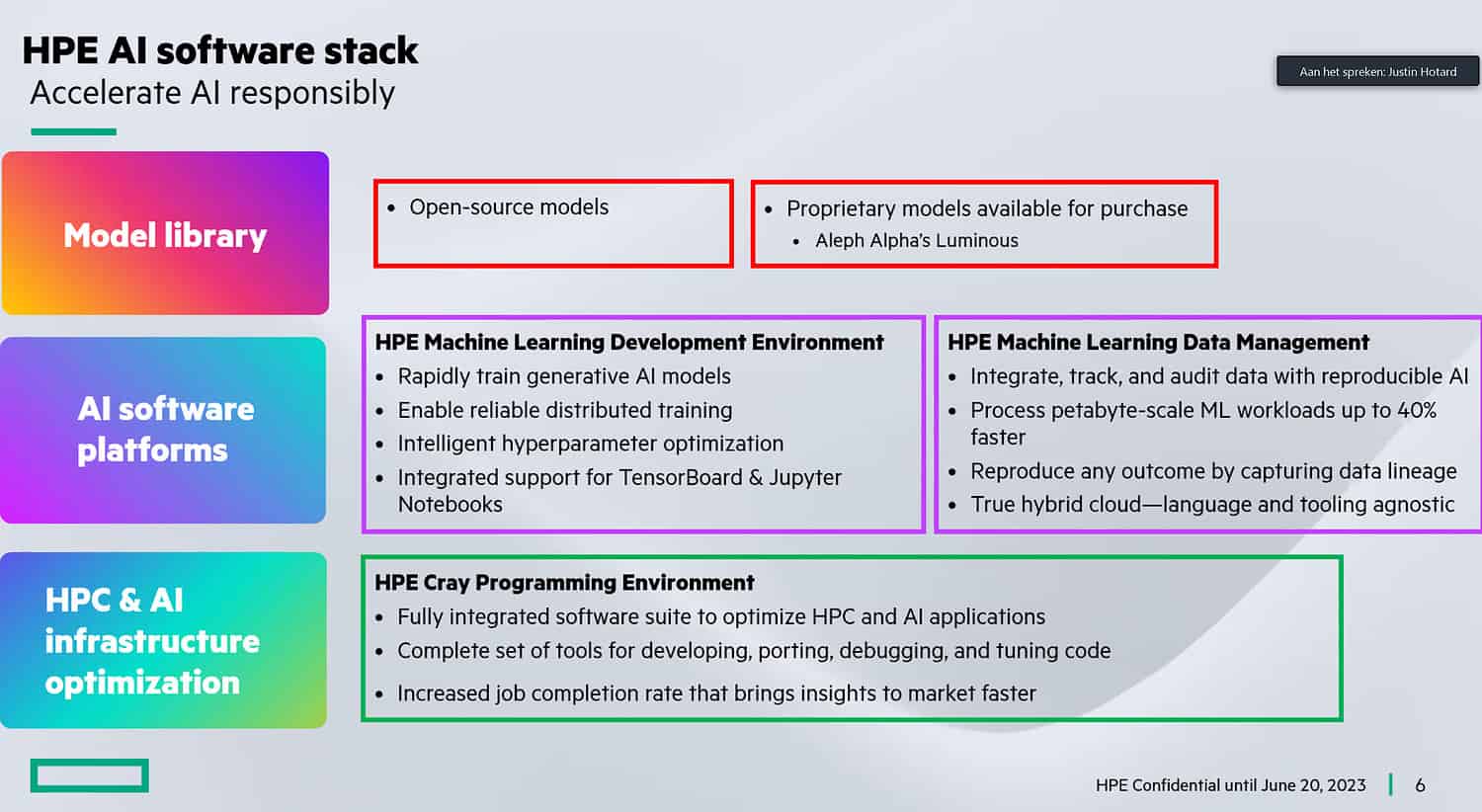

HPE ziet een gat in deze markt, waarbij het wil proberen om het beste van beide werelden te bieden. Dat wil zeggen, het wil het trainen van LLM’s als een dienst aanbieden, maar dan wel op een infrastructuur die ervoor is ontwikkeld. Dat kan HPE doen, omdat het Cray in het portfolio heeft. Dit bedrijf, sinds de overname door HPE heet het officieel HPE Cray, heeft een lange historie op het gebied van supercomputing. HPE koppelt deze krachtige hardware nu dus aan het HPE GreenLake-platform. Dit moet LLM’s bereikbaar maken voor veel meer klanten. Die kunnen daar met zowel open-source modellen als met propriëtaire modellen aan de slag.

Een voorbeeld van zo’n laatste model is Luminous van Aleph Alpha. Dit model is beschikbaar voor Engels, Frans, Duits, Italiaans en Spaans. Organisaties kunnen hiermee hun eigen data inzetten om een AI-model te trainen en finetunen specifiek gericht op de eigen wensen.

HPE heeft grote plannen voor AI

Het blijft niet bij HPE GreenLake for Large Language Models, belooft HPE nu alvast. Dit is natuurlijk een logisch startpunt, want generatieve AI en LLM’s zijn nu eenmaal erg populair op dit moment. Richting de toekomst heeft HPE nog veel meer in petto voor deze combinatie van Cray en GreenLake. Het gaat werken aan toepassingen voor het maken van klimaatmodellen, medicijnenonderzoek, de financiële dienstverlening en ga zo maar door. Daarnaast ondersteunt het nieuwe platform ook HPE’s eigen AI/ML-software. Denk hierbij aan de HPE Machine Learning Development Environment om modellen te trainen en HPE Machine Learning Data Management Software om er zeker van te zijn dat de modellen betrouwbaar en accuraat zijn.

We hebben het laatste dus nog niet gehoord van HPE als het gaat om AI. De eerste dienst is er met HPE GreenLake for Large Language Models eind van dit jaar in de VS. Europa volgt begin 2024. Het is op dit moment al wel mogelijk om de nieuwe dienst aan te vragen.