Intel Optane, Storage Class Memory, NVMe over Fabric, HPE’s The Machine: de toekomst van de computer staat bol van moeilijke termen. Wat betekenen ze nu precies, en welke invloed hebben ze op het datacenter van morgen?

HPE is er al enkele jaren zeker van: de traditionele computerarchitectuur, waarbij de cpu zijn naam alle eer aan doet en centraal staat, volstaat niet om het hoofd te bieden aan de uitdagingen van vandaag. De schuldige: data. Of concreter: de enorme hoeveelheden data die bedrijven vandaag vergaren. Die terabytes aan potentieel waardevolle gegevens vergaren veelal stof op harde schijven of, als daar budget voor is, SSD’s.

Als data goud is, dan zijn die talrijke opslagservers de grond waaruit dat goud moet worden ontgonnen. De gegevens analyseren, waardevolle inzichten distilleren en vervolgens meerwaarde creëren door actie te nemen, vereist veel rekenkracht. Die wordt traditioneel voorzien door de cpu (of een cluster van krachtige cpu’s). De data wordt gelokaliseerd op trage opslagservers, gaat vervolgens naar het geheugen waar algoritmes ermee aan de slag gaan, vertrouwend op de rekenkracht van de cpu. De afstand tussen de cpu en de dataservers is echter te groot, en dat bemoeilijkt een efficiënte analyse.

Cache en DRAM

Een oplossing is om de opbouw van de traditionele computerinfrastructuur in vraag te stellen. Vandaag heeft een cpu een handvol kilobytes tot enkele megabytes erg duur, maar ultrasnel geheugen aan boord (het L1-, L2-, L3- en soms L4-cachegeheugen). Daarin zit de data die de processor op dat moment nodig heeft. De data is afkomstig vanuit het RAM-geheugen. DDR4-DRAM-geheugen is aanzienlijk goedkoper dan cachegeheugen, maar nog steeds relatief duur. Een gewone pc of workstation heeft 8 tot 32 of zelfs 64 GB RAM aan boord, terwijl krachtige servers met enkele honderden gigabytes aan RAM overweg kunnen. RAM blinkt uit in supersnelle random-toegang met een zo laag mogelijke latency. Net als cachegeheugen is RAM vluchtig. Dat wil zeggen dat data actief in het geheugen wordt gehouden en verdwijnt wanneer de stroomtoevoer wegvalt.

“De traditionele computerarchitectuur volstaat niet om het hoofd te bieden aan de uitdagingen van vandaag”

Om die praktische, maar zeker ook financiële, redenen is er een onderscheid tussen bovenstaand werkgeheugen en klassiek opslaggeheugen. Voor opslaggeheugen primeert de prijs. Trage harde schijven worden nog steeds het meest gebruikt, al zijn zeker in pc’s SSD’s vandaag populairder. Ook in datacenters zijn SSD-oplossingen in opmars. Een SSD is veel sneller dan een HDD, maar nog steeds een stuk trager dan DRAM. Opslaggeheugen houdt data bovendien bij tijdens een stroomonderbreking.

Op zoek naar beter

Onderzoekers van onder andere Intel, Micron en HPE werken al enkele jaren aan versies van geheugen die de snelheid van DRAM combineren met de permanentie en de lagere kostprijs van opslaggeheugen. Dergelijk geheugen maakt het onderscheid tussen DRAM en HDD’s of SSD’s overbodig. Data zou in grote hoeveelheden veel sneller toegankelijk kunnen zijn. De rekenkracht zou bovendien naar de data kunnen gaan, in plaats van de omgekeerde beweging waarbij data naar de cpu wordt gehaald.

Die zoektocht uit zich in het ontstaan van verschillende nieuwe hybride types geheugen en slimme nieuwe protocollen.

Persistent Memory en SCM

Een eerste incarnatie hiervan is Persistent Memory, wat zoveel betekend als geheugen dat dubbel dienstdoet als opslagmedium. Persistent Memory wordt net als DRAM aangesloten via het DIMM-slot van het moederbord en zit dus zo dicht bij de cpu als mogelijk. De populairste standaard op dit moment is NVDIMM-N. Een NVDIMM-N-latje bestaat uit enkele gigabytes aan klassiek DRAM-geheugen, met daarachter een equivalente hoeveelheid NAND-geheugen (NAND is een vorm van flashgeheugen waar SSD’s gebruik van maken). Het snelle DRAM-geheugen dient voor de operationele werking, terwijl NAND als back-up dienstdoet in geval de stroom wegvalt of een systeem in- en uitgeschakeld wordt.

Storage Class Memory (SCM) is een variant van Persistent Memory. Ook hier worden DRAM en NAND gecombineerd. Het snelle DRAM-geheugen doet dienst als cache, maar de hele capaciteit van het NAND-geheugen wordt door een computer als beschikbaar geheugen gezien. Een systeem ziet SCM-geheugen als gewoon geheugen. Het SCM-geheugen heeft als groot voordeel dat het significant goedkoper is dan eenzelfde capaciteit die uit pure DRAM bestaat. Bovendien is het niet vluchtig. Daar staat tegenover dat de oplossing een stuk trager is dan pure DRAM.

NVMe op afstand

Een tweede aanpak op de weg naar een geheugencentrale computerarchitectuur is NVMe over Fabric (NVMe-oF). NVMe is een standaard die toelaat om met SSD’s te communiceren via de PCIe-interface (als alternatief voor de veel tragere SATA-interface). PCIe zit verder van de cpu dan de DIMM-sleuven, maar is nog steeds supersnel. Het is de interface waarmee je bijvoorbeeld ook een krachtige grafische kaart op een systeem aansluit.

Lees dit: Dell EMC PowerMax: wanneer snelle opslag prioriteit wordt

Moderne laptops hebben bijna allemaal een systeemgeheugen dat bestaat uit een NVMe-SSD. Voor gebruik op grote schaal in datacenters brengt NVMe weinig soelaas, aangezien data vaak is opgeslagen in storageservers die gescheiden zijn van de fysieke rekenservers. Wat NVMe over Fabric is, kan je misschien al raden. Het is een afgeleide van de NVMe-standaard, die de voordelen van NVMe mogelijk maakt via een storageserververbinding. Eén van de belangrijkste doelstellingen van NVMe-oF is een latency van minder dan 10 microseconden. NVMe kan je zo zien als een performante opvolger van SCSI op maat van de snelste en nieuwste SSD’s.

Waar Persistent Memory en SCM dus traditionele opslag combineren met DRAM om RAM-geheugen persistent te maken, zorgt NVMe-oF er eerder voor dat opslag veel sneller toegankelijk wordt in een traditionele configuratie.

3D XPoint: ideale hybride

Eer derde optie ken je waarschijnlijk onder de merknaam Optane. Optane is een vorm van 3D XPoint-geheugen (spreek uit cross point), ontwikkeld door Intel en Micron. Micron heeft een eigen merknaam voor het geheugen: QuantX. 3D XPoint is een nieuw type van geheugen dat het dichtst aanleunt bij persistent flashgeheugen (NAND), maar ook DRAM-eigenschappen heeft. In dat opzicht is het een vorm van geheugen die perfect lijkt voor een geheugencentrische computerarchitectuur. Concreet heeft het 3D XPoint-geheugen de low latency random access-eigenschappen van DRAM, maar is het niet volatiel en heeft het een hogere dichtheid, wat dan weer dichter aanleunt bij SSD-NAND.

Optane sluit je vandaag doorgaans aan via PCIe en werd in eerste instantie eerder lauw onthaald. Ondanks het technische hoogstandje was de meerwaarde tegenover de beschikbare alternatieven niet al te groot in deze vorm.

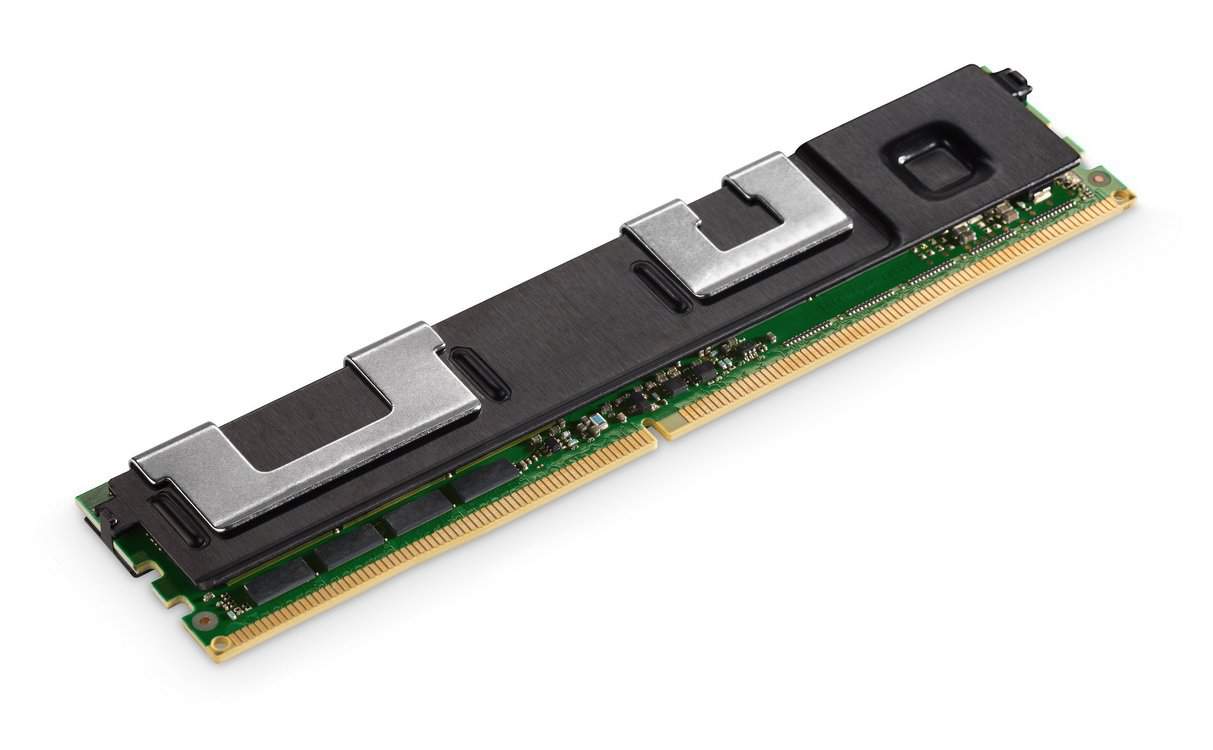

Eerder dit jaar kondigde Intel dan het eerste Optane-product aan waar techneuten wel warm van werden: een Optane-geheugenlatje in DDR4-DIMM-vormfactor. Dat latje past in het DIMM-slot en wordt herkend als DDR4-RAM (tenminste door Intels nieuwste Xeon-cpu’s). De latency is slechter vergeleken met DRAM, maar het geheugen is persistent én de capaciteit is veel groter. Intel zal versies tot 512 GB per Optane-latje in de markt zetten. Het is nog wachten tot volgend jaar voordat het stuk hardware effectief beschikbaar is. Pas dan zullen we ons kunnen uitspreken over de werkelijke meerwaarde van Optane, maar de theorie is veelbelovend.

The Machine

Tot slot is er nog The Machine. The Machine is een splinternieuwe computerarchitectuur ontwikkeld door HPE. De hardwarespecialist sleutelt er al aan van toen HPE en HP Inc. nog gewoon HP waren, en demonstreerde al dat de architectuur werkt. Voor The Machine gooide HPE alle conventies overboord.

De architectuur is helemaal gebouwd rondom geheugen, waarbij de computerkracht als het ware naar het geheugen toe komt. De cpu vraagt dus niet om de nodige data om een berekening uit te voeren, maar de te verwerken data vraagt naar de benodigde rekenkracht. Die omgekeerde manier van werken wordt mogelijk gemaakt door de integratie van optische verbindingen in het systeem. HPE is ervan overtuigd dat de werkelijke toekomst van big data analytics, en andere vormen van rekenwerk waarbij grote hoeveelheden geheugen nodig zijn, bij The Machine liggen.

Wat de toekomst ook brengt, één ding is zeker: geheugen wordt steeds belangrijker, en zowat iedereen is het eens over de meerwaarde van een liefdeskind tussen DRAM en NAND. De nieuwe technologieën zijn vooral belangrijk voor organisaties die de traditionele geheugen-opslagtandem als een flessenhals ervaren. On premises kan je natuurlijk experimenteren met de verschillende opties (als het IT-budget dat toelaat), maar ook in de cloud worden de nieuwe vormen van geheugen steeds belangrijker. Een The-Machine-in-de-cloud zal je nog niet meteen vinden bij AWS of Microsoft, maar Google biedt bijvoorbeeld sinds deze zomer al wel servers met Optane-geheugen aan, onder andere voor SAP HANA.