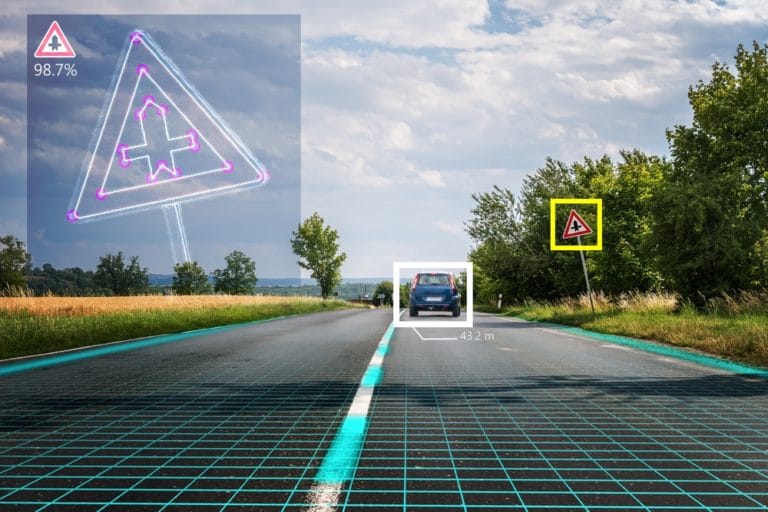

Computer vision-algoritmen blijken op een opvallende manier in de war te brengen te zijn. Wanneer er een volledig ongerelateerd object naast het bedoelde object staat, blijken computers niet meer te snappen wat ze zien. Door deze kennis toe te passen, kunnen bijvoorbeeld zelfrijdende auto’s gefopt worden.

Deze bevindingen delen Paul Ziegler, de CEO van Redflare, en Yin Minn Pa Pa, een onderzoeker bij Deloitte Tohmatsu in een bespreking van hun onderzoek genaamd “Hiding Objects From Computer Vision By Exploiting Correlation Biases” tijdens de Black Hat Asia-conferantie, waar The Register verslag van uitbrengt.

Algoritmen vertrouwen op context

De twee onderzoekers hebben gekeken naar meerdere computer vision-systemen, waaronder die van Microsoft en Google. Ze maakten gebruik van afbeeldingen uit de Common Objects In Context (COCO)-database. Ziegler en Pa Pa vertellen dat veel algoritmen context gebruiken om te begrijpen wat er op een afbeelding staat. Wanneer bij het object in kwestie echter iets wordt afgebeeld wat er niets mee te maken heeft, raakt het algoritme in de war. Een voorbeeld is dat een plant bijna nooit als zodanig wordt herkend als die is afgebeeld op een T-shirt. Wanneer een algoritme een persoon ziet, verwacht die namelijk niet in de context daarvan een plant te zien. Op dezelfde manier wordt een willekeurig rond object in de buurt van een hond al snel als een frisbee herkend, omdat het algoritme de correlatie van honden en het speelgoed heeft.

Verwarring schoppen

Die observering bracht de onderzoekers op het idee om te kijken of met die kennis de algoritmes ook opzettelijk voor de gek gehouden kunnen worden. Hieruit bleek dat wanneer honden en katten samen in een afbeelding werden gezet, de algoritmes dachten dat ze een paard zagen. Een zorgwekkender resultaat ontstond toen de onderzoekers het algoritme een foto van een stopbord met daarnaast een stuk fruit lieten zien. Het stuk fruit werd herkend, maar het stopbord niet. Ook andere vreemde combinaties van stopborden met andere objecten werden niet herkend.

Malafide toepassingen

Hieruit blijkt dat deze kennis gebruikt kan worden voor een aanval, waarbij een kwaadwillenden doelbewust rare objecten naast of een poster achter een stopbord neergezet kunnen worden om zelfrijdende auto’s fouten te laten maken. Hoe dit minder omslachtig is dan simpelweg het bord beschadigen of verwijderen, vertellen de onderzoekers niet. Andere doelen waar deze kennis voor kan worden ingezet, is het omzeilen van een uploadfilter voor bepaalde afbeeldingen of het verwarren van winkels die alleen met camera’s werken, zoals Amazon Go. De onderzoekers hebben dergelijke aanvallen niet uitgeprobeerd.

Tip: Unity verkoopt datasets van afbeeldingen voor AI-training