Microsoft heeft een tweetal Orca 2 ‘kleine’ LLM’s geïntroduceerd die qua prestaties niet onder doen van grote LLM’s van concurrenten.

Met de introductie wil Microsoft aantonen dat goed presterende LLM’s niet noodzakelijk grote hoeveelheden parameters nodig hebben om goede prestaties te leveren. Beide Orca 2 LLM’s zijn gebaseerd op het originele 13B Orca-model dat enkele maanden geleden werd gepresenteerd. Dit model liet sterke redeneringsmogelijkheden zien door stap-voor-stap de redeneringssporen van grotere en krachtigere modellen te imiteren.

Redeneringsmogelijkheden

De Orca 2 LLM’s hebben een omvang van 7 miljard en 13 miljard parameters. Binnen deze modellen zijn de trainingssignalen en -methoden verbeterd zodat kleinere modellen toch de verbeterde redeneringsmogelijkheden krijgen die normaal in grotere modellen worden aangetroffen.

Bij de training van de modellen werd geen imitatie gebruikt, zoals bij het originele Orca-model, maar meer verschillende redeneringstechnieken. Bovendien leerden de ontwikkelaars van Microsoft het model om te bepalen wat de meest effectieve redeneringstechniek is voor iedere taak.

Benchmark grotere LLM’s

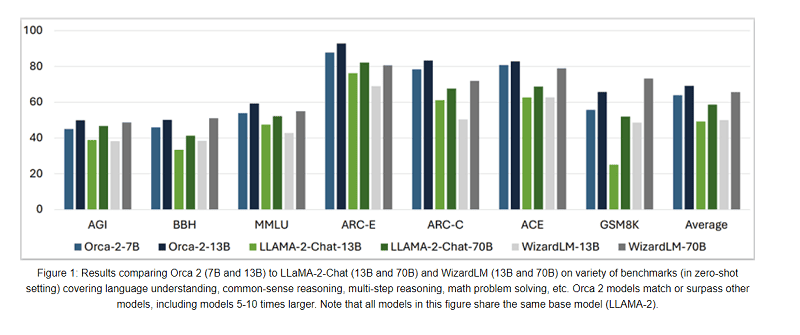

De Orca 2-modellen werden op 15 punten getest tegen een aantal grotere LLM’s. Deze laatste modellen waren soms vijf tot tien keer groter in omvang. Uit de tests bleek dat beide Orca 2 7B- en 13B-modellen het beter deden dan bijvoorbeeld het Llama-2-Chat-13B-model van Meta.

Ook deden ze het beter dan de WizardLM-13B en -70b-modellen van Hugging Face. In een bepaalde configuratie deed dit laatste model het nog wel beter dan de Llama-modellen van Meta en de Orca 2-modellen van Microsoft.

Overige aanbieders

Microsoft is niet alleen enige techgigant die de mogelijkheden van kleinere LLM’s verkent. Ook het Chinese 01AI heeft onlangs een ’klein’ LLM van 34 miljard parameters gepresenteerd dat beter presteert dan grotere modellen. Ook het Franse Mistral AI biedt een 7B LLM dat de concurrentie met grotere modellen aangaat.