Microsoft heeft vandaag de eerste versie van een eigen reeks superkleine Phi-3-modellen uitgebracht: Phi-3 Mini. Dit zogeheten ‘small language model’ (SLM) is klein genoeg om eenvoudig op een smartphone te draaien.

De introductie van Phi-3 Mini volgt enkele maanden na Phi-2, dat al relatief weinig parameters bevatte. Ondanks het kleine formaat presteerde dit model alsnog goed bij AI-benchmarks. Het nieuwe Phi-3 Mini beschikt over 3,8 miljard parameters en is getraind op een zeer compacte dataset. Meta’s open-source Llama-modellen, veel gebruikt door AI-ontwikkelaars, bestaan uit minimaal 7 miljard parameters.

Functionaliteit en prestaties

Phi-3 Mini is volgens Microsoft een stuk beter in programmeren en redeneren dan de eerdere SLM’s Phi-1 en Phi-2. Deze twee modellen blonken vooral uit in het schrijven van programmeercode (Phi-1) of het doorlopen van verschillende denkstappen (Phi-2). Phi-3 combineert deze vaardigheden, en voert ze ook nog eens beter uit dan de twee voorgangers.

Van Phi-3 Mini mogen geen wonderen verwacht worden. Zo kan het niet de prestaties van OpenAI’s toonaangevende GPT-4 evenaren. Wel zou de SLM van Microsoft prestaties leveren met outputs die gelijk zijn aan LLM’s die tot 10 keer groter zijn. Grotere modellen binnen een klein geheugenbudget proppen kan ook door een verkleiningsproces genaamd ‘quantization’, maar dit verlaagt de accuratesse aanzienlijk. Het alternatief is simpelweg een kleiner model en dat lijkt Microsoft geen windeieren te leggen.

Phi-3 Mini is getraind op basis van een ‘opleidingsplan.’ Dit plan is geïnspireerd op hoe kinderen leren van verhaaltjes voor het slapen gaan. Het betreft dus boeken met relatief eenvoudige woorden en zinsstructuren die over allerlei onderwerpen praten. Andere LLM’s werden geraadpleegd om met enkel een lijst van drieduizend woorden ‘kinderboeken’ te maken. Hier werd Phi-3 Mini vervolgens mee getraind, geeft Corporate Vice President Azure AI Platform van Microsoft aan in een commentaar aan The Verge.

Toepassingen voor Phi-3 Mini

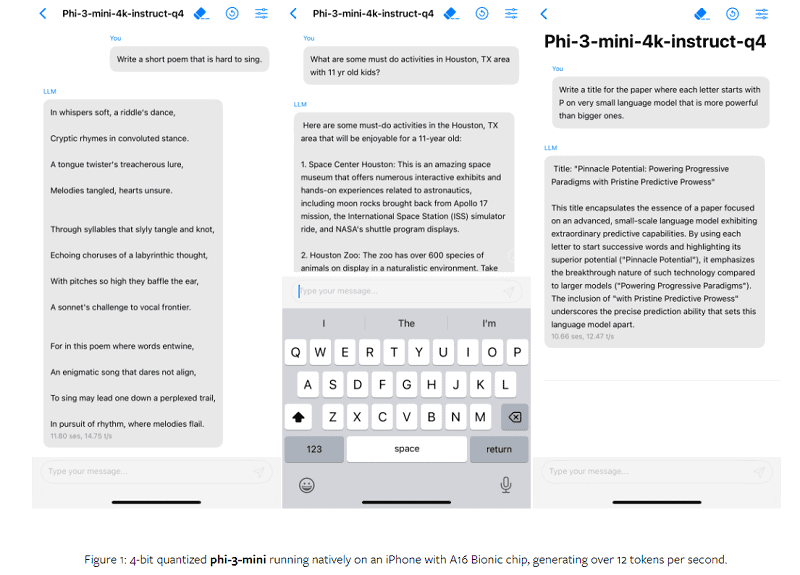

Het nieuwe AI-model van Microsoft is vooral geschikt voor gebruik in combinatie met de eigen applicaties van bedrijven. Daarnaast draait Phi-3 Mini gewoon op conventionele processors; er komt geen AI-pc aan te pas. Zelfs smartphones zouden het model kunnen draaien. Ook Apple werkt hieraan, bleek uit onderzoek dat het had gepubliceerd.

Meer Phi-3 LLM-versies in aantocht

Het blijft niet bij de introductie van Phi-3 Mini. Binnenkort wil Microsoft ook de varianten Phi-3 Small (7 miljard parameters) en Phi-3 Medium (14 miljard parameters) uitbrengen. Wanneer deze SLM’s verschijnen is niet bekend.

Phi-3 Mini is nu beschikbaar via Azure, maar ook op de AI-platforms van Hugging Face en Ollama.