Nieuwe oplossing is gericht op supercomputing, werkt out-of-the-box en moet organisaties en instellingen in staat stellen om snel met AI aan de slag te gaan.

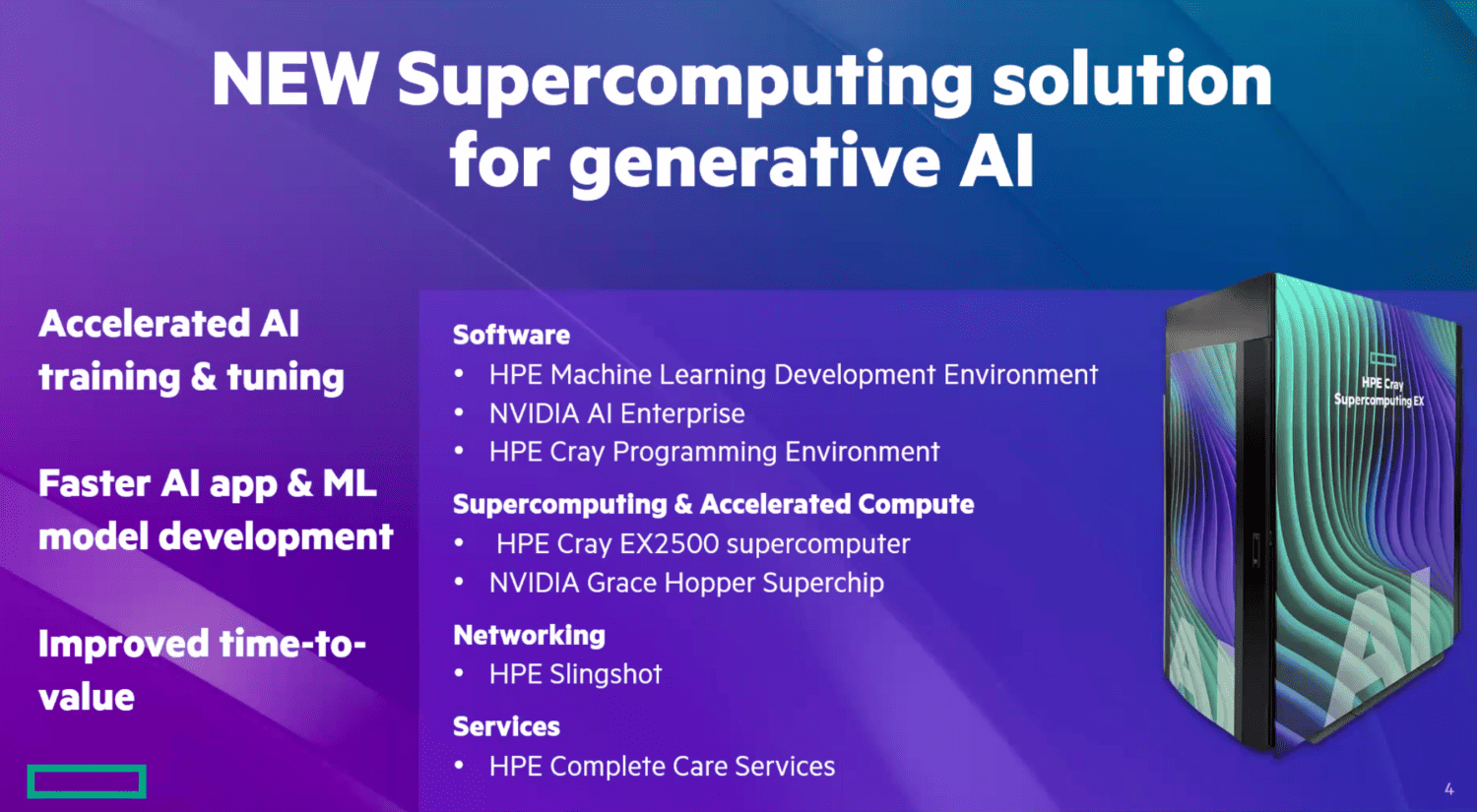

Hewlett Packard Enterprise kondigt vandaag een bijzonder nieuw systeem aan. Het heeft voor zover wij het hebben gezien geen eigennaam gekregen, maar wordt aangeduid als een supercomputing-oplossing. Specifiek gaat het om een oplossing om generatieve AI relatief snel in te kunnen zetten. Het is namelijk een complete oplossing. Dat wil zeggen, HPE levert de volledige stack. Het gaat hierbij om de opslag, netwerkverbindingen, de compute, maar ook om de software waarmee klanten aan de slag kunnen.

Lees ook: HPE betreedt AI-markt met HPE GreenLake for Large Language Models

De meegeleverde software is er overigens niet zomaar ‘bovenop’ gezet. Hij is geïntegreerd in het systeem. Het gaat hierbij vooral om HPE Machine Learning Development Environment, maar ook HPE Cray Programming Environment. Het eerste is bedoeld om klanten sneller AI-modellen te laten bouwen door integraties met populaire ML-frameworks. Het tweede stuk software maakt het mogelijk ontwikkelaars in staat te stellen om zelf code te ontwikkelen.

Cray EX2500 in combinatie met Nvidia Grace Hopper (GH200)

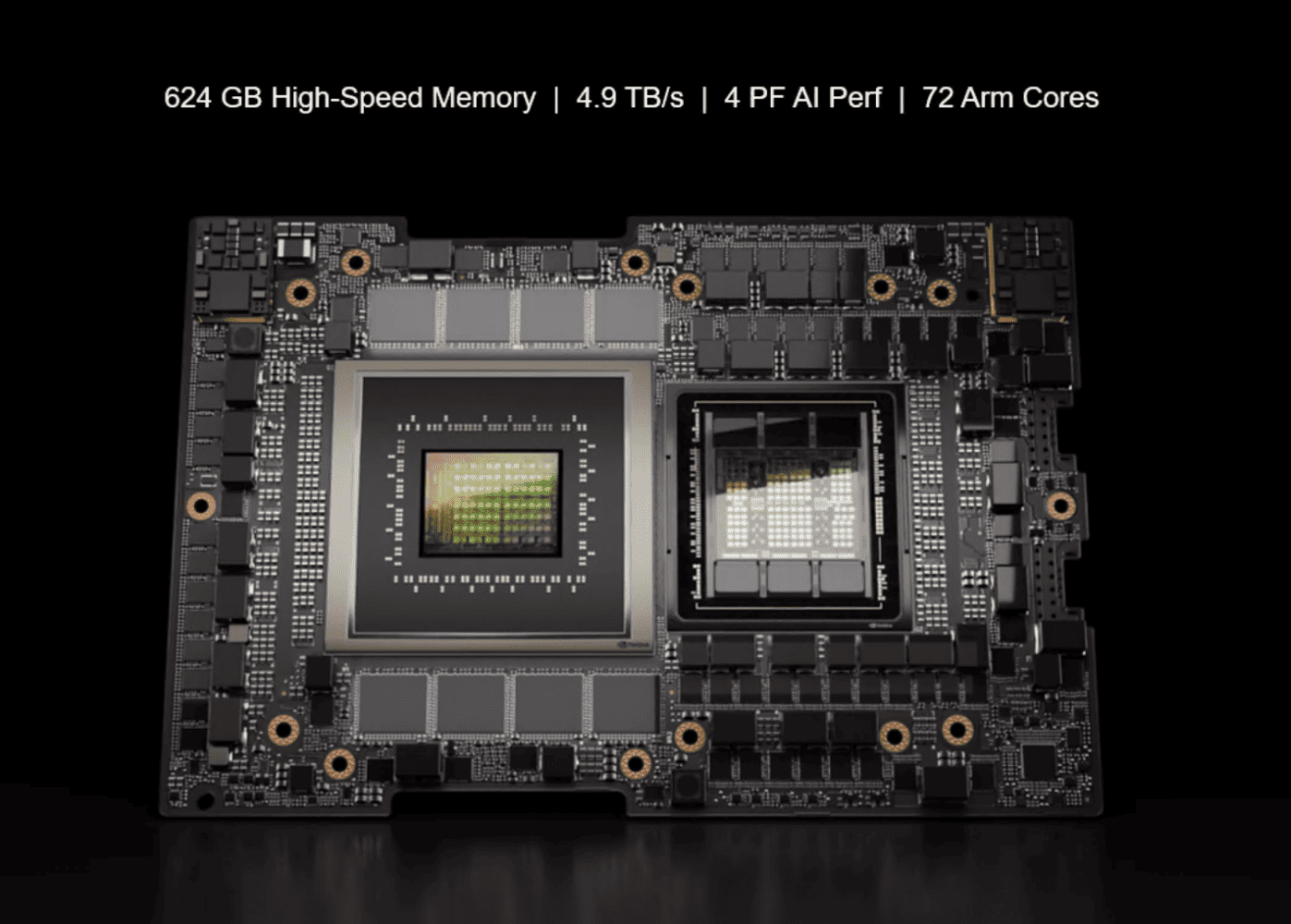

Als we het hierboven hebben over ‘het systeem’, dan hebben we het over een bijzondere configuratie. Het is namelijk een HPE Cray EX2500, met daaraan toegevoegd een Nvidia Grace Hopper Superchip (GH200), een combinatie van CPU en GPU. Daarmee is het de eerste oplossing op de markt waarin de Nvidia GH200 zit. Het geheel wordt afgemaakt door een ethernetgebaseerde interconnect, HPE Slingshot. Dit is ontwikkeld met zogeheten exascale workloads in het achterhoofd. Dat houdt in dat hij supersnel moet zijn en dus het systeem als geheel ook supersnel maakt. Anders gesteld zouden de netwerkprestaties de prestaties van het systeem als geheel niet tegen moeten houden. Dat is weleens anders geweest.

Lees ook: Nvidia’s GH200 Superchip in productie, Big Tech als eerste aan de beurt

De samenwerking tussen HPE en Nvidia is een serieuze stap voorwaarts. Niet eens zozeer op het gebied van de prestaties op het gebied van generatieve AI-modellen, maar vooral vanwege het feit dat het allemaal in een complete oplossing aangeboden wordt. Het maakt het trainen van AI-modellen toegankelijker. Het zal geen goedkope oplossing zijn, maar wel eentje die significant sneller belooft te zijn dan systemen waarin Nvidia alleen de H100 levert.

Een prijs heeft Nvidia vooralsnog niet officieel aan de GH200 Superchip gehangen. Ook HPE rept niet over een prijs voor de nieuwe oplossing in hun officiële communicatie. Wel weet het te melden dat de nieuwe oplossing vanaf december 2023 algemeen beschikbaar is in meer dan dertig landen. Welke dat specifiek zijn, is ook nog niet bekend. De doelgroep voor deze nieuwe oplossing lijkt vooral te bestaan uit onderzoeksinstellingen, overheidsinstellingen, maar volgens HPE ook grote enterprise-organisaties.

Luister hieronder naar een aflevering van Techzine Talks over Nvidia die we eerder dit jaar hebben gemaakt. Daarin bespreken we ook de komst van de GH200 Superchip.