Facebook-moederbedrijf Meta bouwt een supercomputer-omgeving voor de Metaverse. De supercomputer moet op termijn geavanceerde workloads op basis van natural language processing (NLP) en computer vision kunnen verwerken.

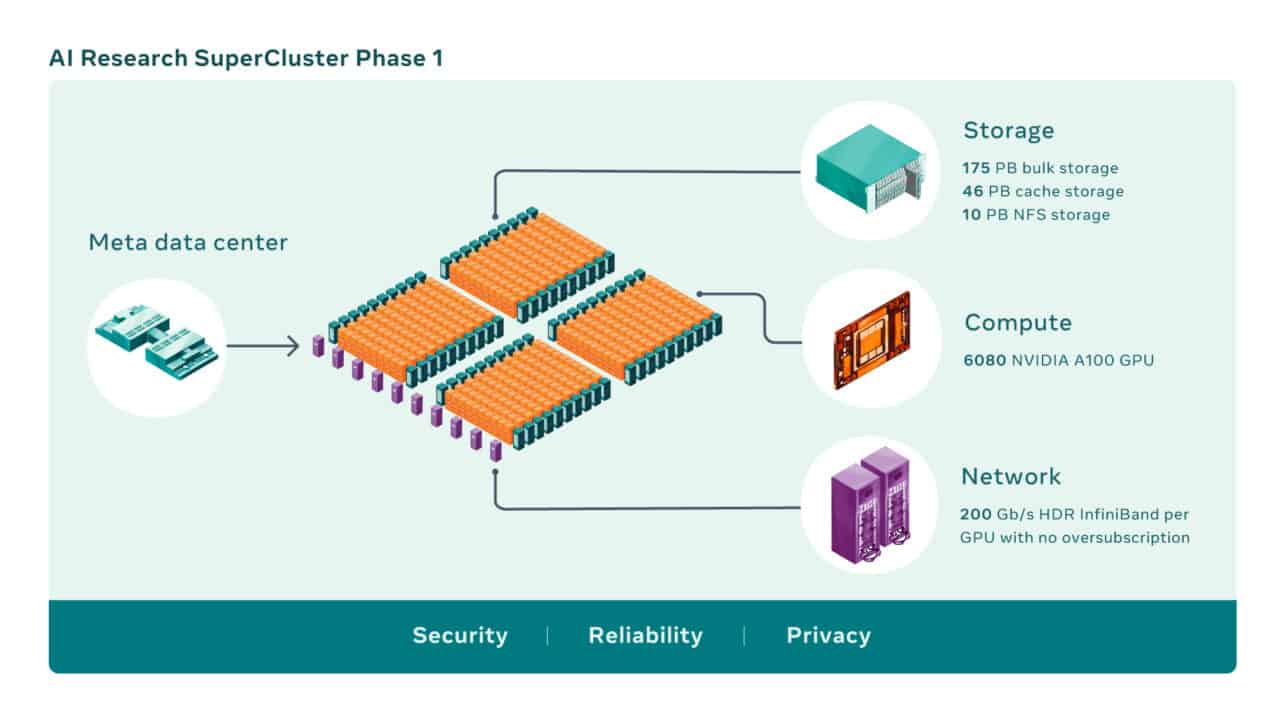

De supercomputer, ook wel AI Research SuperCluster (RSC), bestaat uit 6.080 Nvidia A100 GPU’s in 760 Nvidia DGX A100-systemen. De GPU’s zijn met elkaar in DGX-nodes gecombineerd en verbonden via een Nvidia Quantum 200 Gbps network fabric.

De RSC-supercomputer beschikt daarnaast over 175 PB aan storage op basis van Pure Storage FlasArray’s. De RSC kent 46 PB aan cache storage op basis van de Altus-systemen van Penguin Computing.

Gebruik voor AI-oplossingen

De RSC-supercomputer speelt voor Meta een grote rol in het ontwikkelen van nieuwe AI-systemen. Hierbij wordt vooral aandacht besteed aan het ontwikkelen van AI-oplossingen voor real time vertalen van stemmen voor grote groepen mensen die allemaal een andere taal spreken. Op deze manier zouden mensen wereldwijd kunnen samenwerken, zonder dat taal een probleem moet zijn.

Ook speelt de RSC, volgens de onderzoekers van Meta, een grote rol bij het ontwikkelen van computergebaseerde platformen van de volgende generatie. Hiermee doelen zij op de ontwikkeling van de Metaverse-omgeving die Meta wil bouwen. Vooral omdat op AI gebaseerde applicaties en producten in dit Metaverse een grote rol spelen.

Snellere training van AI-modellen

Hoewel de RSC-supercomputer nu nog in aanbouw is, wordt hij al gebruikt voor het trainen van AI-modellen. Voor het benutten van zogenoemde ‘self-supervised’ learning en zogenoemde ‘transformer-based’-modellen zijn volgens Meta veel complexere AI-modellen nodig. Hiervoor moet dan natuurlijk veel meer data worden verwerkt. De RSC van Meta moet dit allemaal kunnen afhandelen.

Uit de eerste testresultaten blijkt dat de RSC, in vergelijking met zijn legacy rekenkrachtmogelijkheden en -toepassingen, veel hogere prestaties haalt. Zo zouden computer vision workflows tot 20 keer sneller worden gedraaid, draait de Nvidia Collective Communication Library (NCCL) meer dan negen keer sneller en kunnen grote NLP-modellen met een factor 3 sneller worden getraind. Dit alles stelt bijvoorbeeld modellen op basis van tientallen miljarden aan parameters in drie weken geheel te trainen in plaats van de negen weken die eerder waren benodigd.

Komende tweede fase

Meta gaat dit jaar de capaciteit van de RSC gestaag uitbreiden. Halverwege dit jaar moet de supercomputer 16.000 GPU’s met elkaar hebben verbonden. Dit moet dan een totale rekenkracht van 5 exaflops opleveren. Het Infiniband-netwerk dat alle GPU’s en nodes met elkaar verbindt, moet uiteindelijk 16.000 poorten omvatten. De storagefunctionaliteit moet een snelheid van 16 Tbps krijgen en exascale-capaciteit voor het opvangen van de grote vraag naar storageruimte. Het uitgebreide aantal GPU’s moet de trainingsprestaties van AI-modellen ongeveer 2,5 keer versnellen.

Tip: Wat hebben de Web Summit, Metaverse en Facebook met elkaar gemeen?