Nvidia heeft een nieuwe serie A100 datacenter GPU’s aangekondigd. Meest opvallend aan deze serie is dat de koeling gebeurt met vloeistoffen. In de nabije toekomst moet dit standaard worden voor nog meer datacenter GPU’s van Nvidia.

De A100 datacenter GPU, veelal gebruikt voor AI en machine learning, wordt in de behuizing door vloeistoffen gekoeld. Dit moet de GPU dezelfde prestaties geven, maar tegen een lager energiegebruik. Luchtgekoelde A100 GPU’s leveren volgens de Nvidia al 20 keer meer energie-efficiency, maar de nieuwe met vloeistoffen gekoelde GPU’s rekken dit op tot 30 keer meer efficiency.

Een ander voordeel van met vloeistoffen koelen is dat er minder water verdampt tijdens het koelen. Luchtkoelsystemen halen de hitte uit servers weg door het verdampen van grote hoeveelheden water. Vloeistofkoelsystemen gebruiken minder water en kunne bijna alles recyclen. Dit helpt datacenterexploitanten minder water te gebruiken.

Minder ruimte kwijt

Daarnaast zijn deze exploitanten met op vloeistoffen gebaseerde koeltechniek ook minder ruimte kwijt in hun datacenters. De systemen nemen minder plaats in volgens Nvidia. Op deze manier kunnen er meer GPU’s in de serversystemen worden geplaatst. De nieuwe met vloeistoffen gekoelde A100 GPU heeft slechts 1 PCIe-slot nodig, een luchtgekoelde heeft twee slots nodig.

Nvidia verwacht dat de eerste systemen met de nieuwe koeltechniek voor zijn A100 GPU’s deze zomer beschikbaar komen. De technologie wordt ook uitgebreid naar de recente flagship datacenter GPU H100 en naar andere GPU-modellen.

Nvidia is overigens niet de eerste fabrikant die meer inzet op koeling van processors en GPU’s met vloeistoffen. Onlangs kondigde Intel al een vergelijkbaar plan aan.

Eerste Grace Superchip-systemen

Naast de komst van vloeibare koeling voor zijn hoogwaardige GPU’s, heeft Nvidia een aantal andere hardware-updates aangekondigd. Verschillende -vooral Taiwanese- fabrikanten gaan servers op de markt brengen die op de Grace CPU SuperChip en Grace Hopper SuperChip van Nvidia zijn gebaseerd.

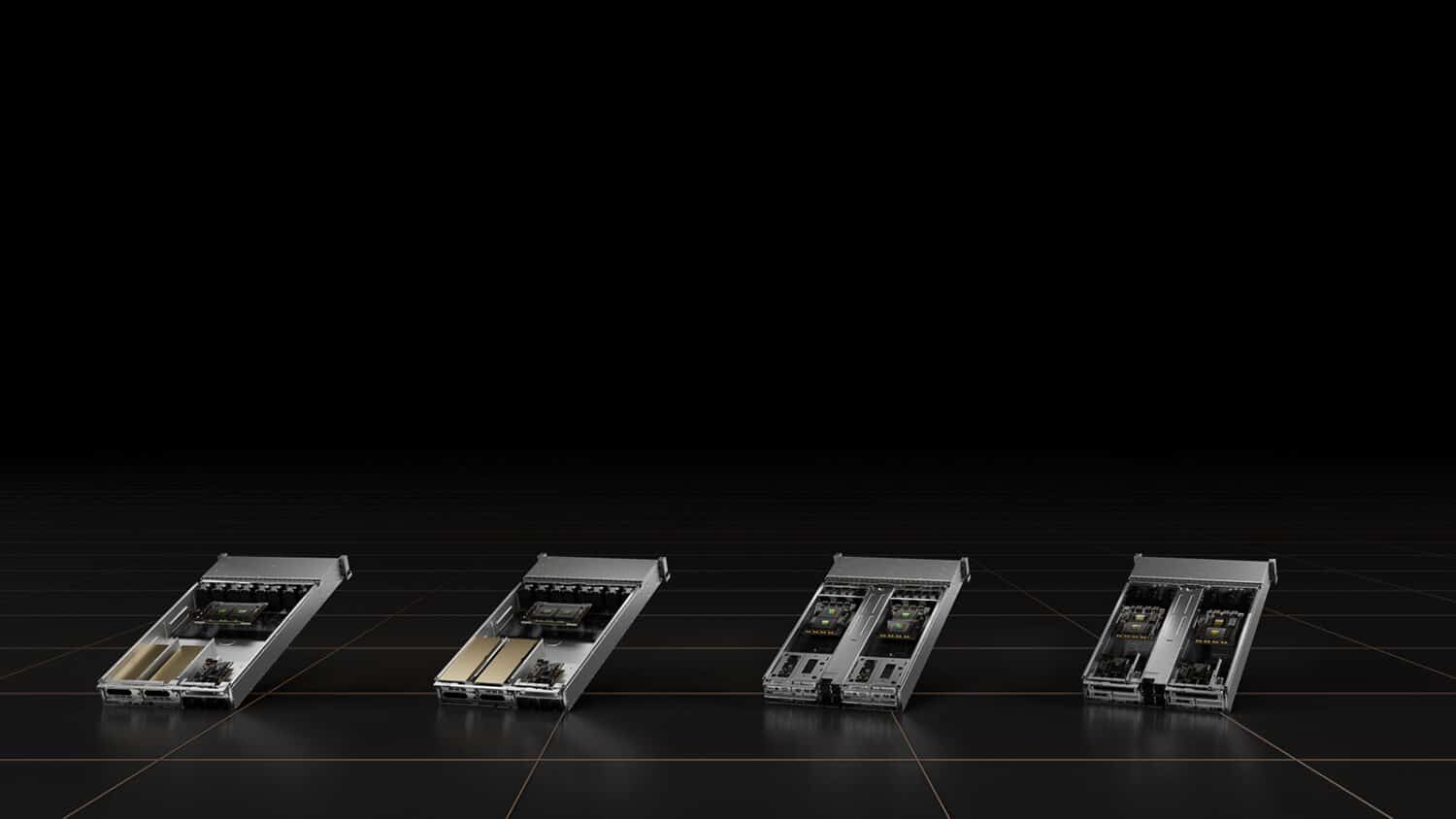

Deze servers zijn gebaseerd op een viertal reference-ontwerpen. Twee van de ontwerpen gebruiken de Grace SuperChip, een CPU en een high speed interconnect. De twee andere zijn gebaseerd op de Grace Hopper SuperChip, een Grace CPU die is gecombineerd met een GPU. De ontwerpen zijn vooral geschikt voor AI-toepassingen en HPC-workloads.

Overige aankondigingen

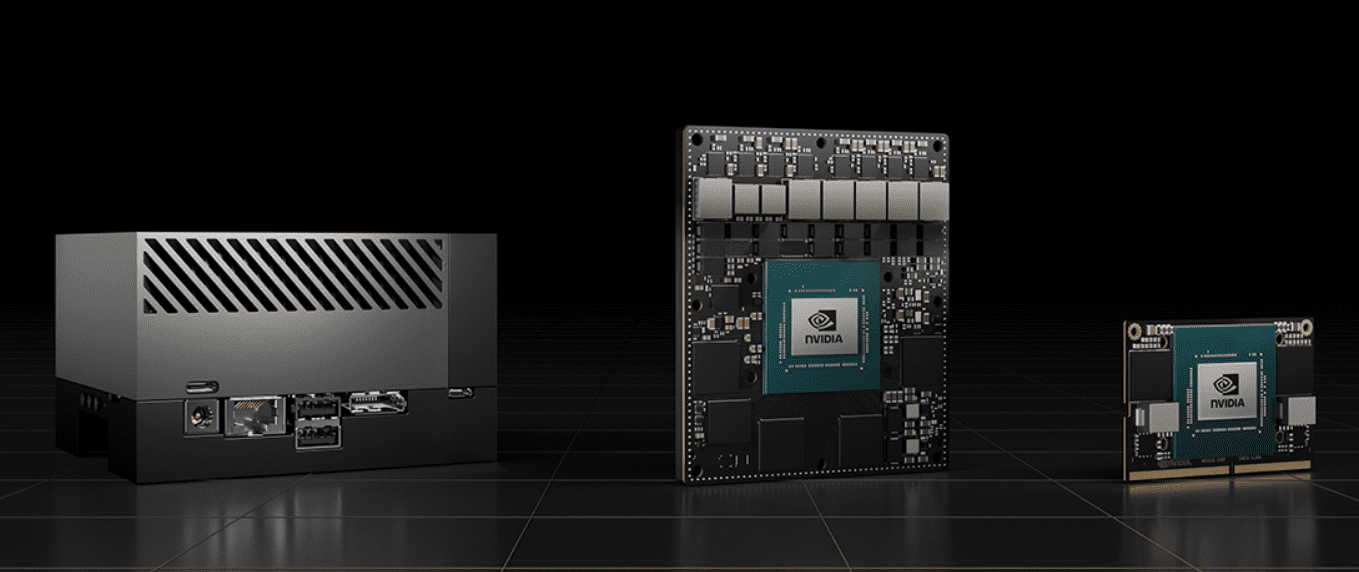

Verder is er meer duidelijkheid over het ecosysteem van de Nvidia Jetson AGX Orin-oplossingen. Dit zijn compacte rekenkrachtmodules voor het draaien van AI-modellen in edge-omgevingen. Hierbij worden vele Arm-gebaseerde processors gecombineerd met een GPU en andere onderdelen voor het verwerken van processen.

Inmiddels zijn er ongeveer 30 hardware-fabrikanten die op basis van deze technologie systemen gaan leveren. Denk daarbij aan servers, edge-appliances, industriële pc’s en circuit borads voor het ontwerpen van nieuwe hardware-producten. Wanneer deze hardware op de markt komt, is niet bekend.

Tip: Nvidia kondigt serverprocessor Grace aan, blinkt uit in AI-workloads