Nvidia heeft de gratis Chat with RTX-tool geïntroduceerd, waarmee pc-gebruikers een gepersonaliseerde chatbot kunnen bouwen. Dit op basis van Windows en een geïntegreerde Nvidia GeForce RTX 30 Series GPU of recentere Nvidia-GPU’s.

Met Chat with RTX kunnen gebruikers op hun eigen pc, dus niet in een cloudomgeving, een chatbot bouwen. Deze chatbot gebruikt de op de pc aanwezige content en stelt gebruikers op die manier in staat persoonlijke AI-functionaliteit te gebruiken.

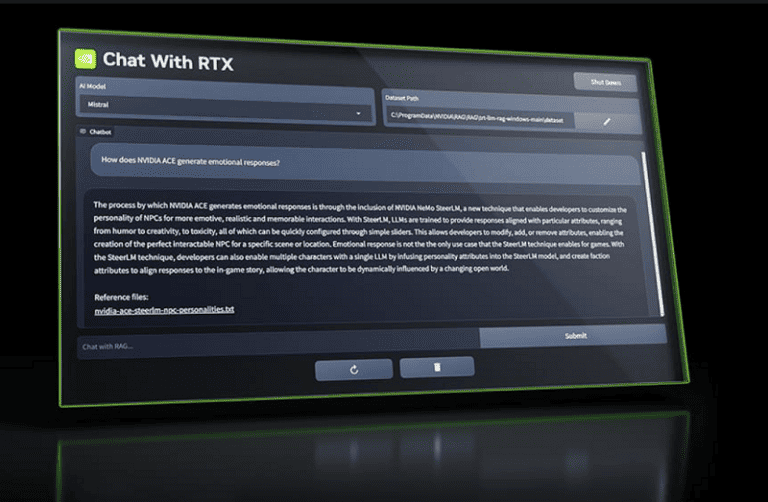

De tool zorgt ervoor dat lokale bestanden als een dataset worden verbonden met open-source LLM’s, zoals Mistral of Llama-2. Vervolgens is het mogelijk om met prompts snelle en contextueel relevante antwoorden te krijgen.

Ondersteunde bestandsformaten zijn onder meer .txt, .pdf, .doc/.docx en .xml. Ook kunnen gebruikers URL’s van YouTube-video’s en playlists uploaden. Via een YouTube URL kunnen gebruikers de inhoud daarvan toevoegen aan de chatbot en gebruiken voor contextuele zoekvragen.

Voordelen lokale AI-chatbot

Het maken en gebruiken van een gepersonaliseerde AI-chatbot biedt volgens Nvidia voordelen, zoals dat gebruikers zelf kunnen bepalen tot welke content de tool generatieve AI-assistent heeft voor zijn antwoorden.

Daarnaast leert de generatieve chatbot alleen de privé-dialoog met de gebruiker en worden dus niet de dialogen gebruikt voor optimalisatie, zoals gebeurt bij cloudgebaseerde AI-chatbots. Dit geeft meer privacy. Ook worden met een gepersonaliseerde en lokale AI-chatbot de antwoorden sneller gegenereerd, omdat latency ontbreekt.

Op technologisch vlak gebruikt de Chat with RTX-tool van Nvidia onder meer retrieval-augmented generation (RAG)-technologie, de Nvidia TensorRT-LLM-software en Nvidia RTX-acceleratie voor het leveren van de generatieve AI-functionaliteit.

Een belangrijke voorwaarde voor de tool is wel dat deze alleen op Windows 11-gebaseerde desktops of laptops draait. Daarnaast moeten deze desktops of laptops minimaal een Nvidia GeForce RTX 30 Series GPU of recentere GPU’s, zoals de Nvidia RTX Ampere of Ada Generation GPU’s aan boord hebben.

Verder is minimaal 8 GB aan VRAM en 16 GB aan RAM en driver-versie 535.11 of later nodig.

Eigen applicaties ontwikkelen

Verder kunnen gebruikers van Chat with RTX de tool gebruiken voor het ontwikkelen van eigen AI-applicaties. Dit met behulp van het op GitHub beschikbare TensorRT-LLM RAG developer reference project. Met dit referentieproject kunnen ontwikkelaars hun eigen op RAG-gebaseerde applicaties voor RTX ontwikkelen en uitrollen. Deze worden daarbij ondersteund door het TensorRT-LLM van NVIDIA.

Chat with RTX is nu gratis te downloaden.

Lees ook: Nvidia-CEO: Ieder land moet eigen AI-infrastructuur bouwen