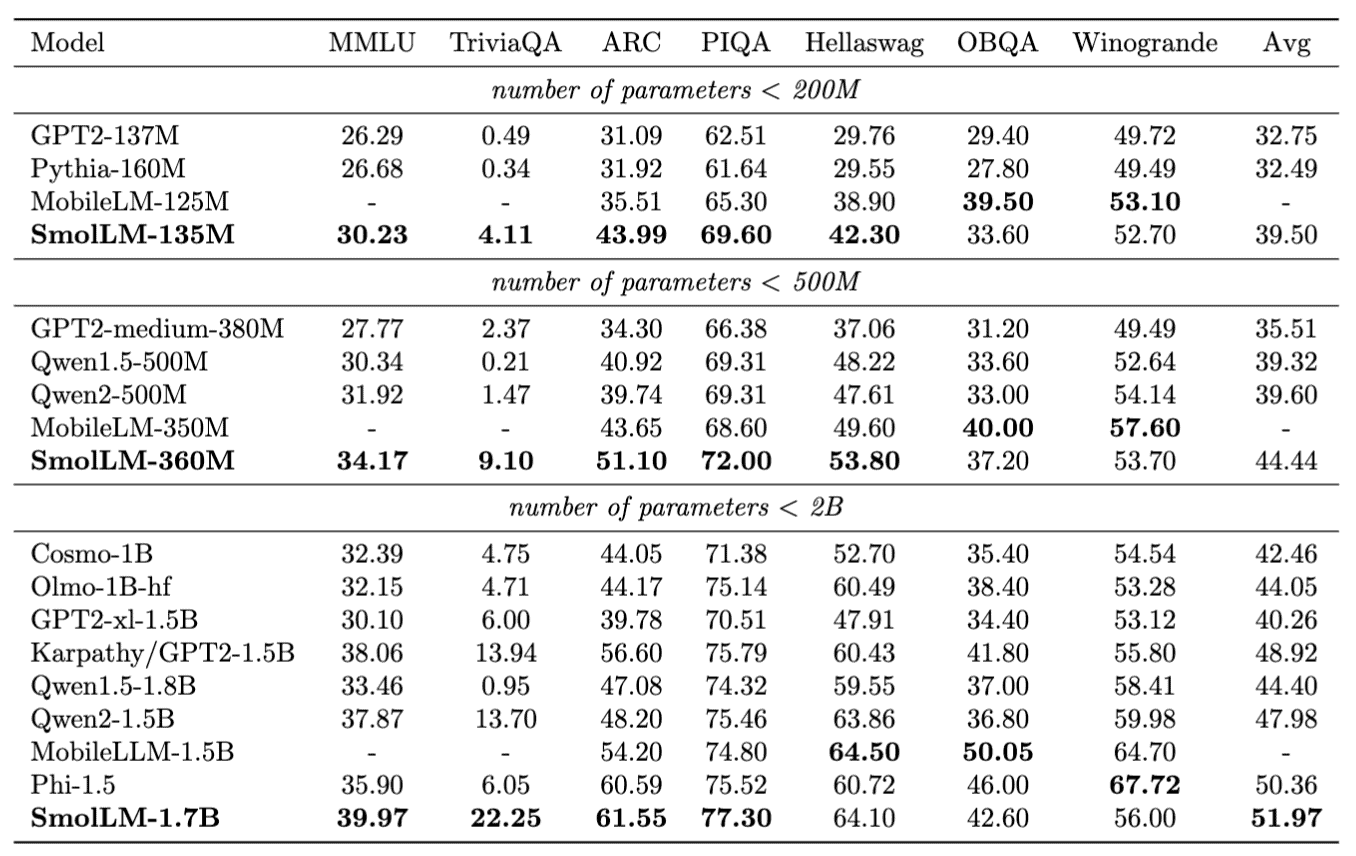

Hugging Face onthult SmolLM, een language model dat compact is van formaat. Dat maakt het geschikt voor lokaal gebruik op persoonlijke toestellen. Dergelijke modellen bestaan al van Microsoft en Meta, maar SmolLM overtreft deze in testen.

SmolLM is een nieuwe familie language models (LM’s) van Hugging Face. Het gaat om een pakket van drie modellen, aangestuurd door 135 miljoen, 360 miljoen en 1,7 miljard parameters. In een high-end LLM loopt dat aantal op tot in de biljoenen. De ontwikkelaars geven zelf geen exacte cijfers over dit kenmerk, maar naar schatting bevat GPT-4 Turbo 1,76 biljoen parameters, Claude 3 Opus 2 biljoen parameters en Gemini 1.5 Pro minstens 1,6 biljoen parameters.

Het aantal parameters in AI-modellen neemt razendsnel toe. Dat maakt het bijna onmogelijk om een vaste standaard te zetten over de hoeveelheid parameters er in een model dienen te zitten om als ‘Large’ door te gaan. De nieuwe modellenfamilie Hugging Face wordt in ieder geval gezien als een compacte familie. Het grootste model, bestaande uit 1,7 miljard parameters, komt in de buurt van het aantal beschikbare parameters uit GPT-2 uit 2019 (1,5 miljard parameters).

Trainingsdata van hoge kwaliteit

SmolLM kan de parameters veel gerichter inzetten dan het OpenAI-model uit 2019. De prestaties overtreffen ook deze van recent uitgebrachte modellen, zoals MobileLLM dat Meta eerder deze maand vrijgaf. MobileLLM bracht verbeteringen van 2,7 tot 4,3 procent aan volgens benchmark-testen die het LLM vergelijken met voorgaande modellen van dezelfde omvang. SmolLM bevat alleen wel steeds minstens 10.000 parameters meer dan deze waar het zichzelf mee vergelijkt van Meta.

Tekst gaat verder onder de afbeelding

Bron: Hugging Face

Volgens de onderzoekers zijn de betere resultaten in de testen het resultaat van de goede datakwaliteit van de trainingsdata. Voor de training werden Cosmo-Corpus, Python-Edu en FineWeb-Edu met elkaar gecombineerd. Deze modellen hebben allemaal een educatieve insteek en werden grondig gefilterd om van drie LLM’s tot één LM-familie te komen.

Nieuwe stap naar cloud-onafhankelijkheid

De nieuwe modellenfamilie van Hugging Face brengt opnieuw verbeteringen aan AI-modellen die lokaal kunnen draaien. Deze modellen zouden volledig cloud-onafhankelijk werken en zo privacy-zorgen moeten wegnemen. Zeker in zakelijke omgevingen waar het cruciaal is dat interne data niet naar de buitenwereld lekt, kunnen dergelijke modellen het AI-gebruik een flinke boost bezorgen.

Hugging Face hoopt aan dit veld bij te dragen met de lancering van SmolLM. Voor ontwikkelaars is de lancering belangrijk doordat het bedrijf open-source handelt en ook de datasets en training code vrijgeeft. Dat vereenvoudigt de doorontwikkeling ten opzichte van eerder beschikbare modellen waar “de meeste details over de datacuratie en training van deze modellen niet openbaar beschikbaar zijn”.