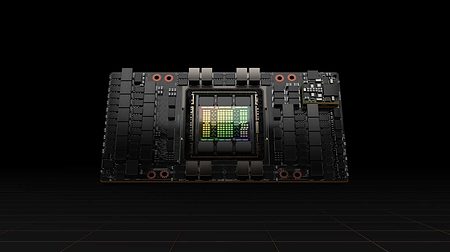

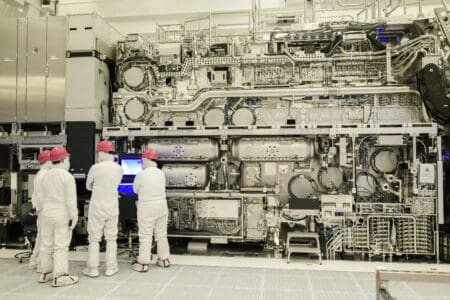

Nvidia heeft de DGX Station A100 aangekondigd. Het is een compacte server die uitgerust is met vier A100-gpu’s en maximaal 320GB aan HBM2e-geheugen. De machine is bedoeld als lokaal apparaat om machine learning-taken te laten uitvoeren.

De server heeft een compact formaat. Met een hoogte van 639mm, breedte van 256mm en een diepte van 518mm is hij niet veel groter dan een flinke computerkast. Nvidia claimt dat hij in elke hoek van een kantoor of onderzoekslab weggestopt kan worden. Hij hoeft niet in een speciaal gekoelde serverruimte te staan, maar kan wel als een server worden ingezet, inclusief toegang voor thuiswerkers.

Meer videogeheugen

Klanten kunnen kiezen tussen twee varianten van de Nvidia A100-gpu. Naast de bestaande variant van de A100, die met 40GB aan videogeheugen is uitgerust, heeft Nvidia nu ook een 80GB-variant beschikbaar gesteld. Door vier van de kaarten in één machine te combineren, hebben gebruikers maximaal 320GB tot hun beschikking.

Specificaties

De DGX Station A100 draait op een AMD Epyc 7742-processor, met 64 Zen 2-cores. Het systeem heeft 512GB aan ddr4-geheugen, een 1,92TB NVMe-ssd als systeemschijf en een extra U.2-ssd met 7,68TB aan opslagcapaciteit. Verder zijn er twee 10Gbit/s-aansluitingen beschikbaar om met een netwerk te verbinden. In totaal kan het systeem 1500 watt aan stroom verbruiken.

Powerhouse voor AI en ML

Nvidia zet zijn A100-gpu duidelijk in de markt als een powerhouse voor kunstmatige intelligentie en machine learning. In oktober blies het bedrijf hoog van de toren met de prestaties die de kaart behaalde in MLPerf-benchmarks. Het bedrijf claimde toen dat een enkele DGX A100-server met acht A100-gpu’s bijna even snel zou zijn als duizend servers die op Intel-processors gebaseerd zijn.