Microsoft AI-chattool Copilot, voorheen Bing Chat, maakt feitelijke fouten en geeft misleidende antwoorden over resultaten van recente verkiezingen in Europa.

Dat concludeert een onderzoek van AlgorithmWatch. De mensenrechtenorganisatie onderzocht tussen eind augustus en begin oktober van dit jaar de antwoorden van Bing Chat op vragen over verkiezingen in Zwitserland en de Duitse deelstaten Hessen en Beieren. Deze verkiezingen, die plaatsvonden in oktober, werden gekozen omdat dit de eerste waren na de introductie van de AI-tool Bing Chat.

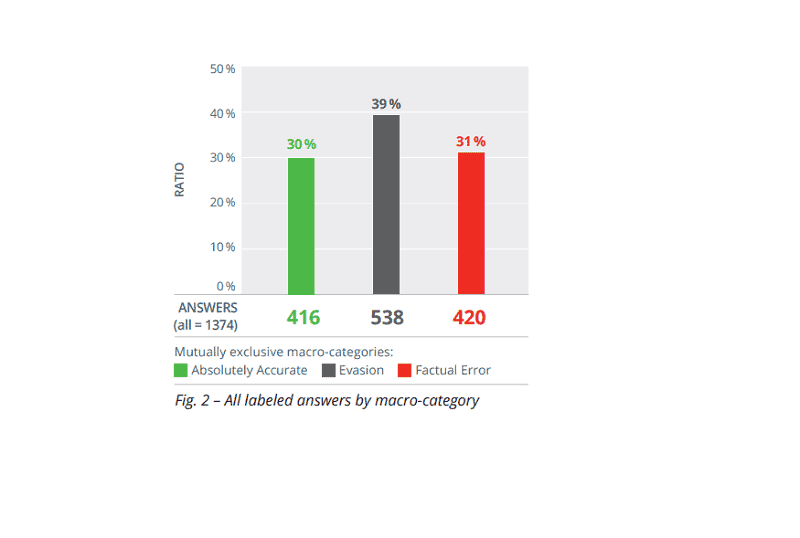

Uit de resultaten blijkt dat maar liefst een derde van de door onderzoekers gestelde vragen over de afzonderlijke verkiezingen feitelijke fouten bevatte. Hierbij gaat het onder andere om verkeerde verkiezingsdatums, verouderde kandidatenlijsten of zelfs zelfbedachte schandalen rondom kandidaten.

Veiligheidsrichtlijnen niet consequent

Daarnaast werd duidelijk dat de veiligheidsrichtlijnen van de AI-chatbot onevenwichtig werden toegepast, resulterend in 40 procent aan ontweken antwoorden gedurende het onderzoek. Hoewel de AI-chatbot van Microsoft vaak antwoorden vermeed, wat positief kan zijn als het te wijten is aan beperkte mogelijkheden van het onderliggende LLM (in dit geval GPT-4 van OpenAI), werd dit niet consequent toegepast. De chatbot kon vaak eenvoudige vragen over de kandidaten in de betreffende verkiezingen niet beantwoorden.

Deze inconsistentie bleef gedurende de hele onderzoeksperiode bestaan, terwijl verbeteringen verwacht werden, bijvoorbeeld door meer informatie online beschikbaar te stellen. Het risico op incorrecte feitelijke antwoorden bleef daardoor bestaan, wat schade kan toebrengen aan de kandidaten zelf of aan de reputatie van media.

Systematisch probleem

AlgorithmWatch beschouwt deze aanhoudende incorrecte antwoorden als een belangrijk systematisch probleem. Ondanks melding aan Microsoft constateerden de onderzoekers een maand later weinig tot geen actie. Ze beschuldigen Microsoft ervan het probleem niet op te lossen of niet in staat te zijn dat te doen.

De mensenrechtenorganisatie roept op tot regulering van dergelijke (generatieve) AI-tools door de EU en nationale overheden, vooral als ze op grote schaal worden gebruikt.

Reactie Microsoft

Tegenover The Verge stelt Microsoft stappen te hebben ondernomen om zijn AI-chatbotplatforms te verbeteren, vooral met het oog op de komende presidentsverkiezingen in de VS. Er wordt nu meer nadruk gelegd op het gebruik van betrouwbare bronnen voor Bing Chat of Copilot. Microsoft benadrukt echter dat gebruikers altijd zelf een goed oordeel moeten vellen over de resultaten die de AI-chatbots geven op gestelde vragen.