Bij Databricks zijn ze ervan overtuigd dat ze met het lakehouse een nieuwe industrietrend in gang gaan zetten. Nadat data warehouses de business intelligence-wereld vooruit hielp en data lakes data science-toepassingen versimpelden, moet de volgende stap gezet worden met een data-pool die geschikt is voor allerlei toepassingen. Gaan we een nieuw tijdperk tegemoet of gaat het om een marketing buzzword?

Databricks is groot geworden met he bedenken van nieuwe frameworks en paradigma’s die het werken met data vereenvoudigen. Een goed voorbeeld hiervan is Apache Spark, de analytics engine die het traditionele extract, transform, load (ETL)-proces vereenvoudigt en versnelt. Om de ontwikkeling en adoptie van Spark te versnellen is er voor een open source-karakter gekozen en is de software aan The Apache Software Foundation geschonken.

Het lakehouse-idee moet een zelfde weg bewandelen. Tijdens zijn virtuele Spark + AI Summit gaf Databricks dan ook een toelichting op lakehouses en werden verdere plannen met het project wereldkundig gemaakt.

Lakehouse als fundament voor alle datatoepassingen

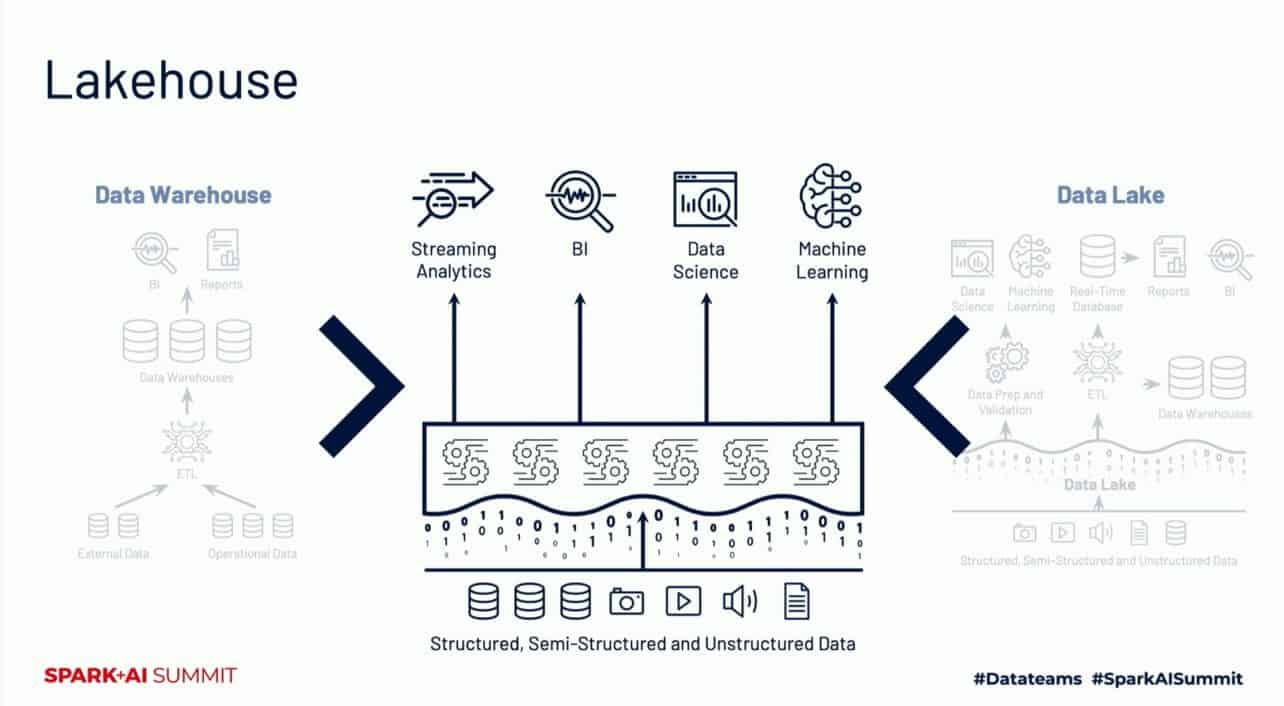

Als je als bedrijf meerdere systemen, databases en applicaties gebruikt, dan creëren ze allemaal verschillende soorten data. Gegevens die vaak op allerlei manieren staan weggeschreven. Wil je daar analytics op toepassen, dan zal één grote plek alle data samen moeten brengen. Het is belangrijk dat die plek de gegevens laat samenwerken en er een logische structuur in brengt. Traditioneel wordt hier vaak data warehouse-technologie voor gebruikt, terwijl data lakes ook populair zijn. Ze hebben ieder hun eigen voor- en nadelen.

Een data warehouse verzamelt bijvoorbeeld sales-informatie van de 40 landen waarin een enterprise organisatie actief is. Het gaat dan om historische informatie, maar ook over de huidige verkoopcijfers. Vervolgens wordt deze informatie klaargemaakt voor analytics, vaak business intelligence (BI), om het begrijpelijk te maken. Op die manier kunnen er op detailniveau trends gespot worden en is op basis van data ongeveer te voorspellen wat er gaat gebeuren. Een data warehouse staat daarmee aan de basis van inspelen op mogelijke kansen en bedreigingen voor de business, maar bijvoorbeeld ook aan het doorvoeren van kostenoptimalisaties.

Data warehouses bieden echter weinig ondersteuning voor video-, audio- en tekstdata. Dergelijke data wordt wel steeds meer gegenereerd en gebruikt voor analytics-doeleinden als machine learning en data science. Om deze vorm van analytics goed uit te voeren, worden vaak data lakes gebruikt. Een erg schaalbare technologie die overweg kan met gestructureerde data, ongestructureerd data en semigestructureerd data. Denk hierbij aan informatie uit databases, e-mails en videostreams. Volgens Databricks zijn data lakes uiteindelijk zeer geschikt voor data science en machine learning, maar bestaan ze nog heel vaak naast data warehouses. Data lakes bieden immers weinig BI-ondersteuning en ze zijn ook een stuk complexer dan data warehouses.

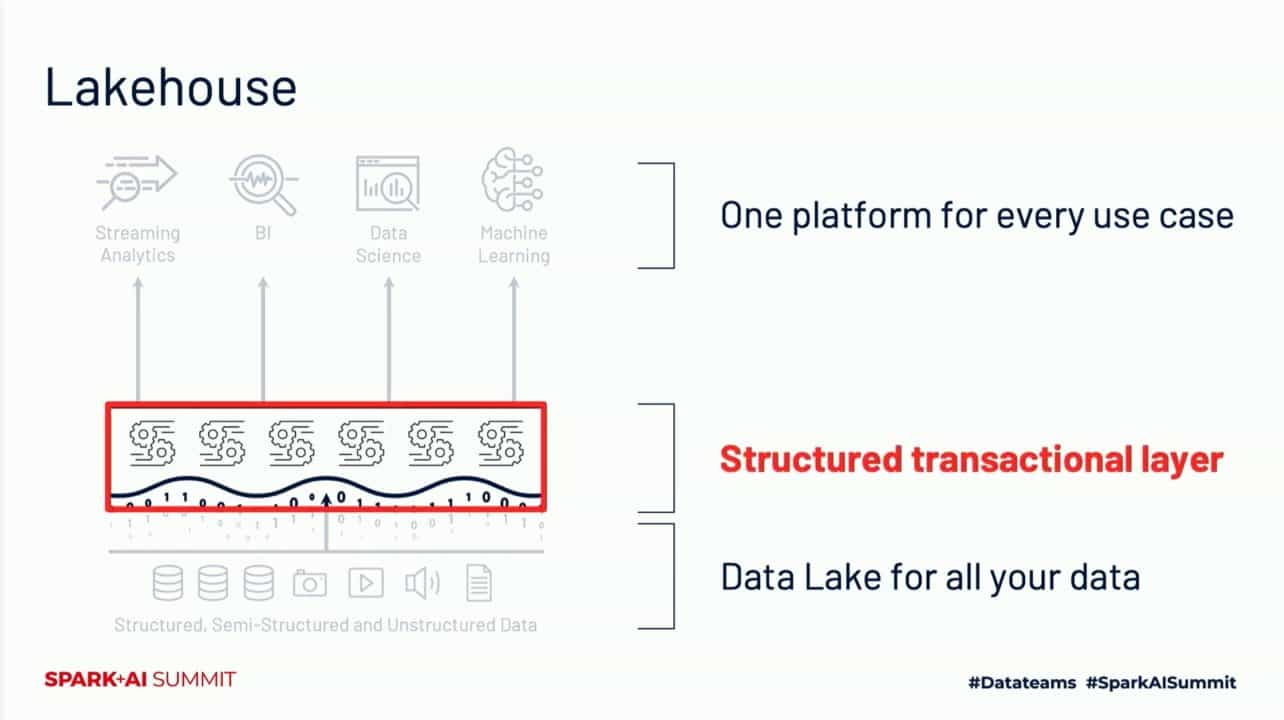

Daarom kiest Databricks met zijn lakehouse-visie voor het verenigen van beide technologieën. Dit lakehouse belooft de structuur-, BI- en reporting-voordelen van data warehouses in combinatie met de data science-, machine learning- en kunstmatige intelligentie (AI)-voordelen van data lakes.

Hoe ziet een lakehouse eruit?

Het lakehouse lijkt aan de onderkant veel op een data lake, doordat het met ongeveer dezelfde types data om kan gaan. Vervolgens brengt een ‘gestructureerde transactionele laag’ kwaliteit, structuur, governance en performance naar de gegevens. Hiervoor heeft Databricks zijn Delta Lake-project bedacht, dat ontworpen is met een aantal problemen rond traditionele technologie in het achterhoofd. Obstakels die Databricks ziet zijn bijvoorbeeld onjuiste lees-taken binnen het data lake, moeite met het uitvoeren van real time operaties en complexiteit bij het aanpassen van gegevens.

Een van de trucjes die Delta Lake zodoende toepast is het opslaan van gebeurtenissen in een log. Hierdoor houdt een laag toezicht op de acties binnen het data lake. Handelingen worden alleen goedgekeurd als ze volledig uitgevoerd zijn, anders wordt de actie gewist en moet het eventueel op een later moment gebeuren. Gebruikers krijgen zo meer zekerheid over de kwaliteit van data: de informatie is compleet en up-to-date, wijzigingen en aanpassingen worden volledig doorgevoerd.

Verdere kwaliteit moet ingebouwd worden door middel van schema-validatie. Deze schema’s, vaak een snowflake- of star schema, worden gebruikt om data op een efficiënte manier te ordenen. Een controle door Delta Lake moet ervoor zorgen dat data zich 100 procent houdt aan het toegepaste schema. Eventuele inconsistenties worden apart opgeslagen zodat gebruikers beslissen wat er met de data moet gebeuren.

Daarnaast wil Databricks met indexing-technologie de performance en de structuur van data lakes verbeteren. Volgens het bedrijf is een traditionele data lake vaak een combinatie van miljoenen kleine files met enkele zeer grote files. Door automatische de layout te optimaliseren, bijvoorbeeld met een layout waar veelgebruikte queries mee overweg kunnen, krijgen gebruikers snel toegang tot de gegevens.

Tot slot wordt Spark actief ingezet om het opzetten van data pipelines te versimpelen en de efficiëntie te verbeteren. Spark is gebouwd om grote hoeveelheden data te verwerken. De samenwerking van Delta Lake met Spark moet de omgang met grote hoeveelheden metadata in het data lake eenvoudiger maken. Volgens Databricks lopen bedrijven bij het traditionele data lake regelmatig tegen problemen aan wanneer ze grote hoeveelheden metadata willen gebruiken.

Vertrouwen in project moet adoptie ten goede komen

Databricks is ervan overtuigd dat het beste van het data warehouse en het data lake samen moeten komen, willen bedrijven meer eenvoud, voordelen en toepassingen realiseren. Daar moeten zoveel mogelijk bedrijven van kunnen profiteren. Zodoende is Delta Lake inmiddels ondergebracht bij de Linux Foundation, mede om de ontwikkeling te versnellen.

Ook is visualisatiedienst Redash overgenomen door Databricks. De technologie van deze startup helpt gebruikers uitgevoerde queries te begrijpen. Dit door met een visualisatie van de query-resultaten te komen. Op een dashboard worden onder meer grafieken getoond, zodat de query een stuk begrijpelijker wordt. Zo begrijpt niet alleen de data scientist wat de data vertelt, maar snapt bijvoorbeeld ook C-level de informatie. De gehele organisatie kan op die manier beslissingen nemen op basis van data.

Uiteindelijk maakt Databricks dus verschillende investeringen om van zijn lakehouse-visie een succes te maken. Het doel om de AI- en data-wereld verder te brengen is ook duidelijk, al is er wel wat voor nodig om een massa-adoptie te realiseren. Bedrijven vertrouwen vaak op hele goede producten voor onder meer data warehousing, waardoor het de vraag is of ze ook willen investeren in een lakehouse. Wat dat betreft heeft de lakehouse-visie tijd nodig om aan te tonen of het zijn potentie waarmaakt.

Tip: Databricks vindt open source de broodnodige innovatie voor data science