Neurale netwerken (NN’s) ondersteunen allerlei functies, van Tesla’s Autopilot-besturing tot medische diagnoses en gepersonaliseerde advertenties. Net als de menselijke hersenen waar ze op gebaseerd zijn, is de precieze werking van een NN niet altijd te doorgronden. Onderzoek van Anthropic zou hierin verandering moeten brengen.

NN’s kunnen zich richten op zowel tekst als beeld, maar passen in alle gevallen een netwerk van neuronen toe die individueel eenvoudige berekeningen maken en met elkaar kunnen communiceren. Anthropic legt uit dat de wiskunde van neuronen volledig bekend is, maar dat niet duidelijk is waarom een neuraal netwerk bepaald gedrag vertoont dankzij die berekeningen.

Dit zorgt voor een probleem dat maar al te bekend is bij generatieve AI-applicaties, die anders in elkaar zitten maar eveneens voor veelal onvoorspelbare outputs zorgt. Een uitkomst van een NN moet zo veilig mogelijk zijn en idealiter volledig te doorgronden, stelt Anthropic. Immers kunnen ze uiterst nuttig zijn om bijvoorbeeld op grote schaal medische problemen op te sporen, om logistieke routes te genereren en om voertuigen aan te sturen.

Tip: Liquid neural networks: hoe een worm de problemen van AI oplost

Bestanddelen

NN’s worden getraind op data en kunnen middels het maken van connecties tussen neuronen conclusies trekken over de gegeven informatie. Daarbij kunnen dezelfde neuronen in totaal verschillende gevallen geactiveerd worden. Anthropic haalt aan dat een enkele neuron binnen een vision model zowel op het hoofd van een kat als de voorkant van een auto kan reageren.

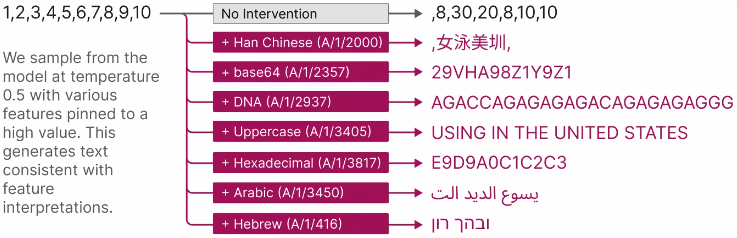

Anthropic onderzocht een transformer language model dat bestaat uit 512 neuronen. Een dergelijk model kan context vatten uit een dataset om deze informatie vervolgens op nieuwe data toe te kunnen passen. Voorbeelden van praktische toepassingen hiervan zijn te vinden bij real-time vertalingen van tekst en spraak of fraudedetectie. Men reduceerde de 512 neurons tot 4096 features die elk een zeer specifieke functie hebben. Daarmee konden de onderzoekers binnen een individuele neuron zien waarom deze geactiveerd werd.

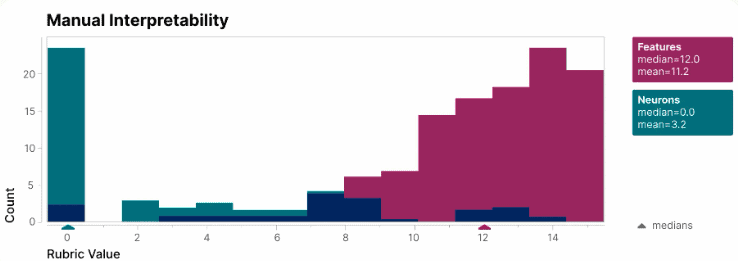

Via een blinde test bleek het met features een stuk eenvoudiger te zijn om te interpreteren wat een neuraal netwerk deed met de gegeven input dan met enkel de activaties van neurons. Ook zorgt het opsplitsen van features ervoor dat een AI-model beter aan te sturen is. Zo kan een output op voorspelbare wijze veranderd worden door bepaalde features handmatig te activeren.

Onder de motorkap

In feite laat het onderzoek van Anthropic zien hoe er beter onder de motorkap van een neuraal netwerk te kijken is. Door te zien hoe het model een input omzet in een output, is deze verder te verfijnen om ongewenste resultaten te vermijden. Anthropic stelt zelf dat het essentieel is om de veiligheid en betrouwbaarheid van AI op te hogen, zodat de maatschappij als geheel en bedrijven in het bijzonder er gebruik van kunnen maken.

Het doorgronden van AI zal eveneens wetgeving kunnen helpen. Zo zouden de beslissingen van een zelfrijdende auto beter begrepen kunnen worden, waardoor ze in toenemende mate vertrouwd kunnen worden. Er zijn talloze andere voorbeelden te noemen (zoals toepassingen in de medische, financiële of logistieke wereld) die beter gereguleerd kunnen worden als de maker van een AI-model de veilige werking ervan in concrete vorm kan aantonen.

Anthropic spreekt over “Mechanistic Interpretability”, een onderzoeksdoel waarbij gedrag van AI-modellen van binnenuit te controleren is. Met het nieuwe onderzoek hoopt het een doorbraak te hebben gecreëerd op dit gebied, hoewel het nog werkt aan een onderzoeksmethode die op grote schaal werkt.

Lees ook: Amazon investeert 4 miljard dollar in Anthropic voor betere AI-propositie