Nieuwe hardware-aankondigingen, samenwerking met Google rondom Vertex AI en updates voor ONTAP AI tijdens NetApp Insight 2023.

Als er iets is wat NetApp wil bereiken, dan is het wel wat het zelf Unified Data Storage noemt. Dit houdt onder andere in dat alle opslag binnen een organisatie, of die nu on-prem of in een van de grote hyperscalers staat, centraal beheerd wordt via ONTAP. Daarbij maakt het niet uit welk protocol je gebruikt of welk type storage het is (block, file, object).

NetApp ASA C-serie

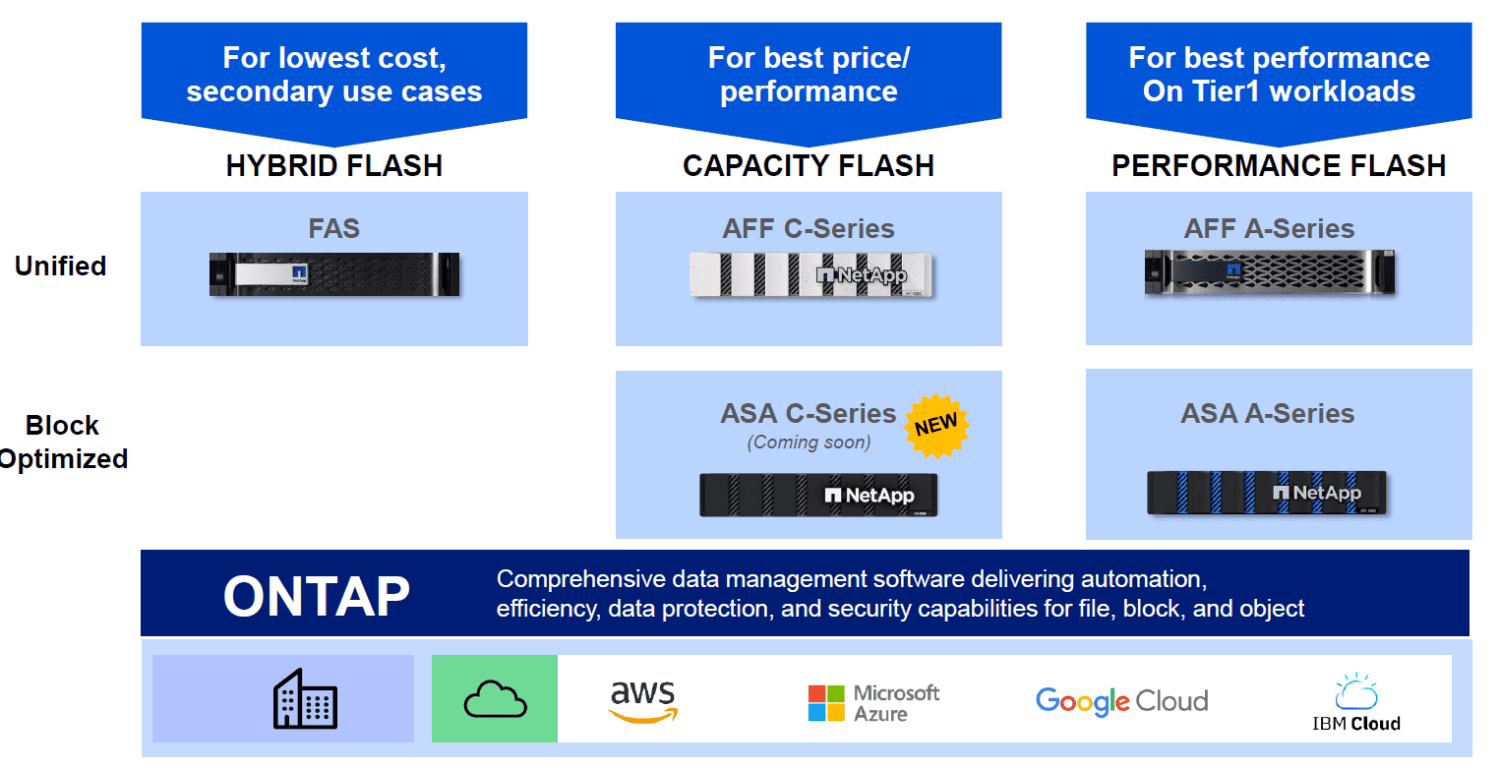

Dit zijn ambitieuze doelstellingen, waar NetApp hard aan moet werken. Dat heeft het ook zeker gedaan het afgelopen jaar. Eerder dit jaar kwam het bijvoorbeeld met een All-Flash SAN-array, de nieuwe ASA A-serie. SAN mag dan niet iets zijn waar NetApp per se bekend voor staat, maar de markt vraagt om dit type storage, dus dan is het ook belangrijk voor NetApp. Deze nieuwe lijn is geoptimaliseerd voor block workloads en wordt naast de FAS- en AFF-lijnen gepositioneerd. Dat zijn zogeheten unified productlijnen, waarin block en file samenkomen. ASA is dus expliciet geoptimaliseerd voor block workloads. Het maakt verder gebruik van dezelfde API’s, hetzelfde OS (ONTAP) en dezelfde beheeromgeving. In die zin is ASA wel gewoon onderdeel van de unified benadering van NetApp.

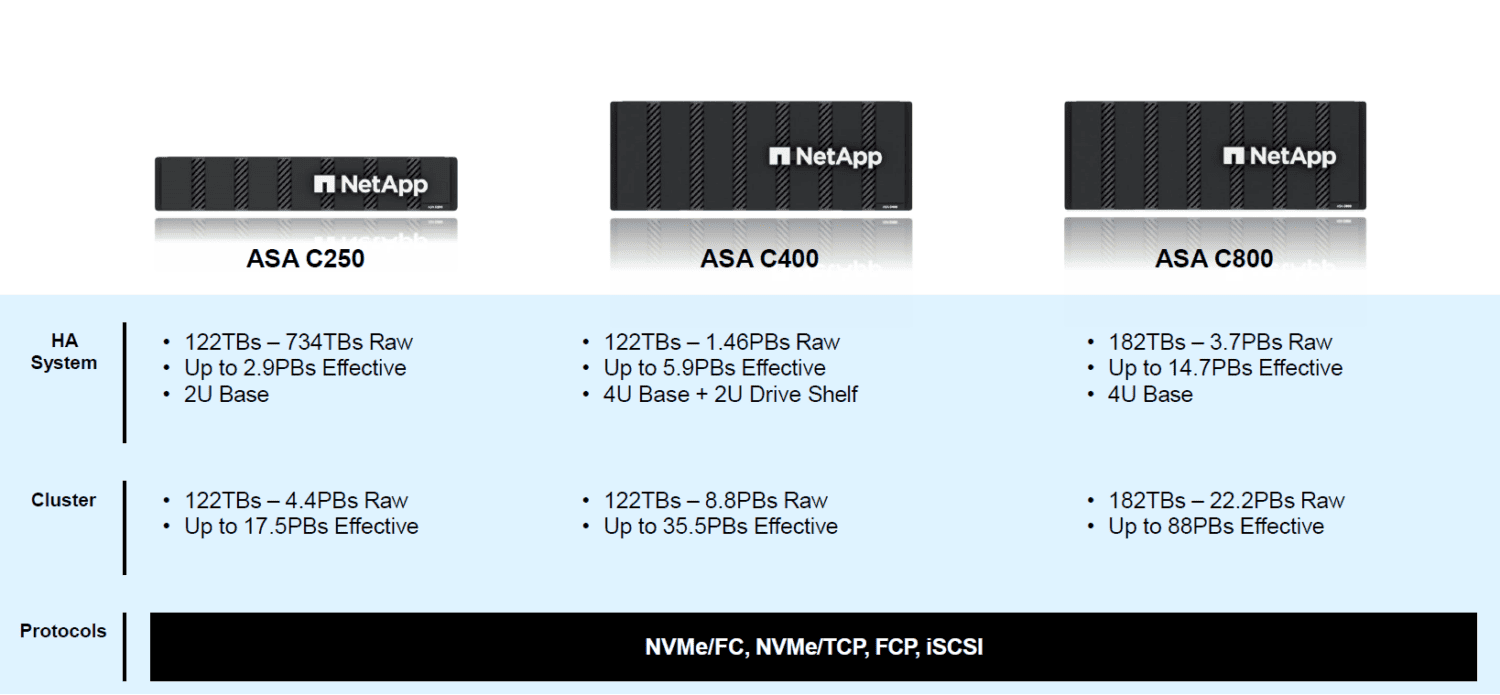

Met de ASA A-serie richt NetApp zich op Tier 1-workloads die een latency nodig hebben van minder dan 1 milliseconde. Dat is uiteraard niet voor alle workloads noodzakelijk. Vandaar dat het vandaag de ASA C-serie aankondigt. Dat is eveneens een all-flash SAN-array voor block workloads, maar dan die workloads die ook prima met 2-4 milliseconden latency uit de voeten kunnen. Dat maakt de C-serie een stuk voordeliger dan de A-serie. Meer organisaties kunnen hiermee de overstap maken naar all-flash. Het gaat hierbij zeker niet alleen maar om DR als workload, ook VMware-omgevingen kunnen hier uitstekend op draaien, evenals databases voor belangrijke workloads waarvoor een extreem lage latency geen vereiste is.

Hieronder zie je het aanbod van NetApp na de introductie van de ASA-lijn. Goed om hier te vermelden is dat NetApp vooralsnog niet gaat voor alleen maar all-flash arrays. Binnen de FAS-lijn worden ook nog HDD’s gebruikt.

Er komen drie modellen beschikbaar van de NetApp ASA C-serie: C250, C400, C800. Het enige verschil tussen de modellen zijn de capaciteiten ervan. De C250 en C400 starten bij 122 TB, de C800 bij 182 TB, met verschillende maximale capaciteiten.

Tot slot is het nog goed om te weten dat de ASA C-serie exact dezelfde garanties krijgt vanuit NetApp als de A-serie. Dat het een lagere instap biedt voor all-flash aan organisaties en meer op capaciteit is gericht dan op prestaties, betekent dus niet dat er op andere vlakken concessies worden gedaan. Dat houdt in dat NetApp ook voor de ASA C-serie zes negens beschikbaarheid garandeert. Ook voor deze serie geeft NetApp een Ransomware Recovery Guarantee. Dat laatste betekent dat NetApp klanten compenseert (middels credits) als het onmogelijk blijkt om snapshot data te herstellen na een ransomware-aanval.

Nu we het toch over een Ransomware Recovery Guarantee hebben: NetApp Keystone, het Storage-as-a-Service-aanbod van NetApp, krijgt deze ook, kondigt het bedrijf vandaag aan. Daarbij zit naast bovenstaande garantie ook nog monitoring en detectie van verdachte activiteit inbegrepen.

Meer integraties met hyperscalers

NetApp heeft al behoorlijk lang geleden ingezien dat on-prem arrays weliswaar belangrijk zijn en blijven, maar dat de public cloud dat ook zeker is als het gaat om storage. Vandaar ook dat het bedrijf heel veel investeert in het ontwikkelen van storage-oplossingen voor die omgevingen. Daarbij gaat het om native integraties, niet om het aanbieden van diensten of producten via de marketplaces van de hyperscalers. Het zijn oplossingen die NetApp samen met Microsoft, AWS en Google Cloud ontwikkelt. Azure NetApp Files is hiervan het oudste voorbeeld, gevolgd door Amazon FSx for NetApp ONTAP. Enkele maanden geleden kwam hier ook Google Cloud NetApp Volumes bij. Ook deze drie oplossingen draaien in ONTAP. Het beheer vindt plaats via BlueXP, waar we vorig jaar nog een uitgebreid verhaal over schreven.

NetApp blijft alle drie de oplossingen samen met de drie hyperscalers gestaag doorontwikkelen. Het voornaamste nieuws tijdens NetApp Insight 2023 is dat er voor Google Cloud NetApp Volumes een nieuwe service level beschikbaar komt. Ook hier zien we weer de rode draad van wat meer naar de onderkant van de markt kijken. Het gaat hier namelijk om een nieuwe laagste serviceniveau. Naast Premium en Extreme, die bij launch beschikbaar waren, is er nu ook Standard. Dat is met name interessant omdat dit serviceniveau de 20 dollarcent per gigabyte aantikt. Dat is in de storagewereld een tamelijk magisch getal, leerden we eerder dit jaar ook al van Pure Storage. Met 20 dollarcent per gigabyte is flash net zo duur als harddisk. Nu gaat het hier niet over een on-prem all-flash array, maar over storage in GCP, maar dat maakt de relevantie van dit bedrag er niet minder om.

Naast het nieuwe service level krijgt Google Cloud NetApp Volumes ook nieuwe geïntegreerde mogelijkheden op het gebied van back-up. Daarmee wordt het inrichten van een back-up in een Backup Vault in dezelfde regio als waar de data staat erg eenvoudig.

AI dichterbij organisaties brengen

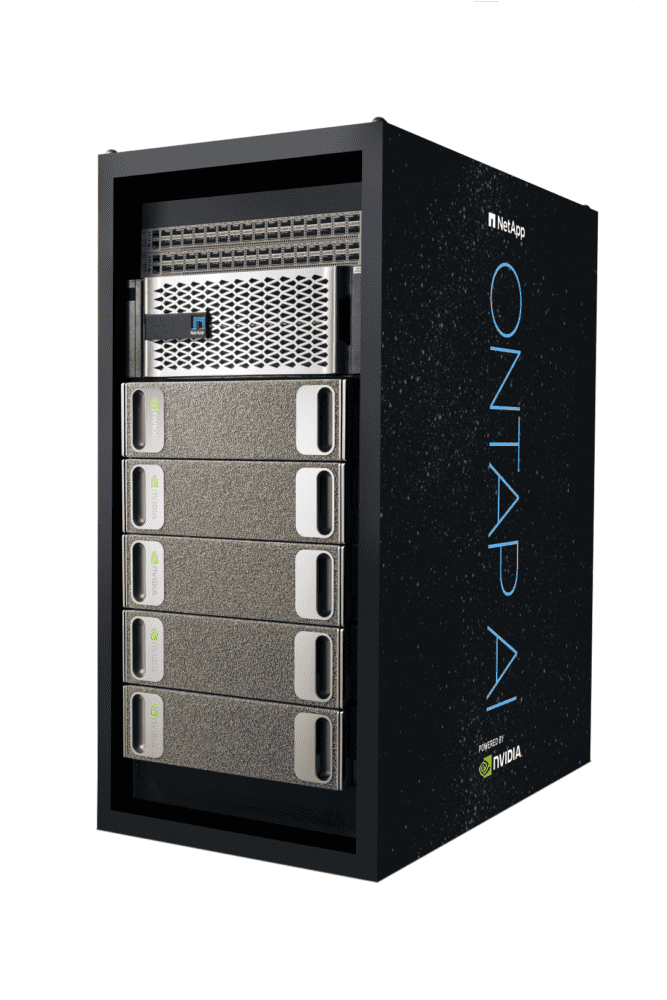

Het is 2023, dus we kunnen geen artikel schrijven over een conferentie zonder het over AI te hebben. Op dit punt heeft NetApp ook zeker iets te melden. Zo is er de oude uitspraak van CEO George Kurian dat NetApp “de beste data pipeline voor AI in de industrie heeft”. Om dit kracht bij te zetten kondigt NetApp tijdens Insight 2023 aan dat ONTAP AI nu ook formeel geschikt is voor de AFF C-serie. Dat is de betaalbare variant van de AFF-lijn.

Ook hier zien we dus weer dat er sprake is van het breder beschikbaar stellen van de nieuwste technologieën. Daarmee kunnen meer organisaties aan de slag met AI en er dus hun voordeel mee doen. Concreet kunnen deze nu een kant-en-klare unit, aangedreven door Nvidia DGX, aanschaffen en binnen enkele dagen aan de slag gaan met relatief bescheiden AI-projecten. Deze systemen zijn niet geschikt voor zeer zware AI-workloads. Het beheer kun je doen via BlueXP, maar je kunt er ook de Nvidia AI Platform Software voor gebruiken.

Google Cloud NetApp Volumes en Vertex AI

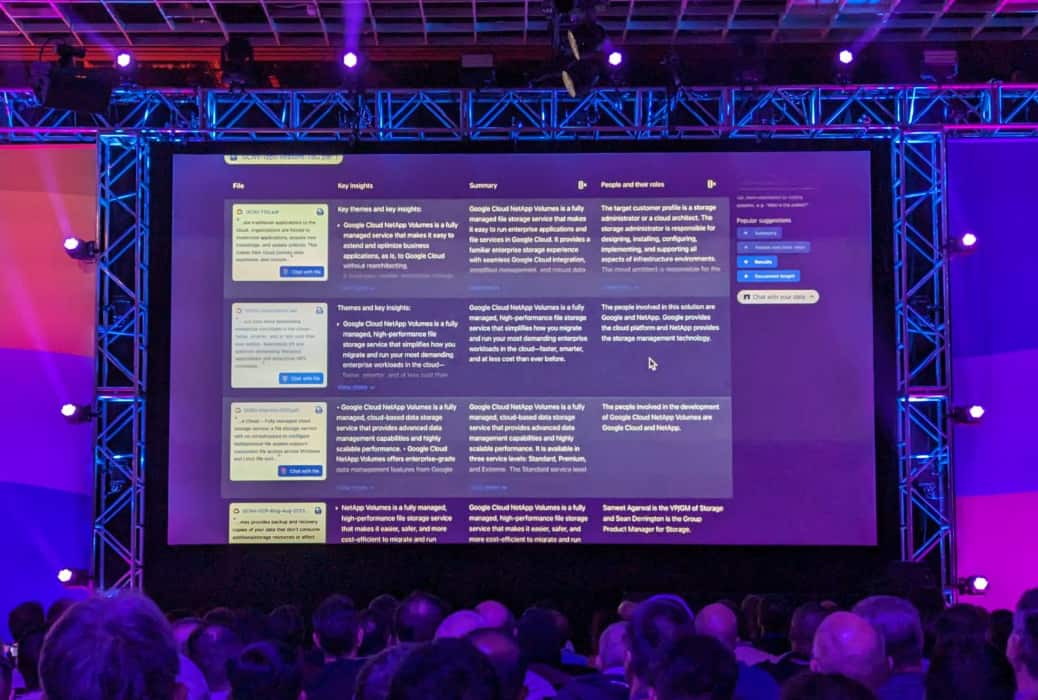

De laatste wat ons betreft interessante ontwikkeling op het gebied van AI is de integratie tussen Google Cloud NetApp Volumes (dat we hierboven al tegenkwamen) en Google Vertex AI. Dit maakt het mogelijk om de (ongestructureerde) data binnen die Google Cloud NetApp Volumes te gebruiken binnen de Vertex AI-omgeving. Je hoeft hierbij geen data te verplaatsen en dus ook geen twee versies van die data te beheren. Door deze native integratie blijft de bedrijfsdata ook altijd in het beheer van het bedrijf. Het gaat dus niet richting een publieke LLM.

De integratie werkt overigens al behoorlijk goed, hebben we gezien tijdens NetApp Insight. Er werd een live demo gegeven van enkele van de mogelijkheden van deze integratie. Wat met name opviel is hoe snel en responsief de omgeving is. Dat kan er uiteraard mee te maken hebben dat het nog niet breed wordt gebruikt, maar het heeft ook zeker iets te maken met de relatief beperkte hoeveelheid data die gebruikt wordt. Het gaat hier immers alleen om de data binnen het Google Cloud NetApp Volume. Daar gaat Vertex AI heel snel doorheen.

Rode draad: meer mogelijk maken voor meer organisaties

Al met al moet de integratie van Google Cloud NetApp Volumes en Vertex AI het voor meer organisaties mogelijk maken om met (generatieve) AI aan de slag te gaan. Organisaties hoeven immers zelf vrijwel niets te doen. Er hoeft niets geprogrammeerd of ingericht te worden. De koppeling ligt er al tussen de instance in Google Cloud en Vertex AI.

Daarmee komen we voor een laatste keer terug op het thema van dit artikel: NetApp verbreedt het aanbod in de breedste zin van het woord om de technologieën waar het al vele jaren aan werkt beschikbaar te stellen voor een groter publiek. Dat is vanuit zakelijk oogpunt een slimme zet, al moet het natuurlijk allemaal wel beheersbaar blijven voor NetApp zelf. Door alles binnen ONTAP als OS en BlueXP als beheerlaag te verankeren, is dat laatste als het goed is ook richting de toekomst blijvend haalbaar.

Conceptueel klopt het verhaal van NetApp in ieder geval behoorlijk goed. Nu moeten organisaties ook nog echt de stap maken die NetApp in principe al gemaakt heeft door een uniforme storage-omgeving bovenop on-prem en public cloud te maken. Ze moeten inzien wat de meerwaarde ervan is en ook op andere vlakken de mogelijkheid hebben om het op een uniforme (unified) manier in te richten. Dat is nog niet zo eenvoudig, hebben we recent nog uit de doeken gedaan. Daarvoor moeten alle spelers in de markt de neuzen dezelfde kant op zien te krijgen. Die van NetApp staat in ieder geval al aardig in de juiste richting, is onze conclusie.