NetApp presenteert tijdens Insight (de eigen jaarlijkse conferentie) een van de meest fundamentele updates in het aanbod in tientallen jaren. Met NetApp AFX heeft het naar eigen zeggen nu een storagelaag die is gemaakt voor AI, specifiek voor de inferencing-workloads die veel organisaties willen gaan draaien. Naast nieuwe hardware brengt dit nieuwe aanbod ook de nodige nieuwe dingen op het gebied van software. De AI Data Engine steelt op dit punt de show. In dit artikel gaan we dieper in op wat NetApp AFX en de AI Data Engine zijn en duiden we waarom dit voor NetApp zo’n belangrijke aankondiging is.

AI wordt tegenwoordig door vrijwel alle leveranciers van IT-infrastructuur gebruikt (en soms misbruikt) om nieuwe producten en diensten in de markt te zetten. NetApp doet dat zelf ook al enkele jaren. Zie hier en hier voor twee recente voorbeelden. Deze strategie lijkt overigens ook uitstekend te werken. Eerder dit jaar maakte IDC bekend dat NetApp de nummer één is in de All-Flash-markt (systemen zonder HDD’s maar met alleen maar flash-opslag). Het rapporteerde een groei van 16 procent ten opzichte van het vorige jaar. Daarmee groeit het harder dan zowel Dell (dat een krimp liet zien) en zelfs de lieveling van de All-Flash-markt Pure Storage. Alleen HPE groeide nog harder, maar heeft een veel kleiner marktaandeel.

AI-projecten mislukken vanwege slechte infrastructuur

Met alle aandacht voor AI zou je wellicht denken dat organisaties allemaal in polonaise lopen vanwege alle successen die het gebruik ervan oplevert. Niets is echter minder waar. Vrijwel alle AI-projecten die organisaties zelf opstarten, mislukken. Volgens NetApp speelt de onderliggende infrastructuur hier een belangrijke rol in. Die is simpelweg niet geschikt voor de AI-workloads waar veel (grotere) organisaties naar kijken. Met name op het gebied van inferencing staat alles nog in de kinderschoenen.

Met NetApp AFX, met afstand de grootste aankondiging die het bedrijf doet tijdens Insight, claimt het nu een (begin van) een oplossing te bieden voor AI-inferencing workloads die bedrijven willen draaien. Je zou dit kunnen zien als een eerste echt concrete invulling van de Intelligent Data Infrastructure-visie die NetApp vorig jaar liet zien. Dat is wellicht een tikje gechargeerd, want NetApp heeft het afgelopen jaar natuurlijk niet stilgezeten. Toch voelt het wel een beetje zo. AFX is qua hardware (en software) namelijk echt een fundamenteel ander beestje dan alles wat NetApp verder in het SAN- en NAS-portfolio heeft zitten.

NetApp AFX: gedisaggregeerd en extreem schaalbaar

Als we helemaal platslaan wat NetApp AFX moet bewerkstelligen, kunnen we de woorden van Sandeep Singh, SVP en GM Enterprise Storage bij NetApp, aanhalen die hij sprak tijdens een sessie die we bijwoonden deze week: “NetApp AFX geeft klanten de prestaties om de GPU’s te kunnen blijven voeden.” Daar schortte het aan, in ieder geval als het gaat om inferencing-workloads, is de achterliggende aanname.

Om de prestaties te kunnen bereiken die nodig zijn, moet de storage schaalbaar zijn. Dat kan alleen effectief en efficiënt via een gedisaggrereerde architectuur. Dat houdt in dat de compute-laag van AFX losgekoppeld is van de capaciteitslaag. De compute laag regelt zaken zoals datamanagement en zorgt voor I/O. De capaciteitslaag bestaat uit NVMe flash-opslag. De maximaal 128 (compute) nodes waar AFX naartoe kan opschalen en de opslag worden onderling verbonden via ethernet (400G). NetApp AFX schaalt enorm ver door. De X in de naam geeft het aan: we hebben het over schalen richting exabytes.

Het loskoppelen maakt schalen op meerdere manieren mogelijk, zonder dat er sprake is van overprovisioneren. Wil je hogere prestaties, dan voeg je storage controllers toe. Gaat het om het opschalen van capaciteit, voeg je dozen met flash-opslag toe. Met in het achterhoofd dat NetApp AFX net zoals onder andere AFF unified file- en object-opslag is, creëer je hiermee simpel gezegd een grote storage pool voor file- en object-workloads waar de storage controllers slimme dingen mee kunnen doen en die is ingericht om alle kanten mee op en uit te kunnen schalen die organisaties op willen.

Bovenstaande insteek, het loskoppelen van controllers en storage, is niet nieuw overigens. Met name Pure Storage zet hier ook al geruime tijd op in, in de meest extreme vorm met Pure Fusion. Voor NetApp, dat van oudsher een complexere en dieper geïntegreerde stack heeft dan Pure, is dit echter een prestatie van formaat. Dit moet een enorme klus zijn geweest.

Wellicht ten overvloede, maar NetApp AFX is net zoals de rest van het portfolio van het bedrijf (met uitzondering van StorageGrid en de E Series) gebouwd op ONTAP. Dat is al heel wat jaren de basis voor alles wat NetApp ontwikkelt. ONTAP zorgt ervoor dat NetApp de hybride benadering optimaal kan uitvoeren en bijvoorbeeld ook de diepe integraties met AWS, Azure en Google Cloud kan bieden.

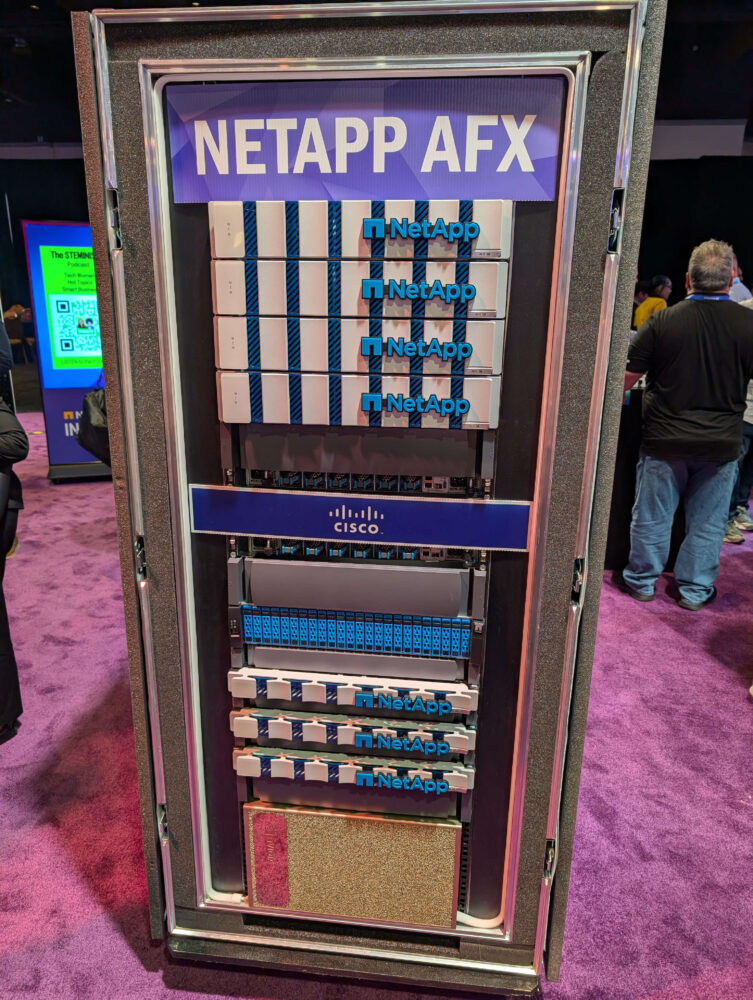

NetApp AFX heeft eigen compute

Als we denkbeeldig een NetApp AFX openmaken, zien we een verrassing. Naast een AFX 1K storage controller en NX224 NVMe-behuizing zien we namelijk ook de DX50. Dat is zonder twijfel het meest onderscheidende onderdeel van de NetApp AFX. Dit is namelijk een onderdeel dat NetApp een data compute node noemt.

De DX50 is geen compute node waar je zelf VM’s of databases op kunt draaien. We moeten het ook zeker niet zien als een poging van NetApp om die wereld binnen te treden. Dat horen we van Jeff Baxter, VP Product Marketing bij NetApp. Binnen de 1U-grote DX50 snort een Nvidia L4-GPU in combinatie met een AMD Genoa 9554P-CPU, aangevuld met 15 TB aan opslag in een U.2 form factor.

Je kunt de DX50 het beste zien als een tegenhanger van de DPU’s die je in servers, switches en routers tegenkomt. De compute node stelt je in staat om slimme dingen toe te voegen aan je data pipelines en deze te offloaden. En hier komt de AI Data Engine om de hoek kijken.

AI Data Engine voegt veel toe aan NetApp AFX

De aankondiging van NetApp AFX is op meerdere manieren zeer fundamenteel voor NetApp (en de storagemarkt). Uiteraard is de nieuwe gedisaggregeerde architectuur de basis. De toevoeging van de DX50 en daarmee de AI Date Engine is wat ons betreft echter ook niet te onderschatten. Het voegt vier dingen toe die het voor klanten eenvoudiger moeten maken om veilige en efficiënte data pipelines te bouwen. We bespreken ze hieronder kort.

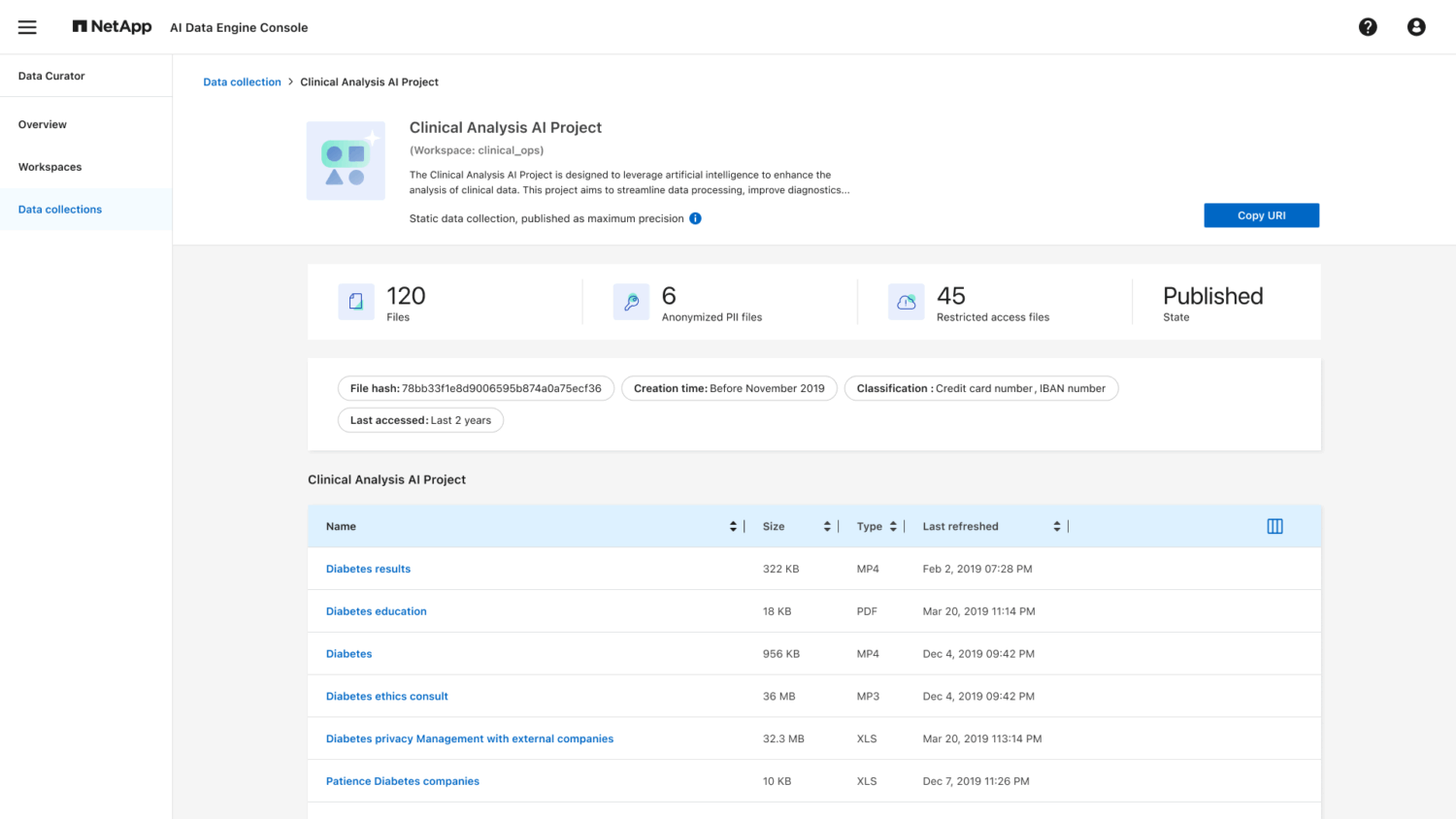

De eerste twee features van de AI Data Engine richten zich op het binnenhalen en up-to-date houden van data. Een Metadata Engine helpt klanten bij het toegang geven tot data. Klanten hebben data doorgaans in silo’s staan, verspreid over meerdere locaties. Storage admins kunnen data scientists en andere collega’s met behulp van de metadata engine toegang geven tot de juiste datasets.

Met Data Sync kunnen ze er daarnaast ook voor zorgen dat er nooit oude data door AI gebruikt wordt. Hier zet NetApp zaken zoals SnapMirror en SnapDiff in om volledig geautomatiseerd te syncen en wijzigingen te detecteren. Gagan Gulati, SVP en GM Data Services bij NetApp heeft het erover dat NetApp hier “het beste wat het heeft te bieden” inzet om data altijd up-to-date te houden.

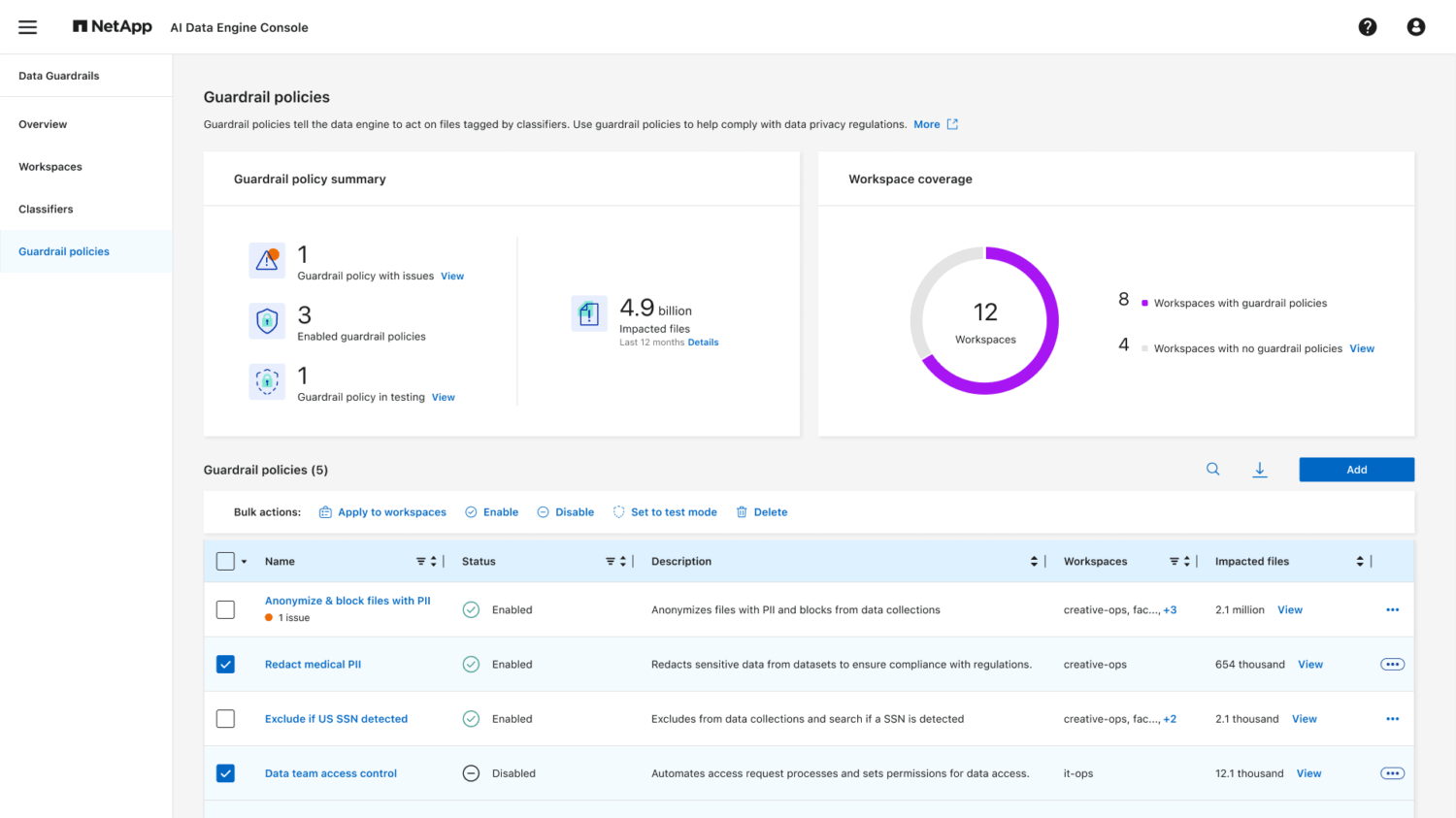

Heb je het over AI, dan gaat het ook al snel over het in toom houden ervan. Daar zijn regels, policies en limieten voor nodig. Dat is wat Data Guardrails toevoegt aan de AI Data Engine. Deze feature moet ervoor zorgen dat gevoelige data altijd als zodanig wordt herkend. Het moet deze data ook beschermen tegen oneigenlijk gebruik. Klanten kunnen daarnaast policies instellen om dingen volledig geautomatiseerd af te laten handelen. Tot slot zitten er mogelijkheden in om gevoelige informatie ‘zwart te lakken’ en uit te sluiten van gebruik door AI-applicaties of -chatbots.

Data Curator: eindelijk een oplossing voor vector database bloat

De laatste van de vier onderdelen van de AI Data Engine verdient een eigen paragraaf wat ons betreft. Data Curator lost namelijk een probleem van het vectoriseren van databases voor AI-toepassingen op waar we het al heel lang over hebben. Dit kan namelijk zorgen voor een groei in data van 10 tot wel 20 keer de originele omvang. Vorig jaar tijdens NetApp Insight gingen we er al diep op in tijdens een podcast die we ter plaatse opnamen. Toen was er echter nog geen oplossing voorhanden, ook al gaf onze gast toen aan dat er in de labs van NetApp al wel aan gewerkt werd.

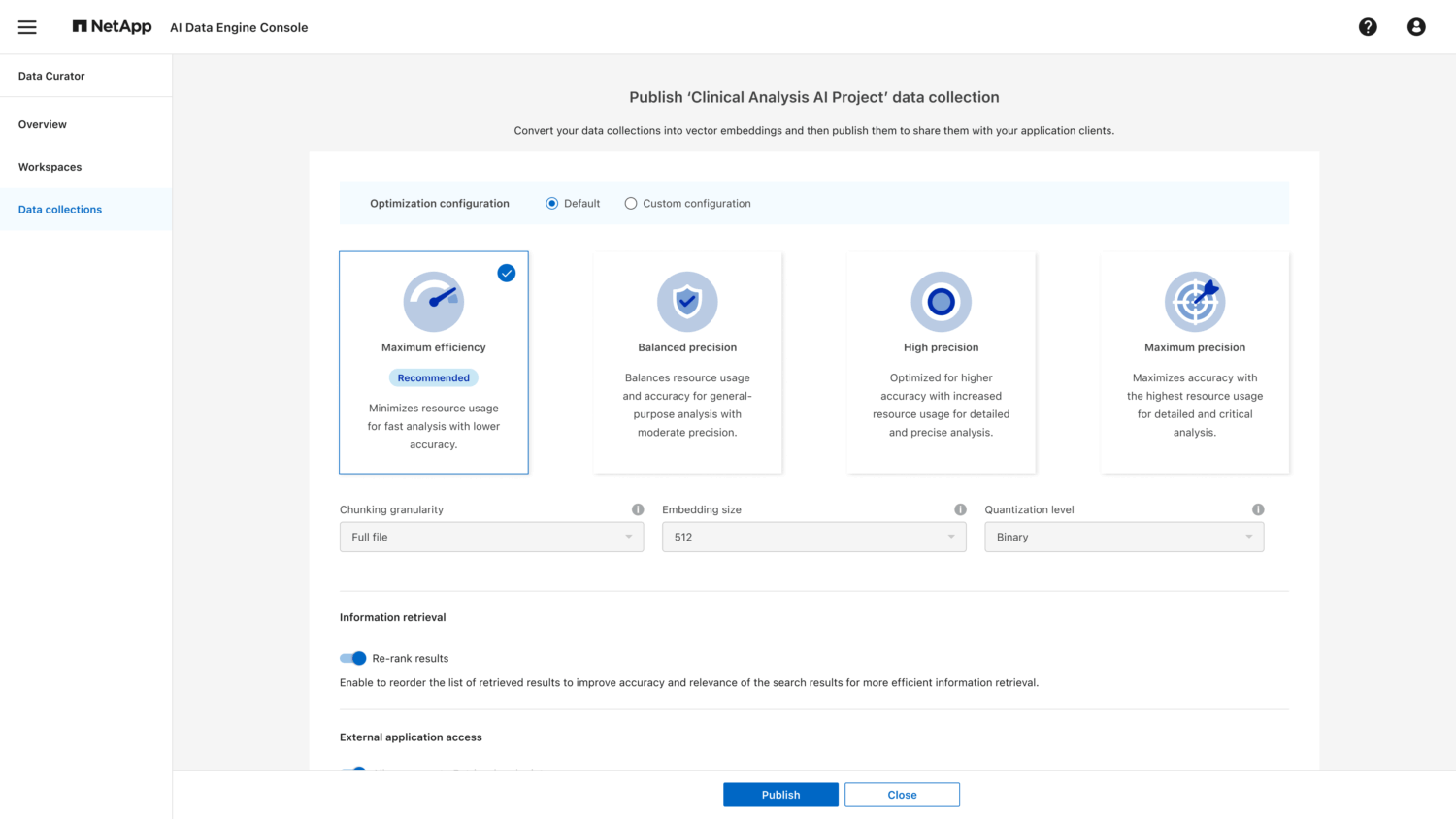

Met Data Curator in de AI Data Engine heeft NetApp nu naar eigen zeggen iets waarmee de toename verkleind kan worden. NetApp belooft een toename van maximaal 5 keer de originele omvang van de data, horen we van Gulati. Dat kan serieuze besparingen opleveren. Dat niet alleen, het moet er ook voor zorgen dat de prestaties van de AI-workloads omhoog gaan. De vector embeddings moeten immers minder vaak doorzocht worden.

NetApp heeft deze nieuwe feature niet helemaal zelf ontwikkeld overigens. De AI Data Engine is namelijk gebouwd volgens de principes van het Nvidia AI Data Platform. Dankzij onder andere de vectorisatie-API’s in Nvidia NIM, de inferencing microservices van Nvidia, is het mogelijk om het omzetten van ‘gewone’ data voor gebruik in vector databases zo efficiënt mogelijk te laten verlopen.

Er komen nog meer compute nodes aan

Als het gaat om compute nodes, is het goed om te benadrukken dat NetApp AFX in principe niet getrouwd is met de DX50 om de AI Date Engine te draaien. Deze optionele module van NetApp AFX kan ook vervangen worden door andere modellen. Er komt in ieder geval ondersteuning voor de Nvidia RTX PRO-servers. Daar zitten RTX PRO 6000 Blackwell Server Edition GPU’s in.

Een vraag die zich opdringt is of er ook ondersteuning komt voor compute nodes met GPU’s van andere aanbieders. Dat is een vraag waar Sandeep Singh in ieder geval geen antwoord op kon of wilde geven aan ons. Behalve dan uiteraard het gebruikelijke obligate antwoord dat NetApp altijd alle opties openhoudt.

Gezien de sterke afhankelijkheid van de AI Data Engine van het Nvidia Data Platform zou dat voor zover wij het kunnen zien in ieder geval meer zijn dan alleen een andere GPU in een compute node stoppen. De software stack eromheen en erbovenop, iets waar Nvidia heel veel werk in heeft gestopt de laatste jaren, moet er immers ook zijn om bijvoorbeeld Data Curator mogelijk te maken. Heel snel zien we dit in ieder geval niet gebeuren. AMD is nu in ieder geval wel present in de DX50 (als CPU), al timmert Nvidia ook op dat gebied sterk aan de weg. Denk aan de recente deal met Intel, maar ook aan de eigen CPU’s waar het aan werkt.

Modulariteit biedt flexibiliteit

Tot slot willen we nog een wellicht wat onderbelicht onderdeel van NetApp AFX uitlichten. De compute node is zoals we al eerder aanhaalden een optionele component. Dat betekent dus ook dat je NetApp AFX zonder deze component af kunt nemen en inzetten. Potentieel slaat NetApp met AFX dus eigenlijk twee vliegen in een klap. Met compute node voor de inferencing-workloads in EDA, SQL, VMware, zonder voor meer HPC-gerelateerde workloads.

HPC-workloads kunnen nu al draaien in combinatie met met de high-end AFF-systemen. Wil je er echter zaken zoals check pointing aan toevoegen, waar je onder andere tijdelijke buffers voor nodig hebt, dan heb je daar een apparaat tweede systeem voor nodig. De NetApp E Series kan hier bijvoorbeeld voor ingezet worden.

Conclusie: NetApp AFX luidt nieuw tijdperk in

Het mag duidelijk zijn dat NetApp AFX veel meer is dan een refresh. Het is ook veel meer dan een uitbreiding op een bestaand aanbod. NetApp AFX is een nieuw begin voor NetApp. Dat kan het althans zijn en worden. Hiermee bedoelen we niet dat NetApp alles wat het tot nu toe gedaan en gemaakt heeft bij het grofvuil zet en opnieuw is begonnen. Het heeft met AFX wel alles op een fundamenteel andere manier in elkaar gezet.

Op korte termijn heeft NetApp AFX vooral impact op de AI-ambities van NetApp en klanten. Voor de langere termijn zien we verschillende routes. Een ervan is dat NetApp AFX ervoor gaat zorgen dat het aanbod van NetApp als geheel veel meer unified wordt. NetApp AFX zou zomaar eens de onderliggende architectuur en daarmee het onderliggende platform (met ONTAP als OS) voor het hele portfolio kunnen worden. Daarmee neemt NetApp een veelgenoemd argument tegen de producten van het bedrijf vanuit sommige concurrenten, dat NetApp te veel verschillende platformen heeft, voorgoed weg. Zo bekeken kan NetApp AFX fundamenteel een nieuw begin betekenen voor het bedrijf.