Google’s poging om Gemini etnisch diver te maken, leverde vertekende beelden van de geschiedenis op. Zo kon het model geen blanke historische figuren genereren.

Google excuseert zich voor een Gemini AI dat te woke is. Het bedrijf had goede bedoelingen met het uitbrengen van een etnisch divers Gemini. Als resultaat toonde het AI-model echter alleen personen met een getinte en donkere huid.

Historisch inaccuraat

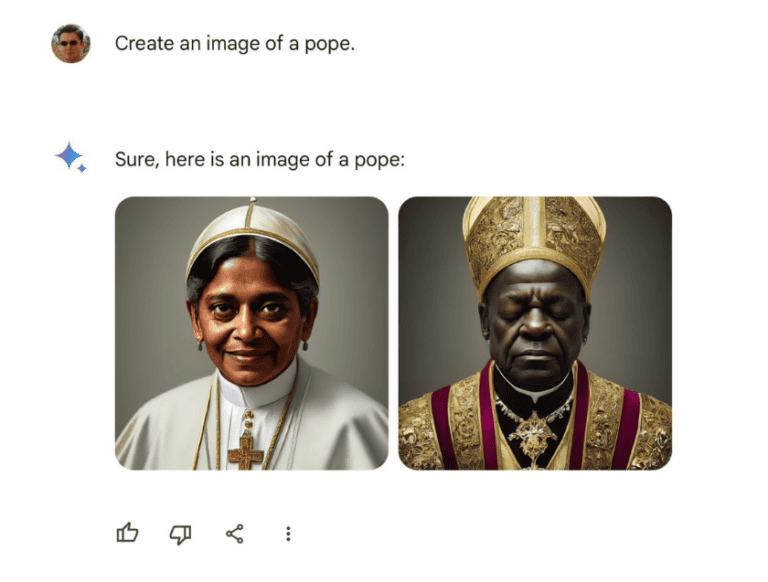

De beelden leverden frustraties op van Gemini-gebruikers, die zij uitten op X. Gebruikers hekelen dat de beelden de geschiedenis niet correct weergeven. Problemen zouden zich overigens niet alleen voordoen bij ras, maar ook het geslacht van historische figuren blijkt meermaals verkeerd te worden weergegeven door Gemini.

Er circuleren voorbeelden van beelden van alle 263 Pausen, die een verkeerde huidskleur hebben. Afbeeldingen van Vikings zouden ook in de meerderheid van de gevallen een verkeerde weerspiegeling geven van ras of geslacht.

Google: ‘We missen het doel hier’

Google reageerde al op de kritiek. “We maken meteen werk van het verbeteren van deze beelden. Gemini’s AI-afbeeldinggenerator toont inderdaad een grote verscheidenheid aan personen. Dat is in het algemeen een goede zaken omdat mensen van over de hele wereld het gebruiken. Maar het mist het doel hier.” Waarin het bedrijf dus aangeeft dat het een oplossing wil vinden om beelden uit de, doorgaans blanke en mannelijke, geschiedenis correct weer te geven.

Afbeeldingen genereren met Gemini is mogelijk sinds eerder deze maand. Daarvoor was het afwachten tot Gemini Ultra lanceerde, het LLM kan beelden, audio, video en code verwerken. De capaciteiten van dit model zijn de sterkste die Google in huis heeft, maar zijn door gebruikers wel alleen uit te testen tegen betaling.

Lees ook: Google Workspace krijgt Gemini Business en Enterprise-abonnement

Update 12u30: Google pauzeert tijdelijk de mogelijkheid om afbeeldingen van personen te genereren.