De computer vision API’s van Microsoft, Google en IBM vertonen volgens onderzoekers gender bias (gendervooroordelen) wanneer personen mondkapjes dragen. Foto’s van vrouwen krijgen vaak de labels ‘ducttape’ en ‘modeaccessoires’, terwijl foto’s van mannen voornamelijk de label ‘gezichtsbeharing’ krijgen.

Ilinca Barsan, Director of Data Science bij marketingcommunicatiebureau Wunderman Thompson, had een foto van zichzelf met een mondkapje geüpload op Google Cloud Vision API om de nauwkeurigheid van de API te testen. De API labelde haar onder andere met ‘ducttape’ met een confidence score van 96,57 procent. Een hoge confidence score betekent dat het AI-model vertrouwen heeft in de bevinding. Barsan besloot daarna om 265 foto’s van mannen en vrouwen met mondkapjes te testen op verschillende API’s.

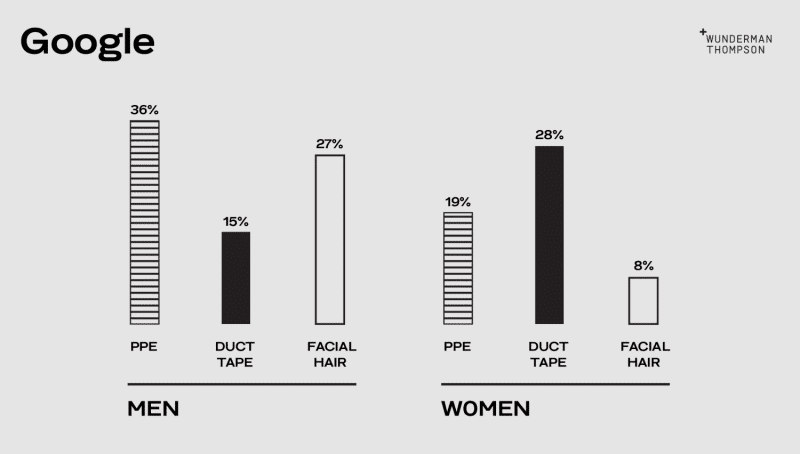

Cloud Vision API

De Cloud Vision API had 36 procent van de foto’s van mannen correct gelabeld als PPE (Personal Protective Equipment), oftewel mondkapjes. 27 procent werd echter aangemerkt als gezichtsbeharing. Ook mannen kregen de label ‘ducttape’ (15 procent), met een confidence score van 92 procent.

Bij de vrouwen werd maar 19 procent van de foto’s correct gelabeld, terwijl de API in 28 procent van de foto’s de label ‘duct tape’ toekende. Dit is bijna twee keer zoveel als bij de mannen en in beide gevallen is de API zeker van het resultaat.

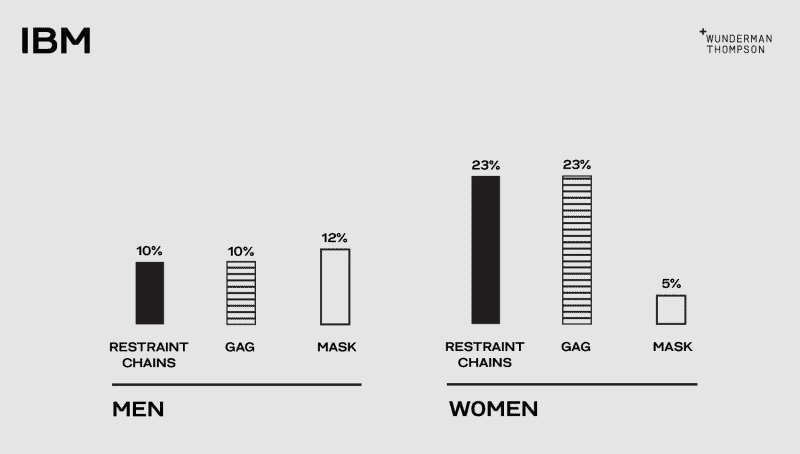

IBM

Dezelfde foto’s werden ook op IBM Watson Visual Recognition getest. 23 procent van de foto’s van vrouwen werd gelabeld als ‘restraint chains’ (kettingen), 23 procent als ‘gag’ (mondprop) en maar 5 procent van de foto’s werd correct gelabeld als mondkapje. De labels ‘restraint chains’ en ‘gag’ werden ook toegekend aan mannen, in 10 procent van de foto’s. Maar 12 procent van de foto’s van mannen is correct gelabeld.

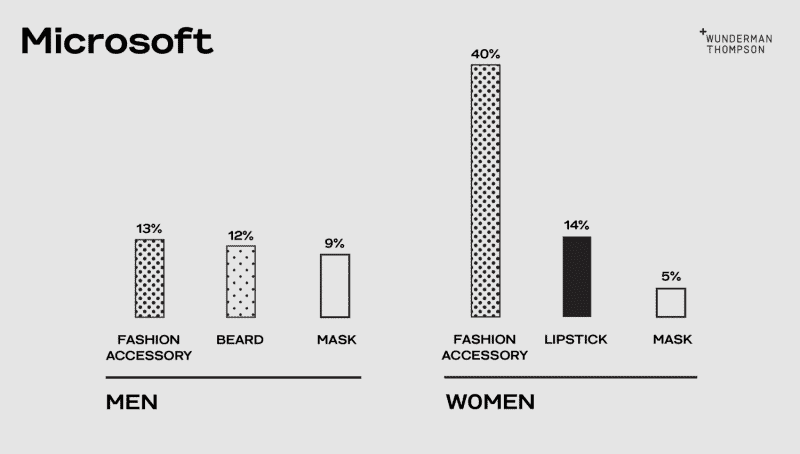

Azure

Tot slot heeft het team van Barsan de foto’s ook getest op Microsoft Azure Cognitive Services Computer Vision API. Labels zoals ‘gags’ en ‘ducttape’ komen bij deze test niet voor. De API heeft echter wel veel moeite om de personen met mondkapje, zowel mannen (9 procent) als vrouwen (5 procent), succesvol te labelen. Wat erg opvalt is dat bij de foto’s van vrouwen de API in 40 procent van de gevallen de foto’s labelde met ‘modeaccessoire’ tegenover 13 procent bij mannen. Daarnaast krijgen de mannen de label ‘baard’ (12 procent) erbij en de vrouwen de label ‘lippenstift’ (14 procent).

Oorzaak

Barsan vermoedt dat het gebruik van labels als ‘restraint chains’, ‘duct tape’ en ‘gag’ teruggebracht kan worden naar de datasets waarop deze API’s getraind zijn. Barsan gelooft niet dat het de intentie is van de techgiganten, maar een onvoorzien gevolg van ongebalanceerde datasets en machine learning-modellen.

Volgens de onderzoekers liet een simpele zoekopdracht naar ‘duct tape man’ overwegend mannen zien die van top tot teen bedekt waren met ducttape als een soort van grap, terwijl de zoekopdracht ‘duct tape woman’ voornamelijk foto’s liet zien van bange vrouwen van wie de mond werd bedekt met ducttape.

Volgens Barsan kunnen deze datasets en modellen schadelijke stereotypen voortzetten die een weerspiegeling zijn van een cultuur waarin geweld tegen vrouwen vaak genormaliseerd en uitgebuit wordt.