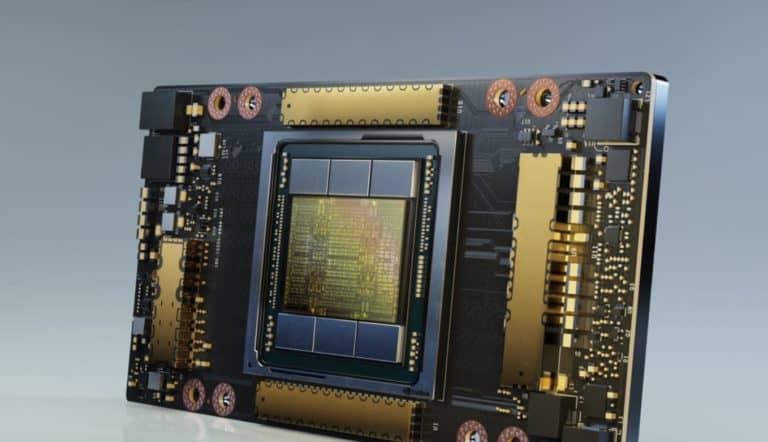

Google komt met een nieuwe serie virtual machines in de Compute Engine A2-lijn. De vm’s worden geleverd met Nvidia A100-gpu’s. Google biedt varianten aan waar tot 16 van deze gpu’s in een enkele node zitten.

Daarmee is het de grootste single-node GPU instance van welke public cloud-provider op dit moment, claimt Google. Daarmee zouden ze geschikt moeten zijn voor de meest veeleisende workloads die klanten mogelijk zouden kunnen hebben. Daarbij zouden bovendien de efficiëntie hoger en de kosten lager moeten liggen, schrijft SiliconAngle.

Ideaal voor machine learning

“Een enkele A2-vm ondersteunt tot 16 Nvidia A100-gpu’s, waarmee het voor onderzoekers, data scientists en ontwikkelaars eenvoudig wordt om veel betere prestaties voor hun schaalbare Cuda compute-workloads zoals het trainen van machine learning, interference en HPC te behalen”, stellen productmanagers Bharath Parthasarathy en Chris Kleban. “De familie van A2-vm’s op Google Cloud Platform is ontworpen om te voldoen aan de meest veeleisende HPC-applicaties, zoals CFD-simulaties met Altair ultraFluidX.”

Zowel omhoog als omlaag schaalbaar

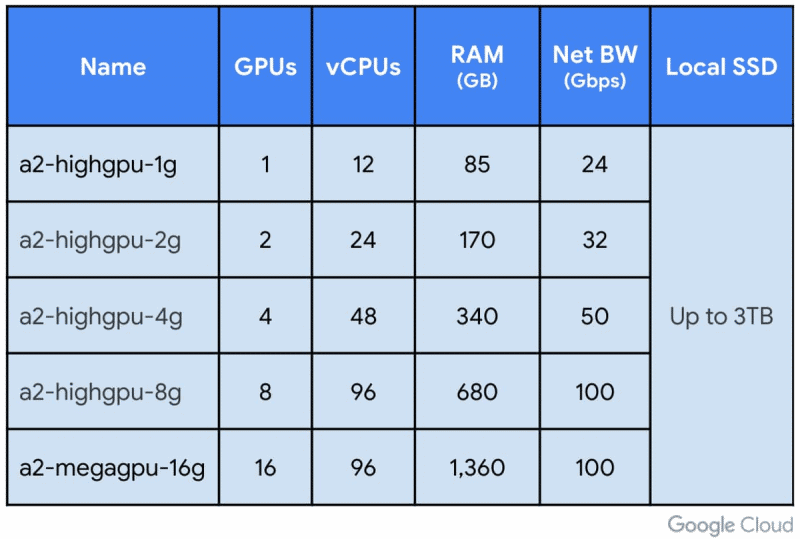

De vm’s kunnen zowel omlaag als omhoog geschaald worden. Zo biedt Google naast vm’s met 16 gpu’s ook varianten met 1, 2 4 of 8 gpu’s aan. Voor gebruikers die juist meer gpu-kracht nodig hebben, biedt Google ‘ultragrote gpu-clusters’ aan. Deze clusters bestaan uit duizenden gpu’s bedoeld voor de meest veeleisende taken op het gebied van het trainen van machine learning. Binnen nodes zijn de gpu’s onderling verbonden met NVLink, wat voor betere samenwerking tussen verschillende gpu’s moet zorgen.

Tien keer zo snel als voorgangers

Google claimt dat de Compute Engine A2-vm’s tot wel tien keer zo snel zijn als hun voorgangers op basis van de Nvidia V100-gpu’s. Klanten die de vm’s al hebben mogen uitproberen, beamen deze claims. “We erkennen dat Compute Engine A2-vm’s onze verwerkingstijden aanzienlijk kunnen verminderen en ons veel sneller laten experimenteren”, zegt Kyle de Freutas van AI-bedrijf Dessa. “Het draaien van Nvidia A100-gpu’s op het AI-platform van Google Cloud geeft ons de basis die we nodig hebben om te blijven innoveren en om ideeën in impactvolle realiteiten voor onze klanten te veranderen.”

De nieuwe A2-instances met Nvidia A100-gpu’s zijn per direct verkrijgbaar in drie regio’s: us-central1, asia-southeast1 en europe-west4. Later dit jaar voegt Google daar nog enkele regio’s aan toe.