AWS introduceert Amazon EC2 Capacity Blocks for ML. Hiermee krijgen bedrijven gemakkelijk toegang tot cloudgebaseerde GPU-rekenkracht voor kortdurende AI-workloads.

Bedrijven die rekenkracht zoeken voor korte AI-workloads kunnen deze nu met Amazon EC2 Capacity Blocks for ML aan de slag bij AWS. Hiermee besparen ze volgens AWS op het zelf aanschaffen van deze capaciteit voor de langere termijn. Dit is veelal niet rendabel, aangezien de capaciteit lang niet altijd ten volle wordt benut. Daarnaast krijgen klanten voor hun AI-werkzaamheden niet altijd toegang tot de veelgevraagde Nvidia-GPU’s.

Introductie Amazon EC2 Capacity Blocks for ML

Met de nieuwe dienst van AWS kunnen klanten dit probleem oplossen. De dienst reserveert voor klanten capaciteit op honderden Nvidia H100-GPU’s die op basis van colocatie worden gehost in de Amazon EC2 UtraClusters voor high-performance ML-workloads.

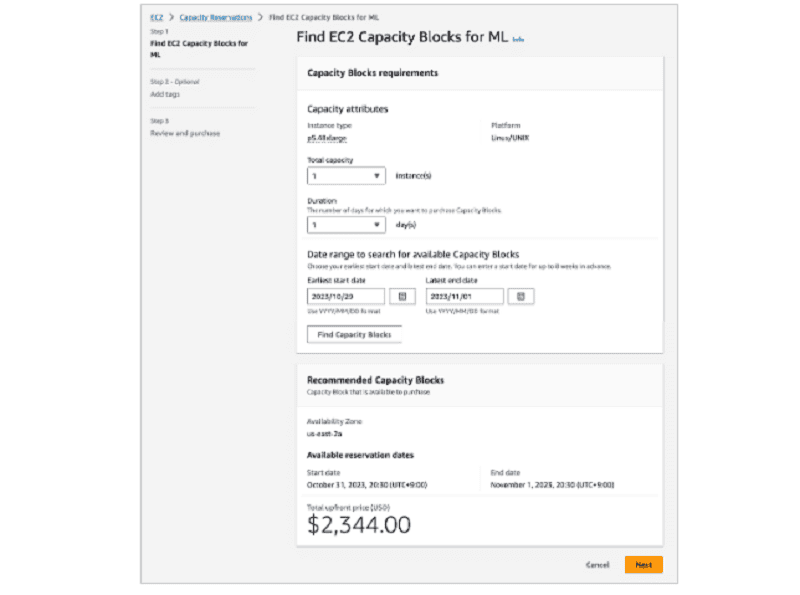

Voor toegang tot deze Amazon EC2 Capacity Blocks for ML kiezen gebruikers de gewenste clusteromvang, de toekomstige startdatum en de vereiste duur voor de werkzaamheden. Dit geeft voorspelbare en directe toegang tot de voor de AI-projecten benodigde GPU-bronnen. AWS vergelijkt het consumptiemodel met een hotelreservering voor een bepaalde verblijfsduur, maar dan voor GPU-instances voor AI-projecten.

De Amazon EC2 Capacity Blocks-dienst heeft volgens experts ook wel veel weg van een ouderwetse mainframe-architectuur. Hierbij werden deze computeromgevingen ingezet als ‘timeshare computers ’die honderden gebruikers tegelijk ondersteunden voor verschillende workloads.

Beschikbaarheid en pricing

Huidige AWS-klanten kunnen nu via de AWS Management Console, CLI of SDK de GPU-capaciteit binnen Amazon EC2 Capacity Blocks for ML reserveren. De dienst is eerst beschikbaar in de AWS US East (Ohio)-regio. Het aantal AWS-regio’s wordt de komende tijd verder uitgebreid. De kosten voor het gebruik van de dienst zijn echter niet al te laag, blijkt uit het uitgebrachte overzicht.

Lees ook: AWS komt met zelfstandige sovereign cloud in Europa