Swami Sivasubramanian is verantwoordelijk voor data en machine learning bij AWS. Hij geeft in een twee uur durende keynote uitleg over het ontwikkelen van een datastrategie middels allerlei AWS-oplossingen. Tussendoor kondigt hij ook de nodige productupdates aan, zodat organisaties nog meer of eenvoudiger waarde uit hun data kunnen halen.

Sivasubramanian trapt af door te stellen dat elke organisatie een goede datastrategie nodig heeft. Hij stelt dat data altijd beter is dan intuïtie. Een uitspraak die je kan meenemen richting het management van je organisatie. Het zal ongetwijfeld de nodige discussies gaan opleveren.

Als voorbeeld haalt hij Amazon aan. Het hele bedrijf is gebouwd op basis van data. In de allereerste versies van Amazon.com werden al aanbevelingen gedaan bij het kopen van boeken: welke boeken zou je nog meer moeten lezen en welke boeken kopen anderen ook? Dit werd in die tijd nog niet bepaald met machine learning, maar gewoon met de hand, wellicht op basis van verkoopcijfers. Inmiddels is dit ongetwijfeld een zeer geavanceerd machine learning model.

Ontwikkelen van datastrategie is niet eenvoudig

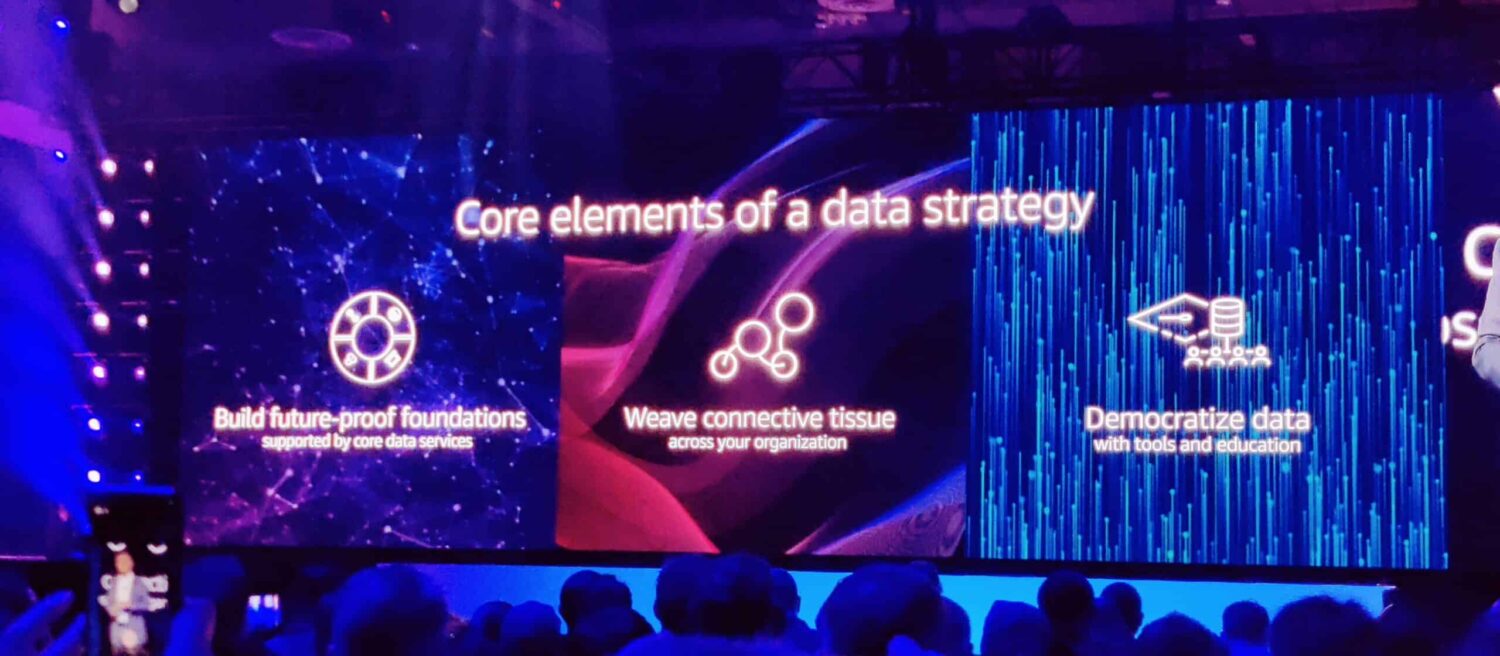

Het ontwikkelen van een goede datastrategie is echter niet eenvoudig. Data moet toegankelijk zijn, maar ook op verschillende manieren kunnen worden geïntegreerd met allerlei verschillende tools. Hiervoor zijn pipelines nodig, maar ook een overzichtelijke structuur die niet gelimiteerd is op het gebruik vandaag de dag, maar ook bruikbaar is in de toekomst. Je wilt niet je datastrategie en de kern ervan elk jaar vervangen omdat je zakelijke eisen of oplossingen zijn veranderd. Tot slot is er nog een stukje governance, compliance en security, want data moet wel veilig zijn opgeslagen en niet zomaar voor iedereen toegankelijk zijn.

Sivasubramanian stelt dat organisaties niet meer om data heen kunnen. Data ligt ten grondslag aan moderne innovatie.

Data ligt ten grondslag aan moderne innovatie.

Er is geen uniforme database of analytics tool om waarde uit je data te halen

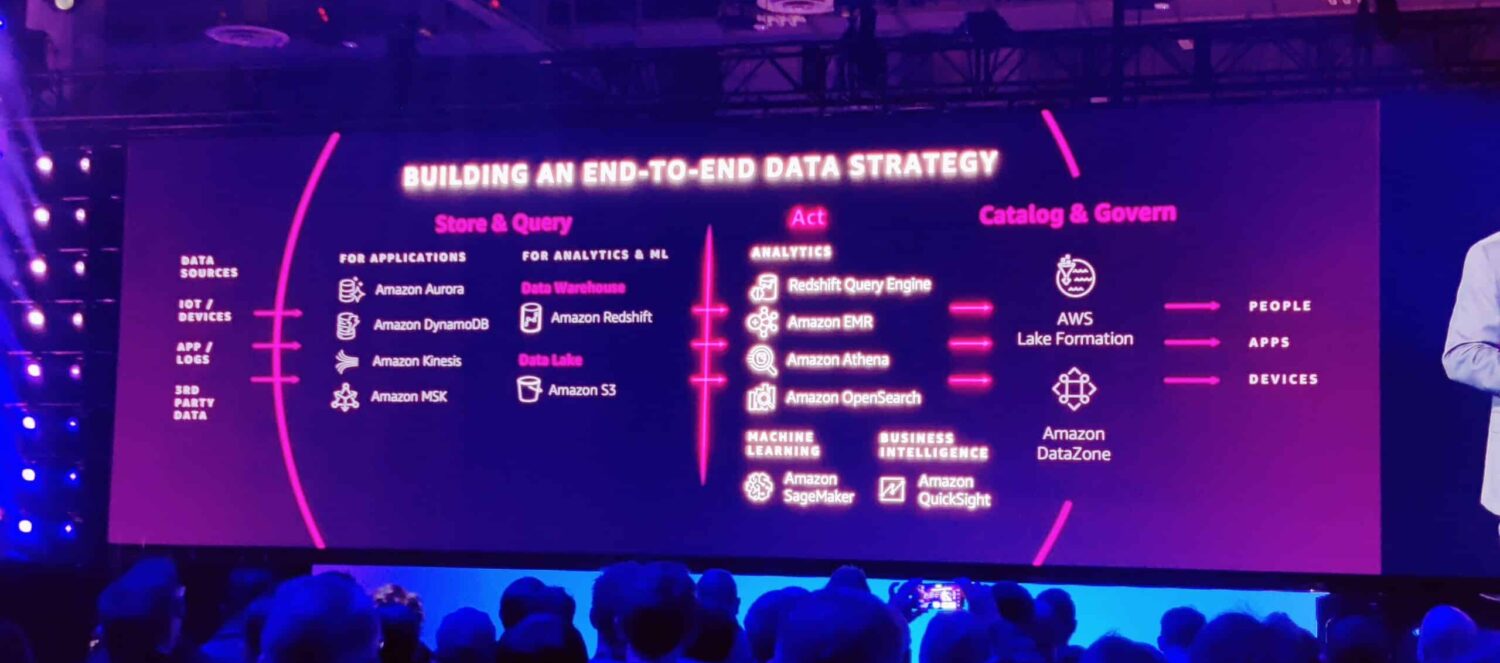

Er zijn de nodige aanbieders die stellen een soort all-in-one product te kunnen leveren voor je data en analytics. Dat klinkt eerlijk gezegd ook het meest ideaal. Gewoon één applicatie waarin je al je analyses kan doen. Sivasubramanian maakt daar in zijn keynote echter korte metten mee. Hij stelt dat de top 1000 AWS-klanten meer dan tien verschillende databases en analytics tools van AWS gebruiken. Oftewel, het is onmogelijk om alles met een enkele database of analytics tool te analyseren.

Natuurlijk zijn er wel hybride vormen te bedenken zoals Snowflake, waarin je verschillende soorten data kan samenbrengen. Je kan dan gebruikmaken van de interne analyse tools, maar ook bekende BI-oplossingen zijn te koppelen met Snowflake.

Alles aan elkaar knopen

Uit deze keynote blijkt dat AWS goed heeft gekeken wat het de beste manier vindt om data toegankelijker te maken voor analyses. De conclusie is dat het de verschillende dataplatformen beter met elkaar laat integreren. AWS zag bij veel klanten dat er pipelines werden gebouwd tussen bijvoorbeeld Amazon Aurora en Amazon Redshift, of tussen Apache Spark en Amazon Redshift. Dat hoeft nu niet meer, want AWS heeft hier nu out-of-the-box integraties voor ontwikkeld zodat data in realtime gedeeld kan worden.

Tegelijk maakt AWS Amazon Athena, een eenvoudige analytics applicatie waarmee je op basis van SQL analyses kan doen, beschikbaar voor Apache Spark.

De weg wordt vrijgemaakt om zo eenvoudig mogelijk data analyses te doen en te zorgen dat organisaties echt kunnen gaan bouwen op basis van data. Daarmee wordt data mission critical, iets wat Redshift nog niet was in onze optiek.

Data is mission critical dus Redshift nu ook

Een andere belangrijke aankondiging is dat Redshift nu ook beschikbaar komt in een multi-az variant. Oftewel in meerdere availability zones met automatische failover. Als een complete regio onderuit gaat blijft de data beschikbaar vanuit een andere regio (availability zone). Voorheen moesten bedrijven backups van Redshift in andere regio’s opslaan en die beschikbaar maken bij storingen of problemen. Dat kost echter enkele minuten. Voor sommige organisaties die op de datatrein zijn gesprongen duurt dat veel te lang.

80 procent van de data is unstructured of semi-structured en vereist ML om te ontginnen

Sivasubramanian laat weten dat 80 procent van de data wereldwijd ongestructureerd is, of deels gestructureerd. De data is in elk geval niet direct te gebruiken in een database omdat het afbeeldingen zijn of documenten waarin de informatie nog verstopt zit. Om hier betrouwbare data van te maken moeten organisaties machine learning inzetten.

Hier komt het bekende Amazon SageMaker om de hoek kijken. Hiermee kunnen bedrijven zelf modellen maken, trainen en gebruiken om analyses te doen op ongestructureerde data om er vervolgens gestructureerde data van te maken.

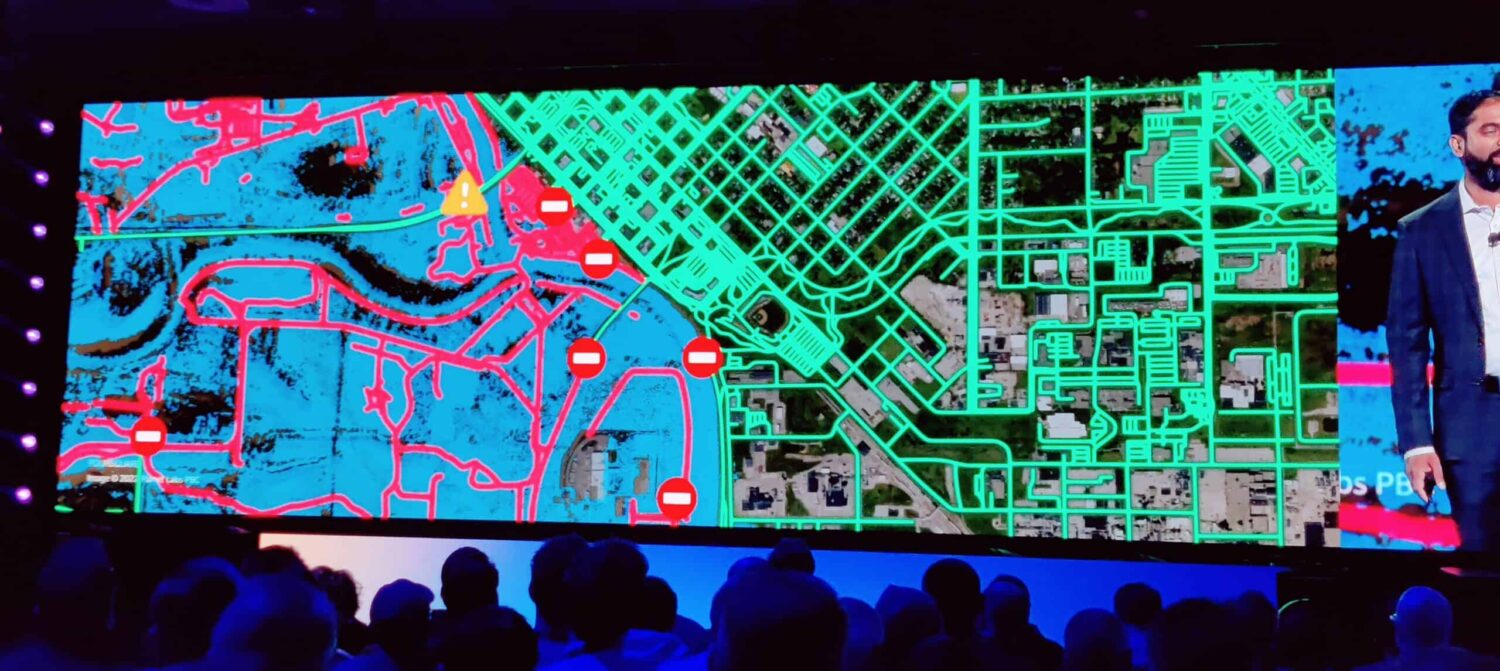

Amazon SageMaker is een van de meest succesvolle oplossingen van AWS. Als uitbreiding op SageMaker introduceert Sivasubramanian nu ook ondersteuning voor Geospatial ML, wat machine learning modellen op geografische kaarten mogelijk maakt. Handig voor organisaties die steden moeten plannen of actie moeten ondernemen bij natuurrampen. Ook heeft AWS enkele standaard ML-modellen ontwikkeld die je los kan laten op geografische kaarten, bijvoorbeeld om wegen te detecteren op satellietbeelden. Bij een grote overstroming kan vervolgens met machine learning worden bepaald welke wegen nog wel begaanbaar zijn en welke niet.

Kwaliteit en verversing waarborgen

Als organisatie kan je nu een centraal mission critical data lake onderhouden in Amazon Redshift. Je kan zoals eerder vermeld deze ook automatisch bijwerken door de connecties en integraties met Amazon Aurora en Apache Spark. Echter moet je de kwaliteit van de data niet uit het oog verliezen. Om hier ook controle op uit te oefenen introduceert AWS nu AWS Glue Data Quality.

Binnen AWS Glue Data Quality kan je regels opstellen waar nieuwe (inkomende) data minimaal aan moet voldoen. Verder kan het systeem waarschuwingen geven als de instroom van data terugloopt doordat de kwaliteitseisen mogelijk te hoog zijn of de aangeleverde informatie simpelweg tekort schiet. Als organisatie kan je dan je inkomende datastromen nakijken en verbeteren of mogelijk de eisen aanpassen waaraan de data moet voldoen.

Het verversen en toevoegen van data wil je waar mogelijk zoveel mogelijk automatiseren. Een van de manieren waarop je dat kan doen is middels Amazon Redshift auto-copy from S3. Een oplossing die werd gepresenteerd op re:Invent. Je kan applicaties die data aanleveren bijvoorbeeld elke 24 uur een export laten plaatsen in een S3-bucket, via deze nieuwe auto-copy tool wordt de data dan automatisch geïmporteerd in je Redshift data lake.

Naast Amazon Redshift auto-copy from S3 werden er ook nog Amazon Sagemaker Data Wrangler en uitbreidingen op AppFlow gepresenteerd. Met SageMaker Data Wrangler kan je data van SaaS-oplossingen en derde partijen importeren voor machine learning. Met AppFlow kan je data van bekende SaaS-oplossingen voor sales en marketing importeren in verschillende AWS services. AWS presenteerde hier 40 nieuwe connectoren voor. Van Facebook Ads, Google Ads en LinkedIn Ads tot aan Google Analytics 4, ServiceNow, Slack en Snowflake.

De AWS data services verbinden honderden data bronnen op het web. Uiteindelijk met het doel om alle data van je organisatie samen te brengen in een datalake en analyses te kunnen doen binnen je datastrategie.

Data governance staat hoog op de agenda

Het beveiligen van data staat bij menig organisatie hoger op de agenda. Niet alleen omdat er strengere regelgeving is, ook omdat het uitlekken van data niet goed is voor je imago. Organisaties zijn daarom vaak al druk bezig met een datastrategie rondom governance en compliance. Ze willen overzicht krijgen in hun data en wie er allemaal toegang heeft tot bepaalde data.

AWS springt hier nu op in met enkele nieuwe oplossingen. Zo presenteerde het bedrijf Amazon GuardDuty RDS Protection, een tool om data in Aurora te beschermen met Intelligent Threath Detection. Hierbij wordt machine learning ingezet om verdachte activiteiten te detecteren en te stoppen.

Voor Redshift introduceert AWS nu Centralized Access Controls for Redshift Data Sharing. Hierbij kan je centraal regelen wie er toegang heft tot Redshift data. Dit kan tot op kolom rij-level worden ingesteld door gebruik te maken van AWS Lake Formation.

Ook voor SageMaker introduceert AWS nu Amazon SageMaker ML Governance. Met de tool kan je instellen wie waar rechten toe heeft, met als doel governance maar ook audits te kunnen voorzien van de juiste informatie.

Amazon DataZone

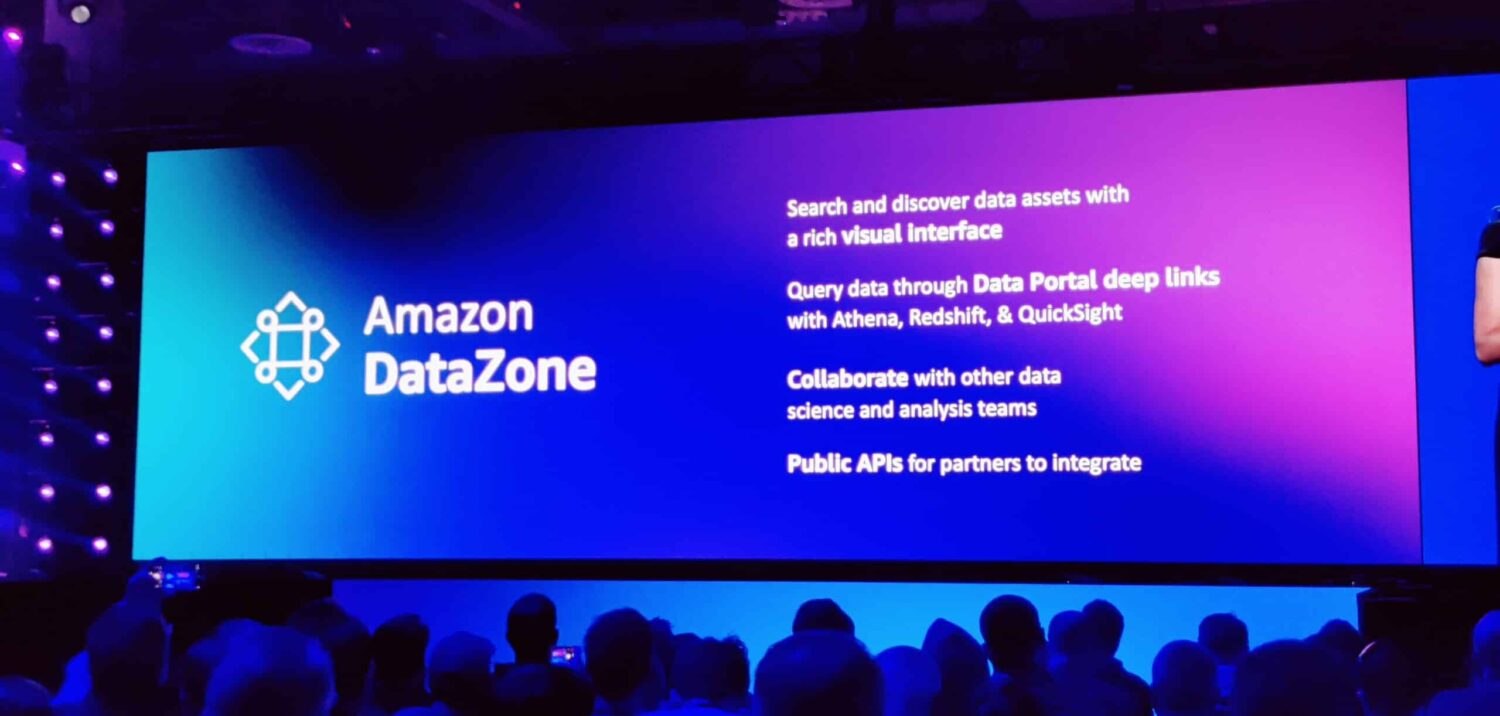

Tot slot is er Amazon DataZone waar we gisteren ook al over berichtten. Hierin kan je als organisatie een catalogus aanmaken om vast te leggen welke data je hebt en uit welke kolommen die bestaat. Ook kunnen er koppelingen worden gelegd met de databron. Vervolgens kunnen andere medewerkers in het bedrijf zoeken in de catalogus en voor bepaalde projecten of doeleinden toegang vragen tot die datasets. Zodat er bijvoorbeeld een marketing campagne gedaan kan worden op die data.

Hierbij dient dan ook een project aangemaakt te worden binnen DataZone, bijvoorbeeld voor wie er toegang wil en waarvoor de data gebruikt gaat worden. Op die manier heb je in DataZone een compleet overzicht van alle data en de gebruikersdoelen.

DataZone is ook API-driven, zodat data direct kan worden opgehaald bij Amazon DataZone, wat mogelijk is door de directe koppelingen met de databronnen. DataZone gebruikt veel machine learning om die koppelingen te leggen en om complexe kolomnamen om te zetten in leesbare velden voor mensen die op zoek zijn in de catalogus. Zo wordt sales_mgr bijvoorbeeld omgezet in Sales Manager.

Conclusie

We zijn dit jaar voor de vijfde keer op AWS re:Invent. We kunnen concluderen dat AWS in al die jaren flink wat werk heeft gestoken in het ontwikkelen van databases, analytics tools en machine learning. Voor het ontwikkelen van je datastrategie heeft AWS in principe alles in huis, maar laten we wel wezen: het is niet heel eenvoudig. Wij zouden altijd aanraden een specialist in de arm te nemen om je hierbij te helpen.

Organisaties die helemaal vanaf nul hun datastrategie willen vormgeven en opbouwen kunnen dit in AWS doen. Er zijn echter flink wat AWS-oplossingen die een rol kunnen spelen en het is lastig om die allemaal zelf te verkennen. Daarom het advies met een partner te werken die zich heeft verdiept. Die kan je ook helpen om sneller tot resultaat te komen wat onderaan de streep mogelijk goedkoper is dan zelf op onderzoek uitgaan. Daarnaast biedt AWS de nodige zaken out-of-the-box en heeft het standaard ML-modellen die je kan gebruiken, maar het is zeker geen specialist in bijvoorbeeld HR, sales, service of marketing. Voor dat soort doeleinden kan je beter uitwijken naar een SaaS-specialist. Een valkuil is dat sommige organisaties het wiel opnieuw willen uitvinden.

Wij denken dat organisaties die hun klantervaring of salestraject willen verbeteren met data beter af zijn door eerst stappen te zetten met een specialist op dat gebied. Bijvoorbeeld Salesforce om de sales, service en marketing data te optimaliseren en te gebruiken voor een betere klantervaring. Of Workday om een betere ervaring aan werknemers te bieden. Goede sales-analyses en voorspellingen kan Salesforce je out-of-the-box leveren, waarom zou je die zelf ontwikkelen?

Wat maakt jouw organisatie uniek? Welke data heb jij waar je machine learning op kan toepassen om nog efficiënter of beter te worden? AWS heeft flink wat use cases waar je lering uit kan trekken. Of het nou gaat om een organisatie in de maakindustrie of een agrarische onderneming die met IoT-sensoren aan de slag gaat, je kan specifieke data verzamelen.

Uiteindelijk moet je vooraf goed nadenken over het doel van je data lake. Wat moet je data lake opleveren? Welke vragen moet je data lake kunnen beantwoorden? Simpelweg heel veel data verzamelen levert niets op, behalve een hoge rekening. Daarna moet je je ook nog de vraag stellen of het verstandig is om dat zelf te gaan analyseren. Misschien zijn er specialisten die dit veel beter en goedkoper kunnen. Je moet vooral zelf machine learning-modellen ontwikkelen en data analyseren waar je zelf de meeste kennis en ervaring in hebt en dus ook data van hebt.

Uiteindelijk hou je dan een aantal use cases over die interessant zijn en waarvoor je een datastrategie kan ontwikkelen, maar ook een flink aantal waarvoor je beter een specialist in de arm kunt nemen. Mocht die sales of HR-data van zo’n SaaS-specialist alsnog toegevoegde waarde kunnen bieden naast de data die je zelf hebt verzameld, dan kan je die altijd nog gewoon importeren in Redshift om verbanden te legen en analyses te doen.

We zijn het met Sivasubramanian eens dat data aan de grondslag ligt van moderne innovatie, maar er komt wel het nodige bij kijken.

Lees ook: AWS toont veel machtsvertoon tijdens openingskeynote re:Invent 22