Nvidia-CEO Jensen Huang weet maar al te goed hoe lucratief de AI-hype voor zijn bedrijf is. Maar de innovaties met dank aan kunstmatige intelligentie zijn zeker niet te ontkennen. Volgens Huang is de innovatie dermate impactvol dat we voortaan moeten spreken over ‘software 3.0’. Wat houdt dat in?

Het is niet al te gek om te denken: “3.0? Waar was 2.0? En wat is überhaupt software 1.0?” Immers mag je aannemen dat er in de lange geschiedenis van software harde breekpunten moeten zijn geweest om met een geheel nieuwe versienaam te komen.

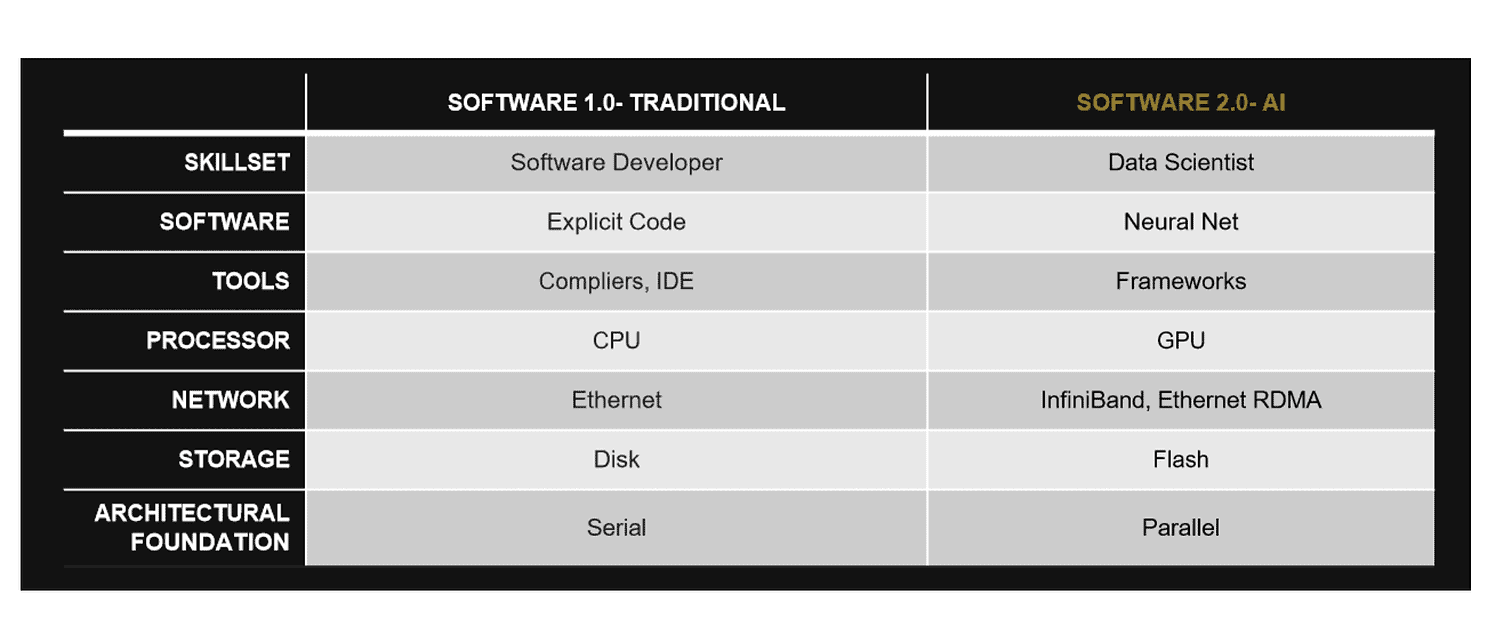

Om daar opheldering over te geven, moeten we erkennen dat deze terminologie alleen in een historisch perspectief werkt. Daarom moeten we beginnen bij software 2.0, dat een aantal jaar geleden in trek kwam. Bij Techzine kwamen we het in 2018 tegen in gesprek met Marco Bal, nog altijd werkzaam bij Pure Storage. Destijds legde hij uit dat het fundamentele verschil tussen 1.0 en 2.0 in de toepassing van AI zit. Daar waar conventionele programmeermethodes veel handwerk waren en met name afhingen van de capaciteiten van de CPU, definieerde Bal 2.0 als een ontwikkeling die de GPU centraal plaatst. Dit omdat de data-explosie die deze eeuw heeft plaatsgevonden, het noodzakelijk maakt om er via abstractie chocola van te maken. Met hulp van AI kunnen programmeerders zinnige inzichten halen uit data en zonder allemaal extra lijnen code tot een oplossing komen.

Software 3.0: 2.0 in een nieuw jasje?

Enter software 3.0, waar AI wederom centraal staat. Wat is nou het verschil? Huang vindt de term nodig omdat het creëren en draaien van applicaties zo simpel gaat zijn als een paar woorden in te voeren in een universele AI-vertaler, met alleen het selecteren van een geschikt AI-model als obstakel. “Dat is de heruitvinding van de hele stack. De processor is anders, het besturingssysteem is anders, de large language model is anders. De manier waarop je AI-applicaties schrijft is anders… Software 3.0, je hoeft het helemaal niet te coderen,” stelde hij tijdens een fireside chat bij Snowflake Summit.

Tip: Tijdens Summit 2023 breidt Snowflake de basis voor data-apps fors uit

Om even terug te komen op ons item in 2018 waar de term software 2.0 langskwam, zien we dat hierbij een specifieke verschuiving van capaciteiten, hardware-vereisten en tools plaatsvond. Pure Storage verschaf ons destijds van dit overzicht:

Wat dan opvalt aan de uitleg van Huang, is dat het toch best wat overeenkomsten kent met de uitleg van software 2.0. Zo staat data nu centraal in het bedrijfsleven en bij overheidsinstanties. Denk maar aan de klantgegevens die de ontwerpen van webwinkels aansturen, de verkeerspatronen die de bouw van nieuwe wegen informeren, ga zo maar door. Dit alles is steeds beter te monitoren en steeds moeilijker te overzien. Vandaar dat data-science boven software-development geplaatst wordt en parallelisatie het stokje overneemt van opeenvolgende werkprocessen. Alles moet tegelijk verwerkt worden, en het liefst op dezelfde manier.

Maar dat was al het geval bij software 2.0, dat steeds meer een realiteit is geworden. Software-developers zetten massaal AI in. GPU’s zijn niet aan te slepen bij Nvidia. SSD’s zijn inmiddels zeer betaalbaar en HDD’s worden langzaamaan uitgefaseerd. Veel is dus al op gang gekomen. Maar de doorslaggevende factor die software 3.0 een ander iets maakt dan 2.0, is het feit dat de expertise-vereisten zullen verminderen. Huang heeft het over toekomstmuziek en heeft er een handje van om pocherige teksten te verkondigen over de capaciteiten van zijn producten. Toch is het zeker zo dat de huidige generatieve AI-oplossingen op den duur kunnen uitgroeien tot een zeer capabele vervanging van software-development zoals we het nu kennen. Over de tijdspanne moeten we alleen niet al te overhaast zijn.

Expertise

De laatste tijd zien we dat er sinds de ChatGPT-hype een stap is gezet naar zeer specifieke toepassingen van generatieve AI, die assistentie kunnen bieden binnen een bepaalde applicatie. Voorbeelden zijn er genoeg, van security-hulpjes bij CrowdStrike tot data-analyse bij Salesforce. Deze toepassingen gaan nu al minder expertise eisen van de gebruikers. Dat wil niet zeggen dat de engineers bij deze bedrijven hun baan wordt ontnomen, maar dat de tools voor hun taken gedemocratiseerd wordt.

Nvidia is gebaat bij deze verandering, omdat het de hardware bezit die van essentie is bij een AI-afhankelijke IT-aanpak. Dat betekent echter niet dat het slechts componenten blijft leveren. Het wil met partner Snowflake bijvoorbeeld ook helpen aan de veiligheid van LLM’s en zich daarmee meer op software richten. Met de GPU als kern van de nieuwe vorm van computing, is Nvidia daarmee ambitieus. Immers hebben Intel en AMD weliswaar software geproduceerd, maar is hun businessmodel uiteindelijk afhankelijk geweest van de eigen CPU-hardware.

Beluister ook onze podcast over de machtspositie van Nvidia tijdens deze AI-explosie: