Nvidia heeft vandaag de nieuwste AI-GPU aangekondigd: de B200. Voor het eerst maakt het bedrijf gebruik van twee chips op een enkele videokaart voor dit topmodel.

Nvidia-CEO Jensen Huang deed deze aankondiging tijdens de keynote van het eigen GTC-evenement, dat deze week in San Jose plaatsvindt. Het chipontwerp heeft als codenaam “Blackwell” en geldt als de architecturele opvolger van Hopper, dat de H100-chip aandrijft. Het is gebakken op TSMC’s 4 nanometerproces en is twee keer zo groot als diens voorganger. De beloofde snelheidsverbetering van de B200 (twee samengevoegde B100’s) ten opzichte van de H100 is 30x, waarbij Huang zich specifiek richtte op AI-inferencing (het genereren van informatie door LLM’s).

Blackwell-ecosysteem

Deze nieuwe “AI-superchip” bevat 208 miljard transistoren. Echter was de nadruk van Huang niet zozeer op de processor zelf, maar op de schaalbaarheid van de nieuwe architectuur. Zo kunnen bedrijven met een aantal H100-chips deze vervangen binnen bestaande vormfactoren met de B200. Een variant die de Nvidia-CEO liet zien, bevatte twee B200’s en een Grace CPU. De 192GB aan HBM3e-geheugen is toegankelijk voor alle onderdelen van de hardware, waardoor de opgesplitste aard ervan geen latency zou moeten introduceren.

Voorbij de specificaties zelf heeft Nvidia een aantal nieuwe features geïntroduceerd. Zo kan de chip voortdurend bepaalde berekeningen vereenvoudigen waar mogelijk, zodat AI-training aanzienlijk sneller verloopt dan voorheen. Het is een belangrijke stap, aangezien het trainingsproces van LLM’s meerdere weken kan duren en innovatie op AI-gebied daardoor inperkt. De zogeheten “RAS-engine” functioneert als een veiligheidscheck die fungeert als “on-board tester” voor de AI-berekeningen. Daarnaast bieden security-opties de mogelijkheid om data te versleutelen at rest, in transit en tijdens berekeningen.

Tip: Stoot Groq Nvidia van de AI-troon met de LPU?

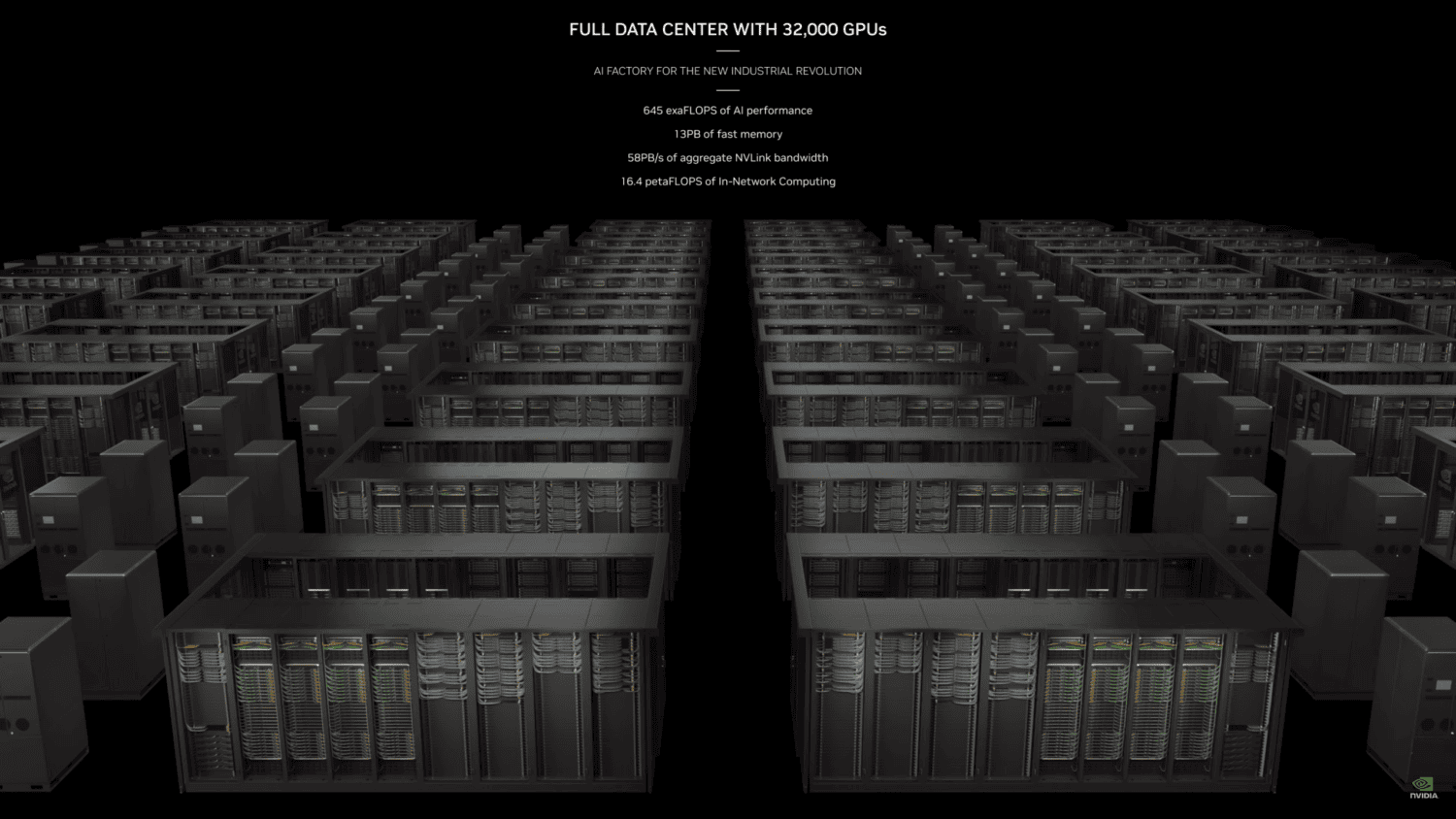

Een nieuwe NVLink Switch-chip zorgt ervoor dat meerdere B200’s met elkaar communiceren alsof ze een enkele GPU zijn. In een DGX-systeem levert het 22x de trainingssnelheid van een enkele H100 en 45x de inferencing-snelheid. Het vereist 2 liters aan vloeistof per seconde en verwarmt dit van 25 graden Celsius naar 45 graden. Omdat het aantal vereiste GPU’s voor dezelfde rekenkracht als voorheen een stuk kleiner is, stelt Huang dat het trainen van nieuwe AI-modellen aanzienlijk zuiniger zal zijn dan tot nu toe het geval was.

Nadruk op accelerated computing

Een belangrijke term die Huang tijdens de GTC-keynote bezigde, was accelerated computing. “General computing is niet meer van deze tijd, accelerated computing is de toekomst,” aldus de Nvidia-CEO. Het is het paradepaardje van Nvidia, een term die aanduidt dat er voor specifieke workloads meer dan enkel een krachtige CPU nodig is. GPU’s met tienduizenden cores kunnen AI-berekeningen razendsnel verwerken; het is de reden dat Nvidia, niet Intel, AMD of een andere partij, als verreweg de meest vooraanstaande GPU-speler zo van de AI-opmars heeft kunnen profiteren.

En beschikbaarheid?

Het is maar de vraag of Nvidia aan de reusachtige vraag kan voldoen van deze AI-chips. Wegens de geavanceerde packaging-technologie van TSMC valt niet direct te verwachten dat de yield rate al te hoog is, ofwel het percentage chips dat aan de strenge hardware-eisen voldoet na de productie ervan. Echter lijkt alles te moeten wijken voor de snelste AI-acceleratie die momenteel mogelijk is.

De aankondiging van de Blackwell vindt bijzonder vroeg plaats. Immers zijn zelfs de ‘refresh’ van de H100, de H200, en de zogeheten GH200 “Superchip” nog niet eens verschenen.

Ook nadruk op software

Tijdens de GTC-keynote besteedde Huang eveneens veel aandacht aan software-ontwikkeling. Op dat gebied tracht Nvidia onder meer het eigen Omniverse aan te jagen, een cloudplatform gericht op de ontwikkeling, deployment en management van 3D-applicaties. Dat platform dient het bouwen van digital twins mogelijk te maken, waarbij Nvidia (hernieuwde) partnerships aanhaalt van Ansys, Synopsys en Cadence.

Lees ook: H200: Nvidia’s nieuwste AI-chip met 141GB aan supersnel geheugen