Cloudera introduceert zes nieuwe accelerators die klanten, in combinatie met het eigen data, analytics en het Cloudera AI–platform, kunnen inzetten om de ontwikkeling van machine learning (ML)-projecten te versnellen. Doel hiervan is de zogenoemde time-to-value van deze zakelijke AI-toepassingen te verkorten.

Cloudera wil bedrijven helpen sneller de meeste waarde te halen uit hun zakelijke AI-projecten. Dit door zijn klanten te voorzien van de nieuwste AI-technieken en use-cases, waarmee zij de integratie van AI in hun processen verder kunnen vormgeven en ondersteunen. Zodat dit uiteindelijk meer impactvolle resultaten oplevert.

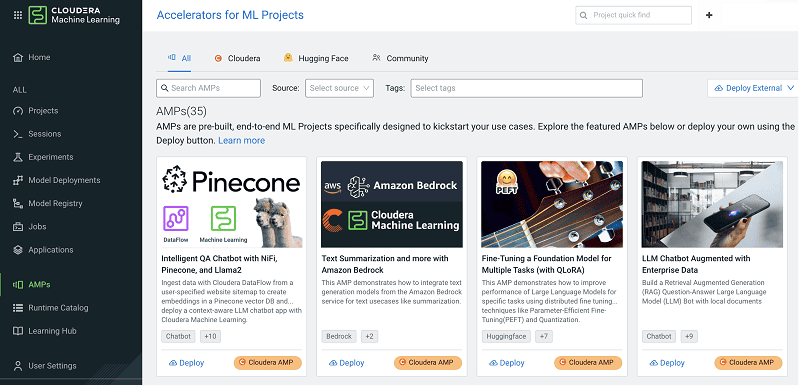

Hiervoor worden nu verschillende nieuwe accelerators voor ML-projecten, AMP’s, geïntroduceerd. Deze AMP’s zijn in essentie complete op ML-gebaseerde projecten die zeer eenvoudig vanuit het Cloudera-platform binnen de eigen omgevingen van bedrijven kunnen worden geïmplementeerd.

Best practices

Een AMP bevat onder meer best practices voor het aanpakken van complexe ML-projecten. Deze best practices bestaan uit workflows die naadloze transities mogelijk maken, ongeacht waar klanten deze voorbeelden of data willen inzetten.

Cloudera AMP’s zijn volledig open-source en bevatten ook de juiste instructies voor de implementatie in elke omgeving.

Zes nieuwe AMP’s

De nu uitgebrachte AMP’s moeten uiteindelijk de mogelijkheden van Cloudera AI toegankelijker maken, zodat eindgebruikers de adoptie ervan kunnen versnellen en daarbij de waarde van de eigen data en de gegenereerde AI-output zoveel mogelijk kunnen benutten.

De eerste AMP die Cloudera nu introduceert is Fine-Tuning Studio. Deze toepassing moet eindgebruikers een compleet ‘ecosysteem’ bieden voor het beheren, optimaliseren en evalueren van LLM’s.

De AMP RAG with Knowledge Graph helpt een op Retrieval Augmented Generation (RAG-gebaseerde applicatie te voeden met kennisgrafieken. Dit om beter relaties en context vast te leggen die niet makkelijk via alleen vector stores toegankelijk zijn.

Daarnaast biedt de PromptBrew AMP hulp voor het maken van goed presterende en betrouwbare prompts. Dit alles via een gebruiksvriendelijke interface. De ook geïntroduceerde Document Analysis with Cohere CommandR and FAISS AMP toont RAG met CommandR als LLM en FAISS als vectoropslag.

Tot slot helpt de Chat with Your Document AMP of accelerator met het verbeteren van de reacties van een LLM. Dit met behulp van context uit een interne kennisbank waarin de gebruiker persoonlijke documenten kan opslaan. Deze AMP bouwt daarbij voort op de eerdere LLM Chatbot Augmented with Enterprise Data AMP die Cloudera heeft uitgebracht.

De nieuwe AMP’s kunnen worden gedownload via de eigen Cloudera GitHub-omgeving.