Nvidia is de voornaamste profiteur van de AI-hype van dit jaar. Tijdens SIGGRAPH te Los Angeles bleek dat de GPU-producent het aanbod alleen maar aansterkt. Een nieuw serverproduct, verbeteringen aan de eigen GH200 Superchip en software-innovaties passeren de revue.

Nvidia-CEO Jensen Huang is een van de meest enthousiaste AI-evangelisten in de industrie, zeker nu zijn bedrijf de gok om erop in te zetten in veelvoud terugverdiend heeft. Het bedrijf ontwikkelde voor de GPU-lijn van 2018 een aantal innovaties zoals DLSS (Deep-Learning Super Sampling), dat een fors AI-gedeelte afdwong op de geleverde siliciumchips.

Eigenlijk is het bedrijf al sinds de oprichting bezig met accelerated computing, maar kreeg het decennialang alleen voet aan de grond in de gaming-markt. Dat veranderde geleidelijk en in de afgelopen 10 jaar heeft het een 90 procent marktaandeel in de datacentermarkt weten te realiseren. Nu die wereld vol is geraakt van de AI-hype, heeft het zijn slag andermaal kunnen doen.

Ada Lovelace-architectuur

De focusverlegging van Nvidia van gaming naar enterprise is al langer bezig, maar AI heeft het in een stroomversnelling gebracht. Nooit was dat zo duidelijk als nu: de nieuwe L40S-GPU’s zijn namelijk gebakken met de Ada Lovelace-architectuur, dat tot nu toe vooral bekend is uit de RTX 40-series games-GPU’s. Klaarblijkelijk zet het bedrijf ook deze chips liever in voor de enterprise-markt, en kunnen klanten met de nieuwe OVX-servers tot wel 8 van deze L40S-kaarten erin plaatsen, elk met 48GB aan videogeheugen en 1,45 petaflops aan tensor-processing vermogen. Tensor-processing is van cruciaal belang voor AI-workloads.

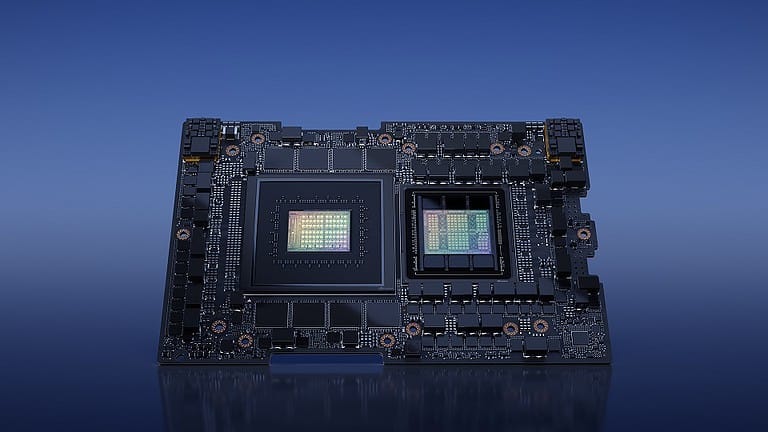

Ook kreeg de GH200 Superchip een verbeterde spec-sheet. Deze CPU-GPU-combinatie is een AI-supercomputer en was al bekendgemaakt, maar nu is duidelijk dat er gebruik gemaakt gaat worden van HBM3e-geheugen. Aangezien AI enorm profiteert van grote hoeveelheden snel geheugen is het een logische ontwikkeling van het platform.

Software: AI Workbench

Nvidia brengt eveneens innovaties op software-gebied: binnen de AI Enterprise-lijn vindt er een upgrade plaats met AI Workbench. Het is een doe-het-zelf kit om AI te ontwikkelen en aan te passen, compleet met vooraf getrainde modellen. Het doet denken aan de onlangs aangekondigde samenwerking tussen IBM en Meta, waarbij het LLaMA 2-model van laatstgenoemde binnen IBM watsonx.ai te kiezen is.

Lees ook: IBM-klanten kunnen aan de slag met Meta’s LLaMA 2-model

Met deze aankondigingen laat Nvidia zien hoe het gebruik wil maken van zijn AI-koppositie. Het is nog steeds de vraag of het kan voldoen aan de reusachtige vraag. Een week geleden spraken industrie-insiders over de roddelpraat rondom wie de nieuwste felbegeerde Nvidia H100-GPU’s zou ontvangen, en hoeveel. Het zou weleens kunnen bepalen hoe lang het duurt voordat we bijvoorbeeld GPT-5 zien van OpenAI of andere generatieve AI-innovaties.