Cisco heeft een nieuw open-source project gepresenteerd dat moet helpen om door AI gegenereerde code veiliger te maken. Het initiatief, onder de naam Project CodeGuard, biedt een raamwerk waarmee ontwikkelteams beveiligingsregels direct kunnen integreren in de workflow van AI-codeertools. Denk aan GitHub Copilot, Cursor en Windsurf.

AI-codeeragents worden wereldwijd steeds vaker ingezet om softwareontwikkeling te versnellen en productiviteit te verhogen. Tegelijkertijd blijkt dat de beveiliging van de gegenereerde code vaak tekortschiet. Volgens Cisco ontbreekt het regelmatig aan basisbescherming, zoals invoervalidatie en veilig geheimbeheer. Ook zouden veel AI-systemen gebruikmaken van verouderde cryptografie of afhankelijk zijn van componenten die niet langer worden ondersteund.

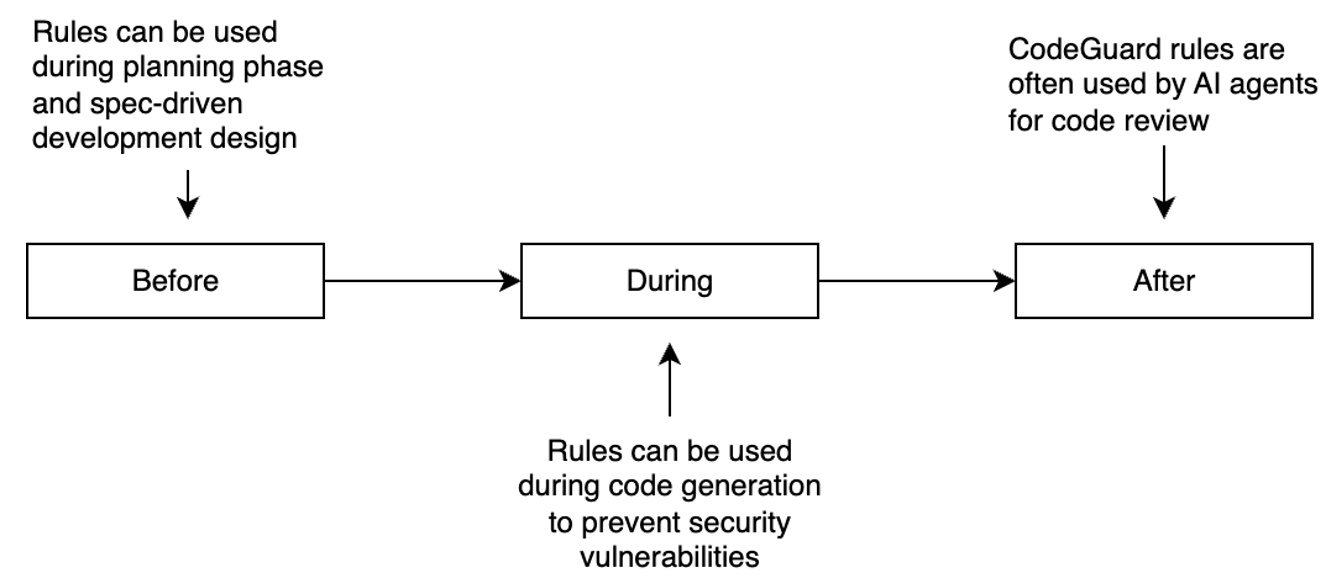

Project CodeGuard moet daar verandering in brengen. Cisco omschrijft het raamwerk als unified en model-onafhankelijk. Dit betekent dat het kan samenwerken met verschillende AI-systemen en ontwikkelomgevingen. Het framework is ontworpen om beveiliging in te bouwen in meerdere fasen van de softwarelevenscyclus, zodat de beschermingsregels zowel vóór, tijdens als na het genereren van code actief zijn.

Het raamwerk bevat een reeks beveiligingsregels die AI-modellen automatisch aansturen richting veiligere programmeerpatronen. Deze regels kunnen al tijdens de ontwerpfase van software worden toegepast, maar ook tijdens en na de codegeneratie.

Beveiliging tijdens complete ontwikkelproces

Daardoor kunnen ontwikkelteams beveiliging inbouwen tijdens het hele ontwikkelproces. Dus niet pas achteraf bij een code-review. Cisco benadrukt dat dit essentieel is. Dit, omdat AI-assistenten tegenwoordig niet alleen code schrijven, maar ook ontwerpen opstellen, services genereren en verbeteringen voorstellen.

Een voorbeeld is een regel die invoervalidatie afdwingt. Die kan een model al tijdens het schrijven van code aanzetten tot veilige invoerbehandeling, potentieel onveilige gebruikersinput markeren en controleren of validatie en sanitisatie correct zijn geïmplementeerd in de uiteindelijke code. Andere regels helpen voorkomen dat AI hardgecodeerde wachtwoorden of API-sleutels genereert.

De eerste versie van CodeGuard bevat een kernset van beveiligingsregels gebaseerd op industriestandaarden. Voorbeelden zijn OWASP (Open Worldwide Application Security Project) en CWE (Common Weakness Enumeration). Daarmee richt Cisco zich specifiek op het tegengaan van veelvoorkomende kwetsbaarheden, waaronder hardgecodeerde geheimen, ontbrekende invoervalidatie, verouderde cryptografische methoden en afhankelijkheden van end-of-life software.

Cisco benadrukt dat Project CodeGuard bedoeld is als extra verdedigingslaag, niet als garantie voor volledig veilige code. Ontwikkelaars moeten nog steeds reguliere beveiligingspraktijken toepassen, zoals peer reviews en handmatige controles. Het doel is om de kans aanzienlijk te verkleinen dat voor de hand liggende kwetsbaarheden ongemerkt in productie terechtkomen, terwijl de snelheid en efficiëntie van AI-codering behouden blijven.

De eerste release, CodeGuard v1.0.0, biedt naast de basisregels ook tools waarmee de regels automatisch vertaald kunnen worden naar verschillende AI-platformen. Zo kunnen ze eenvoudig worden geïntegreerd in bestaande ontwikkelomgevingen. Cisco stelt dat dit slechts het begin is: toekomstige versies zullen de dekking over meer programmeertalen uitbreiden, extra AI-codeertools ondersteunen en automatische validatie van regels toevoegen.

Het bedrijf roept de community op om bij te dragen aan het project. Beveiligingsingenieurs, softwareontwikkelaars en AI-onderzoekers kunnen nieuwe regels indienen, vertalers bouwen of feedback geven via de publieke GitHub-repository. Het uiteindelijke doel is om van veilig AI-coderen de standaard te maken, zonder dat dit ten koste gaat van snelheid en innovatie.