Is de toekomst van AI-ontwikkeling open of gesloten? Zowel Intel als Nvidia hebben die vraag inmiddels beantwoord, zij het met tegenovergestelde visies.

Ontwikkelaars maken veelal gebruik van TensorFlow, een AI-platform dat oorspronkelijk door het Google Brain-team is ontwikkeld. Alles van dataverzameling tot training en inferencing is via dit platform te regelen. Voor de beste prestaties is het belangrijk om AI-workloads op GPU’s te draaien, die talloze berekeningen met duizenden cores tegelijk kunnen afronden. Idealiter zou TensorFlow een soort ‘AI-Zwitserland’ moeten zijn, waarbij eindgebruikers de optimale ondersteuning krijgen onafhankelijk van de hardware die ze kiezen.

Nvidia-GPU’s worden echter verreweg het best ondersteund. Zo werkt TensorFlow naadloos samen met CUDA en cuDNN, respectievelijk de API en library om Nvidia-hardware optimaal te laten draaien. Het zijn closed-source oplossingen die afhankelijk zijn van een expliciete integratie. Compatibiliteit met Intel is te realiseren via de open-source Intel Extension for TensorFlow, terwijl AMD-gebruikers via het tevens open-source ROCm pas later ondersteuning ontvangen voor de nieuwste versie.

Het is één voorbeeld van vele: Nvidia geniet nagenoeg altijd de beste ondersteuning voor GPU-acceleratie. Voor AI-workloads, die momenteel verreweg het snelst draaien op GPU’s, geldt hetzelfde. Dat komt grotendeels doordat het al sinds 2006 aan CUDA werkt, een API voor GPU-acceleratie. Het geldt de facto als standaard in de software-industrie voor deze soort workloads en is exclusief aan Nvidia. Omdat jarenlang geen enkele andere vendor zich al te druk maakte om deze tak van sport, is de GPU-machtspositie van Nvidia enorm in de datacenterwereld.

Nvidia AI: een gesloten platform voor iedereen

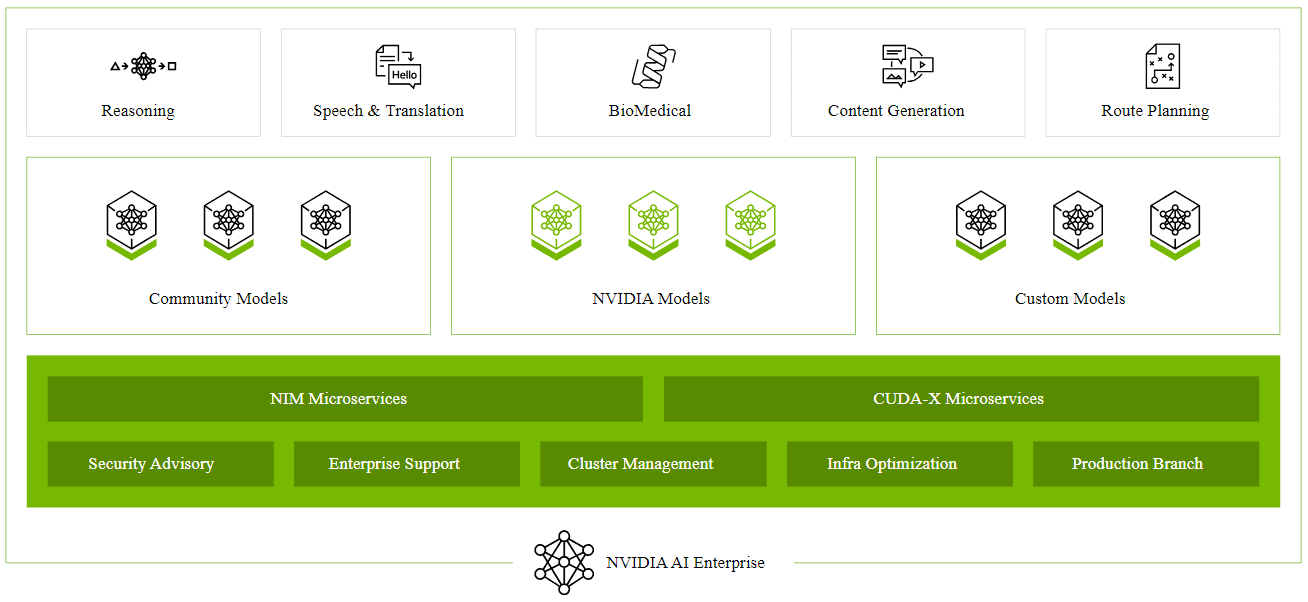

Nvidia heeft echter grootschaligere plannen dan alleen integraties met anderen. Het bedrijf omschrijft het eigen Nvidia AI Enterprise als het ‘besturingssysteem’ voor zakelijke AI. Er is toegang tot community-modellen, custom-varianten en Nvidia’s zelf ontwikkelde modellen. Voor generatieve AI-doeleinden zijn er chatbots te realiseren, te fine-tunen en veilig te houden via een uitgebreide set aan microservices.

Hoewel organisaties ruim baan krijgen om gepartnerde diensten in te zetten, probeert Nvidia klanten steeds verder naar een holistische oplossing op eigen kracht te duwen. Daarmee zou het steeds aantrekkelijker moeten klinken om een geheel serverpark om te bouwen naar ‘AI-fabrieken‘, zoals Nvidia-CEO Jensen Huang het ambieert. Momenteel kunnen alleen de allergrootste techbedrijven een dergelijke investering overwegen, waardoor klanten via een clouddienst aan de slag kunnen.

AI-ontwikkelaars kunnen gratis proeven aan Nvidia AI Enterprise, maar volgens AWS is de gemiddelde prijs voor vaste klanten iets meer dan 100 dollar per uur per instance. Daarvoor krijgen organisaties toegang tot een breed pakket aan diensten. Zo zijn foundation models via Nvidia NeMo te trainen voor specifieke doeleinden, is er voortdurende monitoring van security en zijn er voor allerlei AI-toepassingen gerichte frameworks en tools.

Het voordeel voor klanten: ze hoeven maar bij één partij aan te kloppen om al hun zaken te regelen. Daarmee volgt een bedrijf de visie die Nvidia nastreeft (of ‘het perspectief‘, zoals CEO Huang het zou noemen). Uiteindelijk moet er binnen het AI-platform van Nvidia zelfs ruimte zijn voor gebruikers om in doodgewoon Engels te programmeren. Het nadeel: lock-in, gegarandeerd hoge prijzen en waarschijnlijk lange wachttijden voor de nieuwste hardware.

Het tegenwicht van Intel en co

Toen de nieuwe Gaudi 3-chip gepresenteerd werd tijdens Intel Vision deze week, sprak het bedrijf over het ‘meest vooraanstaande AI-alternatief’. Men is zich volkomen bewust van de outsiderrol die elke partij ten opzichte van Nvidia heeft. Toch denkt Intel een troef te hebben gevonden, zeker voor op de lange termijn. CEO Pat Gelsinger benadrukte in een conference call na zijn Vision-keynote dat AI op open basis moet worden ontwikkeld. Hij gelooft dat klanten dat ook zoeken. Het gebruik van bestaande standaarden, gratis API’s en open-source toolkits biedt de ruimte om te kiezen voor andere partijen om AI te accelereren.

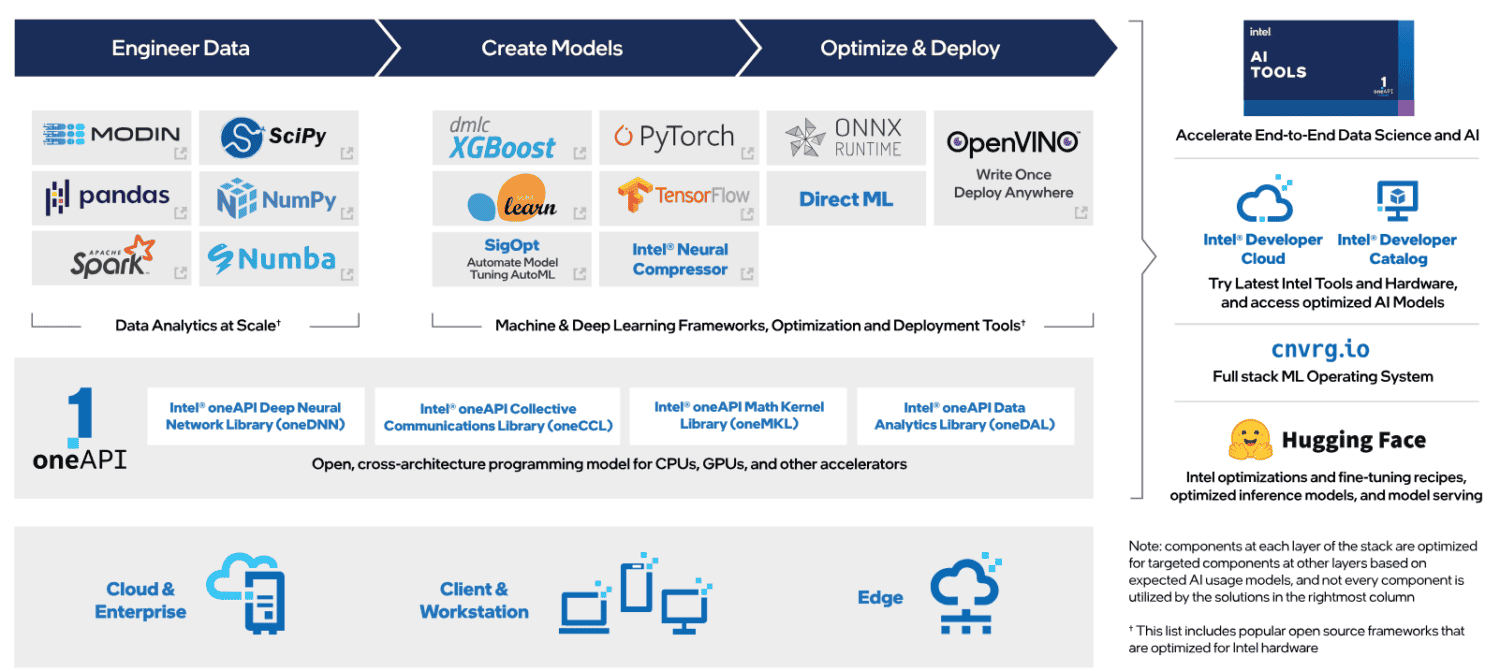

Centraal bij deze implementatie is de oneAPI-toolkit, mede ontwikkeld door Intel in 2019 maar niet exclusief voor dat bedrijf. Het is expliciet bedacht als CUDA-alternatief. In een interview met VentureBeat verduidelijkte Sachin Katti, SVP Network & Edge Group bij Intel, wat het voordeel is van deze aanpak. “In tegenstelling tot CUDA zitten oneAPI en oneDNN van Intel (…) in UXL van de Linux Foundation. Het is volledig open-source. Meerdere bedrijven dragen eraan bij. Er zijn geen restricties op het gebruik ervan. Het is niet gebonden aan specifieke hardware. Het kan gebruikt worden met veel verschillende stukjes hardware. Er zijn meerdere ecosysteemspelers die eraan bijdragen.”

Kortom, oneAPI biedt de vrijheid die Nvidia weigert te verschaffen voor CUDA. Sterker nog, oneAPI ondersteunt ook Nvidia-chips. Daarbovenop kan het gebruikmaken van de AI-functionaliteit van CPU’s, die weliswaar veel trager zijn dan GPU’s maar voor AI-workloads zonder hoge snelheidseisen best geschikt blijken.

Intels positie hierin is niet puur altruïstisch: het probeert als AI-uitdager alle instrumenten die het heeft in te zetten om de strijd aan te gaan met Nvidia. Het betekent dat servers met Intel Xeons al ingezet kunnen worden voor AI-ontwikkeling, terwijl een upgrade naar Intel-GPU’s vervolgens vlekkeloos zou moeten verlopen. De OpenVINO-toolkit, ontwikkeld door Intel, kiest namelijk automatisch de meest geschikte hardware die beschikbaar is binnen een computeromgeving.

Niemand houdt van afhankelijkheid

Op korte termijn zal er weinig veranderen aan de machtspositie van Nvidia. Ontwikkelaars zijn eraan gewend en de enige echte restricties zijn de beperkte beschikbaarheid van de hardware en de daaraan gerelateerde torenhoge prijzen. Zowat elk aan AI verbonden software-pakket biedt optimalisaties voor Nvidia. Momenteel zijn de alternatieven nog te jong en hebben partijen als Intel en AMD te weinig marktaandeel in het GPU-segment voor datacenters om een vuist te maken. Toch kan het tij keren.

Allereerst werken oneAPI, openVINO en AMD’s ROCm ook op Nvidia-chips. Ten tweede dragen de hyperscalers AWS, Microsoft en Google Cloud bij aan een gegeneraliseerd AI-aanbod dat allerlei hardware kan ondersteunen. Ook zij hebben er geen baat bij om Nvidia’s machtspositie onaangetast te houden. Partijen als Databricks, die hun eigen rol in het AI-ontwikkelproces hopen te behouden, sluiten inmiddels niet alleen partnerships met Nvidia maar ook met Intel. Hoe meer bedrijven deze interoperabiliteit aanjagen, hoe meer keuze klanten krijgen om de tools te kiezen die zij willen gebruiken.

Lees ook: Microsoft ziet meer kansen voor AI in VK en opent AI-hub in Londen