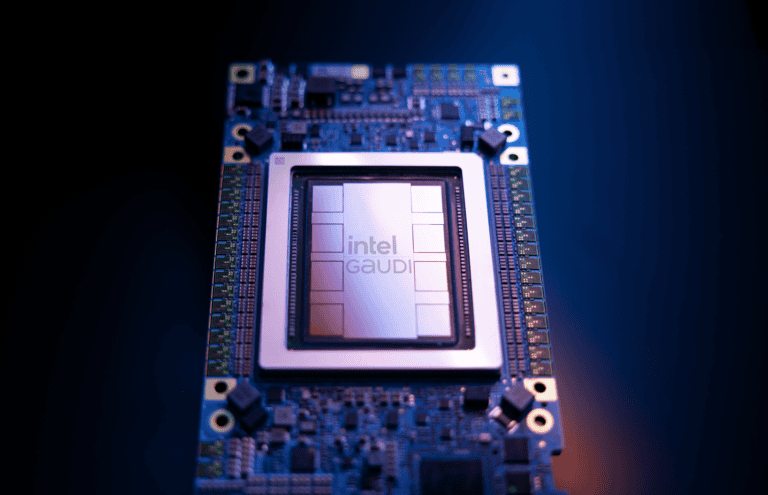

Intel heeft zojuist de Gaudi 3 AI-chip onthuld. Met deze datacenter-GPU positioneert het bedrijf zich als het voornaamste alternatief voor Nvidia om AI-workloads zo snel mogelijk af te ronden.

Ten opzichte van de Gaudi 2 biedt het nieuwste model aanzienlijke prestatieverbeteringen, ondanks dat de architectuur vergelijkbaar is. AI-berekeningen draaien twee keer zo snel op FP8-precisie, terwijl ze zelfs vier keer zo snel zijn voor accuratere BF16-workloads. De bandbreedte voor networking (2x) en geheugen (1,5x) is tevens fors toegenomen.

Goedkoper alternatief

Het zijn veelbelovende cijfers voor de Gaudi 3, terwijl diens voorganger al goede papieren had. Nvidia-chips waren weliswaar een stuk sneller in AI-benchmarks, maar het prijskaartje van deze GPU’s lag niet in verhouding met de prestatiewinst. Kortom: Intel gold al als een relatief betaalbaar AI-alternatief met kortere wachttijden voor bestelde servers. Dat zal naar verwachting niet veranderen nu Nvidia beschikt over de Blackwell-serie aan GPU’s en Intel Gaudi 3 dit jaar naar voren schuift.

Intel vergelijkt Gaudi 3 meermaals met de Nvidia H100. Een enkele Gaudi 3 traint Meta’s Llama 2-model 50 procent sneller, hetzelfde prestatieverschil als voor inferencing. Ten opzichte van de H200, het opgewaardeerde model van de H100, is de inferencing-winst 30 procent.

Hoewel de architectuur niet is veranderd, is het chipproces dat wel: in plaats van een 7 nanometer-procedé bouwt Intel Gaudi 3 op 5 nanometer. Desondanks is het stukje silicium op de pcb alsnog groter. Elke Gaudi 3 bestaat namelijk uit een tweetal gekoppelde ’tiles’, frappant genoeg precies dezelfde architecturele keuze als bij Nvidia voor de Blackwell-serie. De overeenkomsten zijn groter dan dat: de interconnect is net als bij Nvidia snel genoeg om de GPU’s te laten opereren als één chip.

Om de twee chips zit 128 GB aan High-Bandwidth Memory (HBM2e), dat het mogelijk maakt om grotere AI-modellen zonder prestatieverlies te draaien. Het nieuwe 3,7 TB per seconde aan bandbreedte op; veel sneller dan Nvidia’s H100, maar minder dan de helft van het HBM3e-geheugen in de nieuwe B200 (8 TB/s).

Open versus proprietary

Een deel van de Intel-boodschap rond AI draait niet om de hardware-prestaties. Het bedrijf pleit voor open standaarden om AI aan te jagen, in tegenstelling tot het ondersteunen van exclusieve tools. Dit is een sneer naar Nvidia, dat een geheel software-ecosysteem om CUDA heeft gebouwd. Vertaallagen zoals ZLUDA maken het mogelijk om voor CUDA ontwikkelde workloads elders te draaien, maar die doet Nvidia in de ban.

Veel ontwikkelaars zijn inmiddels gewend aan die werkwijze en kunnen daarbij vertrouwen op compatibiliteit met grofweg 90 procent van alle GPU’s in datacenters. Een open standaard zou een overstap naar concurrerende producten van Intel en AMD makkelijker maken. Wie TensorFlow of PyTorch gebruikt om AI te draaien, kan al wel naadloos overstappen naar een Gaudi 3-chip.

Intel schenkt veel aandacht aan de schaalbaarheid van Gaudi 3. Een enkele server node biedt 14,7 Petaflops, terwijl clusters met 1024 nodes 15 Exaflops aan theoretische prestaties te leveren hebben. Connectiviteit verloopt via Ethernet; Intel heeft hiervoor geen eigen alternatief voor Nvidia’s InfiniBand-techniek. Het betekent langzamere AI-training, maar bredere compatibiliteit voor serverparken. De discussie over welke soort oplossing gewenst is, is nog lang niet voorbij.

Lees ook: Nvidia verstevigt AI-koppositie bij GTC 2024 met Blackwell-GPU’s