GPT-4 zou als tool voor het moderen van content beter bepaalde taken uitvoeren dan mensen. Dit stelt GPT-4-ontwikkelaar OpenAI op basis van een interne test.

OpenAI voerde intern een onderzoek naar de verschillen tussen GPT-4 en menselijke contentmoderators. Daaruit bleek dat het leren van nieuwe contentmoderatieregels, het uitvoeren van deze regels en het halen van feedback om de regels aan te scherpen, flink sneller verloopt met behulp van GPT-4. In het geval van mensen kan moderatie enkele maanden duren, terwijl het AI-model de tijd terugdringt naar enkel uren, zo geeft OpenAI-aan.

Wel heeft het AI-model nog een beperking, het kan namelijk alleen beter moderen ten opzichte van menselijke moderators die een ‘lichte training’ kregen. Ervaren en zwaar getrainde menselijke moderators zijn nog altijd beter dan GPT-4.

Meerdere stappen

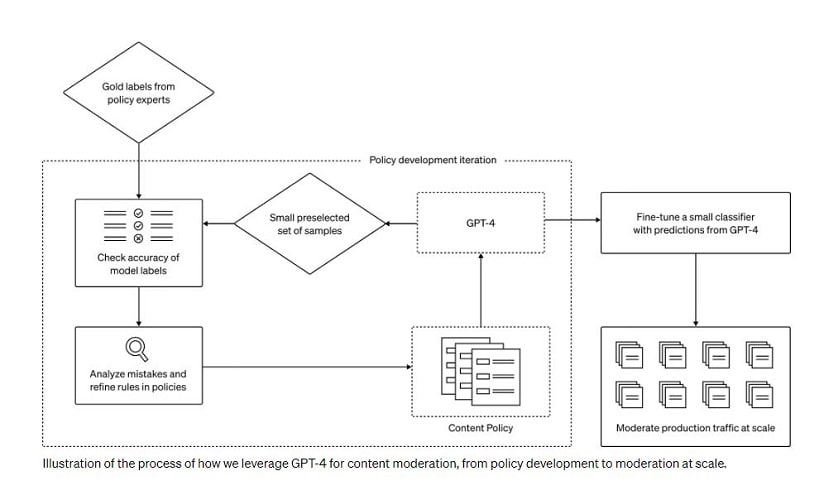

Het trainen van GPT-4 voor contentmoderatie omvat meerdere stappen. In de eerste plaats moet een dataset worden gemaakt waarin voorbeelden van schadelijke content staan. Hierna moet het AI-model worden geïnstrueerd ieder stukje schadelijke content te taggen met een label dat beschrijft waarom het in strijd is met de moderatieregels. Verder moeten de door GPT-4 gemaakte labels worden nagekeken op fouten en problemen.

Overige voordelen

Naast het sneller uitvoeren van moderatie, biedt GPT-4 ook de mogelijkheid de regels verder te definiëren en aan te scherpen. Wanneer het model een moderatiefout maakt, kan dit tekortkomingen in de moderatieregels aan het licht brengen. Bijvoorbeeld als deze te vaag zijn.

Iedereen die toegang heeft tot de GPT-4 API kan een contentmoderatiesysteem ontwikkelen op basis van de informatie uit het onderzoek.

Lees ook: OpenAI geeft model achter Bing Chat officieel uit om aandacht terug te winnen